词序和句法结构对句子含义有很大影响——即使词序发生微小变化也会完全改变解释。例如,考虑以下相关句子:

从纽约飞往佛罗里达的航班。

从纽约飞往佛罗里达的航班。

从佛罗里达飞往纽约的航班。

这三个句子都具有相同的词集。但是,1 和 2 具有相同的含义(称为释义对),而 1 和 3 的含义则大不相同(称为非释义对) 。识别对是否为释义的任务称为释义识别,这项任务对许多现实世界的自然语言理解 (NLU) 应用(例如问答)都很重要。也许令人惊讶的是,即使是像BERT这样最先进的模型,如果仅在现有的 NLU 数据集上进行训练,也无法正确识别许多非释义对(例如上述 1 和 3)之间的差异。这是因为现有数据集缺少这样的训练对,因此即使机器学习模型有能力理解复杂的上下文措辞,也很难学习这种模式。

为了解决这个问题,我们发布了两个新的数据集供研究界使用:英语的单词乱码(PAWS)的释义对手数据集和PAWS-X,后者是 PAWS 数据集的扩展,涵盖六种类型学上不同的语言:法语、西班牙语、德语、中文、日语和韩语。这两个数据集都包含格式良好且词汇重叠度高的句子对,其中大约一半的句子对是释义,其他则不是。在最先进模型的训练数据中加入新的句子对可以将其在这个问题上的准确率从<50% 提高到 85-90%。相反,没有捕获非本地上下文信息的模型即使有新的训练示例也会失败。因此,新数据集为衡量模型对词序和结构的敏感度提供了一种有效的工具。PAWS

数据集包含 108,463 个人工标记的英文句子对,来源于Quora 问题对(QQP)和维基百科页面。 PAWS-X 包含 23,659 个人工翻译的 PAWS 评估对和 296,406 个机器翻译的训练对。下表给出了数据集的详细统计信息。

PAWS PAWS-X

语言 英语 英语 中国人 法语 德语 日本人 韩国人 西班牙语

(QQP) (维基百科) (维基百科) (维基百科) (维基百科) (维基百科) (维基百科) (维基百科)

训练 11,988 79,798 49,401 † 49,401 † 49,401 † 49,401 † 49,401 † 49,401 †

开发 677 8,000 1,984 1,992 1,932 1,980 1,965 1,962

测试 - 8,000 1,975 1,985 1,967 1,946 1,972 1,999

† PAWS-X 的训练集是从英文 PAWS Wiki 数据集的一个子集机器翻译而来的。

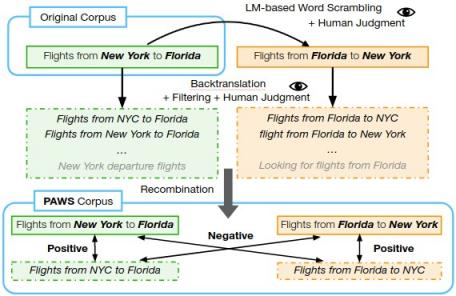

创建英文版 PAWS 数据

集 在“ PAWS:通过单词乱序生成释义对手”中,我们介绍了一种生成句子对的工作流程,这些句子对的单词重叠度较高,但在是否为释义方面保持平衡。为了生成示例,首先将源句子传递给专门的语言模型,该模型会创建单词交换变体,这些变体在语义上仍然有意义,但对于它们是否为释义对则不明确。然后由人类评分员判断这些句子的语法性,然后由多名评分员判断它们是否是彼此的释义。

PAWS 语料库创建工作流程。

这种交换策略的一个问题是,它往往会产生非释义的句子对(例如,“为什么好人会遭遇坏事” != “为什么坏人会遭遇好事”)。为了确保释义和非释义之间的平衡,我们添加了其他基于反向翻译的示例。反向翻译具有相反的偏见,因为它倾向于在改变词序和词汇选择的同时保留含义。这两种策略使 PAWS 整体上保持平衡,尤其是对于维基百科部分。

创建多语言 PAWS-X 数据集

创建 PAWS 后,我们将其扩展到另外六种语言:中文、法语、德语、韩语、日语和西班牙语。我们聘请了人工翻译来翻译开发和测试集,并使用神经机器翻译 (NMT) 服务来翻译训练集。

我们从 PAWS 开发集中随机抽取了六种语言的 4,000 个句子对样本(48,000 个翻译),获得了人工翻译(母语人士)。每对句子都独立呈现,因此翻译不受上下文影响。随机抽取的子集由第二名工作人员验证。最终数据集的单词级错误率小于 5%。

请注意,如果句子不完整或含糊不清,我们允许专业人员不翻译。平均而言,不到 2% 的句子对未翻译,我们只是将其排除在外。最终翻译的句子对随后被分成新的开发和测试集,每个约 2,000 对。

德语 (de) 和中文 (zh) 的人工翻译对的示例。

使用 PAWS 和 PAWS-X 进行语言理解

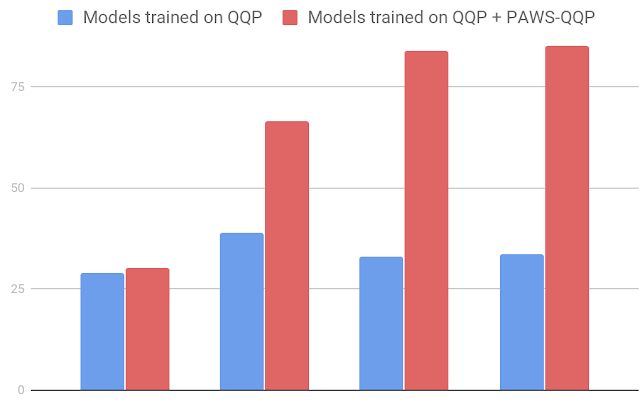

我们在创建的数据集上训练多个模型,并测量评估集上的分类准确率。使用 PAWS 进行训练时,强模型(例如BERT和DIIN )比在现有Quora 问题对(QQP) 数据集上训练时表现出显着的改进。例如,在来自 QQP 的 PAWS 数据 (PAWS-QQP) 上,如果使用现有 QQP 进行训练,BERT 的准确率仅为 33.5,但在给定 PAWS 训练示例时,准确率会恢复到 83.1。与 BERT 不同,简单的词袋(BOW) 模型无法从 PAWS 训练示例中学习,这表明其在捕捉非局部上下文信息方面很弱。这些结果表明 PAWS 可以有效地衡量模型对词序和结构的敏感度。

PAWS-QQP 评估集 (英文) 上的准确度。

下图展示了流行的多语言 BERT模型在 PAWS-X 上使用几种常见策略 的表现:

Zero Shot:该模型在 PAWS English 训练数据上进行训练,然后直接在所有其他数据上进行评估。此策略不涉及机器翻译。

翻译测试:使用英语训练数据训练模型,并将所有测试示例机器翻译成英语进行评估。

翻译训练:将英语训练数据机器翻译成各目标语言,为训练各模型提供数据。

合并:在所有语言上训练多语言模型,包括原始英语对和所有其他语言的机器翻译数据。

结果表明,跨语言技术有所帮助,同时也为推动释义识别问题的多语言研究留下了相当大的空间

使用 BERT 模型的 PAWS-X 测试集的准确度。

我们希望这些数据集对研究界有用,推动多语言模型的进一步发展,从而更好地利用结构、上下文和成对比较。

致谢

核心团队包括 Luheng He、Jason Baldridge 和 Chris Tar。我们要感谢 Google Research 的语言团队,特别是 Emily Pitler,感谢他们为我们的论文提供的深刻评论。还要感谢 Ashwin Kakarla、Henry Jicha 和 Mengmeng Niu 对注释的帮助。

评论