深度学习的成功很大程度上得益于算法的进步、并行处理硬件(GPU / TPU )以及ImageNet等大规模标记数据集的可用性等关键因素。然而,当标记数据稀缺时,训练神经网络以使其表现良好可能会很困难。在这种情况下,可以应用数据增强方法(例如,改写句子或旋转图像)来有效增加标记训练数据的数量。最近,在自然语言处理( NLP)、视觉和语音等多个领域的数据增强方法的设计方面取得了重大进展。不幸的是,数据增强通常仅限于监督学习,其中需要将标签从原始示例转移到增强示例。

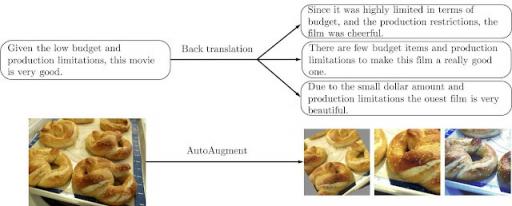

基于文本(顶部)或基于图像(底部)的训练数据的增强操作示例。

在我们最近的作品“用于一致性训练的无监督数据增强 (UDA) ”中,我们证明了人们也可以对未标记数据进行数据增强,以显著改善半监督学习(SSL)。我们的结果支持了最近半监督学习的复兴,表明:(1)SSL 可以匹敌甚至超越使用数量级更多标记数据的纯监督学习,(2)SSL 在文本和视觉领域都表现良好,(3)SSL 可以很好地与迁移学习结合,例如在从BERT进行微调时。我们还开放了我们的代码(github),供社区复制和构建。

无监督数据增强解释

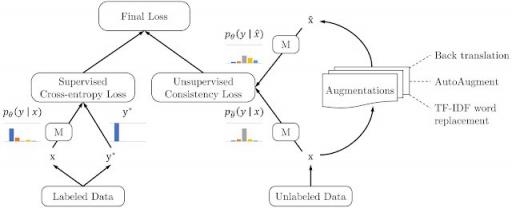

无监督数据增强 (UDA) 同时使用标记数据和未标记数据。要使用标记数据,它使用监督学习的标准方法计算损失函数来训练模型,如下图左侧所示。对于未标记数据,应用一致性训练来强制未标记示例和增强未标记示例的预测相似,如图右侧所示。在这里,将同一模型应用于未标记示例及其增强对应示例以产生两个模型预测,从中计算一致性损失(即两个预测分布之间的距离)。然后,UDA 通过联合优化来自标记数据的监督损失和来自未标记数据的无监督一致性损失来计算最终损失。

无监督数据增强 (UDA) 概述。左图:当有标记数据时,计算标准监督损失。右图:使用无标记数据,计算示例与其增强版本之间的一致性损失。

通过最小化一致性损失,UDA 允许标签信息从标记示例顺利传播到未标记示例。直观地,可以将 UDA 视为一个隐式迭代过程。首先,该模型依赖少量标记示例对一些未标记示例做出正确预测,然后通过一致性损失将标签信息传播到增强的示例。随着时间的推移,越来越多的未标记示例将被正确预测,这反映了模型泛化能力的提高。已经测试了各种其他类型的噪声以进行一致性训练(例如高斯噪声、对抗性噪声等),但我们发现数据增强在许多环境中都优于所有类型,从而在从语言到视觉的各种任务上实现最佳性能。UDA 根据手头的任务应用不同的现有增强方法,包括反向翻译、AutoAugment和TF-IDF词替换。NLP

和计算机视觉中的基准测试

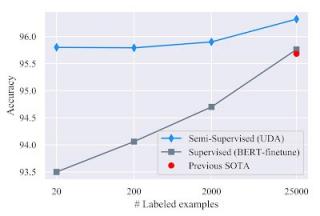

UDA 在低数据环境下出奇地有效。仅使用 20 个带标签的示例,UDA 便利用 50,000 个未带标签的示例在IMDb情绪分析任务中实现了 4.20 的错误率。这一结果优于之前使用 25,000 个带标签的示例训练的最先进的模型,错误率为 4.32。在大数据环境下,使用完整的训练集,UDA 也实现了强劲的收益。

在情绪分析任务IMDb 上进行基准测试。UDA 在不同训练规模的监督学习中超越了最先进的结果。

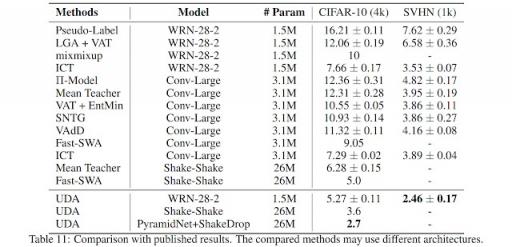

在CIFAR-10半监督学习基准上,UDA 的表现远超所有现有的 SSL 方法,例如VAT 和 ICT 。使用 4k 个示例,UDA 的错误率达到 5.27,与使用 50k 个示例的全监督模型的性能相当。此外,借助更先进的架构PyramidNet+ShakeDrop,UDA 实现了 2.7 的最新最佳错误率,与之前的最佳半监督结果相比,错误率降低了 45% 以上。在SVHN上,UDA 仅使用 1k 个标记示例就实现了 2.46 的错误率,与使用约 70k 个标记示例训练的全监督模型的性能相当。

CIFAR-10 和 SVHN 图像分类任务上的 SSL 基准。UDA 超越了现有的半监督学习方法。

在具有 10% 标记示例的ImageNet上,UDA 将 top-1(top-5)准确率从使用监督基线且没有未标记示例的 55.1%(77.3%)提高到使用 ImageNet 中所有图像作为未标记示例的 68.7%(88.5%)。在使用完全标记集和 130 万个额外未标记示例的高数据环境下,UDA 继续将准确率从 78.3%(94.4%)提高到 79.0%(94.5%)。

发布

我们发布了UDA 的代码库以及所有数据增强方法(例如使用预训练翻译模型进行反向翻译)以复制我们的结果。我们希望此发布将进一步推动半监督学习的发展。

致谢

特别感谢论文的共同作者 Zihang Dai、Eduard Hovy 和 Quoc V. Le。我们还要感谢 Hieu Pham、Adams Wei Yu、Zhilin Yang、Colin Raffel、Olga Wichrowska、Ekin Dogus Cubuk、Guokun Lai、Jiateng Xie、Yulun Du、Trieu Trinh、Ran Zhao、Ola Spyra、Brandon Yang、Daiyi Peng、Andrew Dai、Samy Bengio 和 Jeff Dean 对本项目的帮助。预印本可在线获取。此外,我们还想向读者推荐 Google Research 同事同时开发的其他半监督学习方法,例如 MixMatch 和 S4L,这些方法已显示出令人鼓舞的结果。我们感谢MixMatch和S4L

评论