提高神经网络性能并使其适应可用计算资源的常见做法是调整架构深度和宽度。事实上,包括EfficientNet、ResNet和Transformers在内的流行神经网络系列都由一组具有灵活深度和宽度的架构组成。然而,除了对准确性的影响之外,人们对这些架构设计的基本选择如何影响模型的理解有限,例如对其内部表示的影响。

在“广度和深度网络学习的是同样的东西吗?揭示神经网络表示如何随宽度和深度而变化”一文中,我们从隐藏表示和最终输出的角度对同一架构系列的广度和深度网络之间的相似性进行了系统研究。在非常宽或非常深的模型中,我们在其内部表示中发现了特征块结构,并建立了这种现象与模型过度参数化之间的联系。跨模型比较表明,没有块结构的模型在相应层的表示之间表现出显著的相似性,但包含块结构的模型表现出高度不同的表示。当在同一测试集上对广度和深度模型进行评估时,这些内部表示的属性反过来会转化为类和示例级别的系统性不同错误。

比较表征相似度与 CKA

我们利用之前开发的中心核对齐(CKA) 技术扩展了之前对表征分析的研究,该技术提供了一种稳健、可扩展的方法来确定任何一对神经网络层所学习到的表征之间的相似性。CKA 将来自两个层的表征(即激活矩阵)作为输入,并输出介于 0(完全不相似)和 1(相同表征)之间的相似度得分。

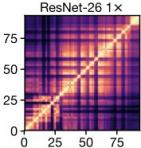

我们将 CKA 应用于一系列深度和宽度各异的ResNet,这些 ResNet 在常见基准数据集(CIFAR-10、CIFAR-100和ImageNet)上进行训练,并使用表征热图来说明结果。每个热图的x轴和y轴索引所考虑的模型的层,从输入到输出,每个条目 ( i , j ) 是层i和层j之间的 CKA 相似度得分。

我们使用 CKA 来计算单个模型内所有层对的表示相似度(即,当网络 1 和网络 2 相同时),以及跨模型(即,当网络 1 和网络 2 使用不同的随机初始化进行训练,或完全具有不同的架构时)。

下面是我们将深度为 26、宽度乘数为 1 的单个 ResNet 中每一层的表示与其他每一层的表示进行比较时得到的热图示例。在此处使用的设计惯例中,所述深度仅指网络中卷积层的数量,但我们会分析所有存在的层,宽度乘数适用于每个卷积中的过滤器数量。请注意热图中的棋盘格图案,这是由架构中的 跳过连接(层之间的快捷方式)引起的。

区块结构的出现

从更深或更宽的网络的表示热图中可以看出,出现了一大组具有高度相似表示的连续层,它们在热图中显示为黄色方块(即 CKA 分数较高的区域)。这种现象我们称之为块结构,它表明底层在逐步细化网络表示方面可能不如我们预期的那样有效。事实上,我们表明任务性能在块结构内部变得停滞不前,并且可以在不影响最终性能的情况下修剪一些底层。

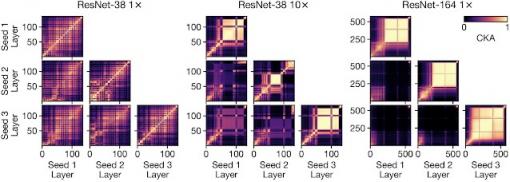

块结构(一组具有高度相似表示的大型连续层)会随着宽度或深度的增加而出现。每个热图面板都会显示单个神经网络中所有层对之间的 CKA 相似性。虽然块结构的大小和位置在不同的训练过程中可能会有所不同,但它是一种在较大模型中始终存在的稳健现象。

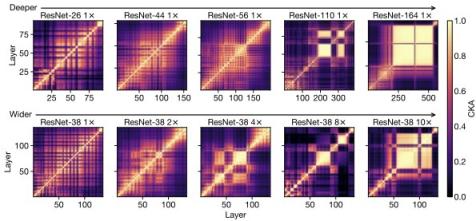

通过额外的实验,我们表明,块结构与绝对模型大小 的关系较小,而与模型相对于训练数据集大小的关系更大。随着我们减少训练数据集的大小,块结构开始出现在更浅、更窄的网络中:

随着网络宽度的增加(沿每行向右)和数据集大小的减小(每列向下),相对模型容量(相对于给定任务)有效地膨胀,并且块结构开始出现在较小的模型中。

通过进一步分析,我们还可以证明块结构源于其底层表示的主导主成分的保留和传播。有关更多详细信息, 请参阅我们的论文。

比较不同模型的表示

进一步研究了深度和宽度对不同随机初始化和不同架构的模型的表示的影响,并发现块结构的存在也对此产生了重大影响。尽管架构不同,但没有块结构的宽模型和深模型确实表现出彼此的表示相似性,其中相应的层在模型中大致具有相同的比例深度。但是,当存在块结构时,其表示对于每个模型都是唯一的。这表明,尽管具有相似的整体性能,但每个具有块结构的宽模型或深模型都会从输入到输出获得唯一的映射。

对于较小的模型(例如 ResNet-38 1×),不同初始化(对角线外)中的 CKA 与单个模型(对角线上)中的 CKA 非常相似。相比之下,更宽更深的模型(例如 ResNet-38 10×、ResNet-164 1×)的块结构内的表示在训练运行中高度不同。

宽度和深度模型的误差分析

在探索了广度和深度模型学习到的表示的属性之后,我们接下来要了解它们如何影响输出预测的多样性。我们训练不同架构的网络群体,并确定每种架构配置在哪些测试集示例上容易出错。

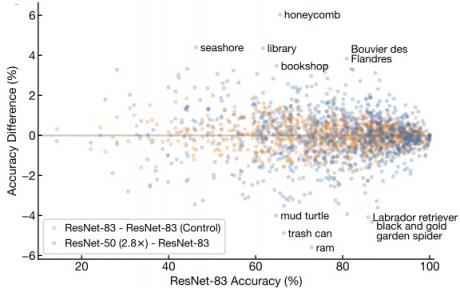

在 CIFAR-10 和 ImageNet 数据集上,具有相同平均准确率的广度和深度模型在示例级预测中仍然表现出统计上的显著差异。ImageNet 上的类别级误差也存在同样的观察结果,广度模型在识别与场景相对应的类别方面表现出较小的优势,而深度网络在消费品方面的准确率相对较高。

在 ImageNet 上,随着宽度( y轴)或深度(x轴)的增加,模型之间的每个类别差异。橙色圆点反映 ResNet-83 (1×) 的两组 50 个不同随机初始化之间的差异。

结论

在研究深度和宽度对内部表示的影响时,我们发现了一种块结构现象,并展示了它与模型容量的联系。我们还表明,宽度和深度模型在类别和示例级别表现出系统性的输出差异。查看论文以了解这些结果和更多见解的完整详情!我们对这些发现提出的许多有趣的未解决的问题感到兴奋,例如块结构在训练过程中是如何产生的,这种现象是否发生在图像分类以外的领域,以及这些关于内部表示的见解如何为模型效率和泛化提供信息。

致谢

这是与 Maithra Raghu 和 Simon Kornblith 合作完成的作品。我们感谢 Tom Small 对表示热图的可视化。

评论