强化学习(RL) 是一种顺序决策范式,用于训练智能代理处理复杂任务,例如机器人运动、玩视频游戏、驾驶平流层气球和设计硬件芯片。虽然 RL 代理在各种活动中都表现出了良好的效果,但很难将这些代理的能力转移到新任务上,即使这些任务在语义上是等效的。例如,考虑一个跳跃任务,其中一个从图像观察中学习的代理需要跳过一个障碍物。深度 RL 代理在这些任务中训练了几个具有不同障碍物位置的任务,但很难成功跳过以前从未见过的位置的障碍物。

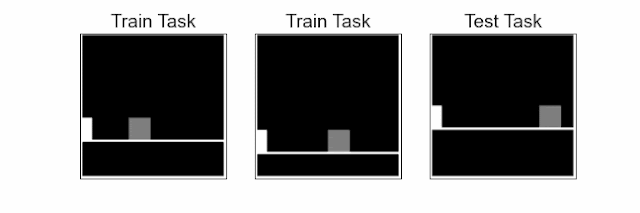

跳跃任务:从像素中学习的代理(白色方块)需要跳过障碍物(灰色方块)。挑战在于使用少量训练任务在测试任务中推广到未见过的障碍物位置和地板高度。在给定的任务中,代理需要精确地计算跳跃时间,在距离障碍物的特定距离处,否则它最终会撞上障碍物。

在ICLR 2021上作为焦点展示的 “强化学习中泛化的对比行为相似性嵌入”中,我们将强化学习的固有顺序结构融入到表征学习过程中,以增强在未见过的任务中的泛化能力。这与这项工作之前的主流方法正交,这些方法通常是从监督学习改编而来,因此在很大程度上忽略了顺序方面。我们的方法利用了这样一个事实:代理在执行具有相似底层机制的任务时,至少会表现出在这些任务中相似的短行为序列。

先前关于泛化的研究通常改编自监督学习,并围绕增强学习过程展开。这些方法很少利用序列方面的属性,例如跨时间观察的动作相似性。

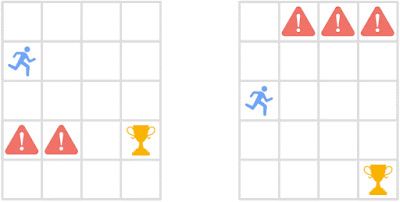

我们的方法训练代理学习一种表示,当代理在这些状态下的最佳行为与未来状态相似时,这些状态就接近。这种接近性概念,我们称之为行为相似性,可以推广到不同任务的观察中。为了衡量不同任务中状态之间的行为相似性(例如,跳跃任务中不同的障碍物位置),我们引入了策略相似性度量( PSM ) ,这是一种受双模拟启发的理论驱动的状态相似性度量。例如,下图显示代理在两个视觉上不同的状态下的未来动作是相同的,根据 PSM,这些状态相似。

了解行为相似性。代理(蓝色图标)需要在与危险保持距离的同时获得奖励。尽管初始状态在视觉上有所不同,但它们在当前状态以及当前状态之后的未来状态下的最佳行为是相似的。策略相似性度量 (PSM) 将高相似性分配给此类行为相似的状态,将低相似性分配给不相似的状态。

为了增强泛化能力,我们的方法学习状态嵌入,它对应于基于神经网络的任务状态表示,将行为相似的状态(如上图所示)聚集在一起,同时将行为不同的状态分开。为此,我们提出了对比度量嵌入(CME),利用对比学习的优势来学习基于状态相似性度量的表示。我们使用策略相似性度量 (PSM) 实例化对比嵌入,以学习策略相似性嵌入(PSE)。PSE 将相似的表示分配给在这些状态和未来状态下具有相似行为的状态,例如上图所示的两个初始状态。

如下图结果所示,PSE 显著增强了前面提到的像素跳跃任务的泛化能力,表现优于之前的方法。

方法 网格配置

“宽的” “狭窄的” “随机的”

正则化 17.2(2.2) 10.2(4.6) 9.3(5.4)

供电设备 33.6(10.0) 9.3(5.3) 37.7(10.4)

数据增强 50.7(24.2) 33.7(11.8) 71.3(15.6)

数据 8 月 +双模拟 41.4(17.6) 17.4(6.7) 33.4(15.6)

8 月数据 + PSE 87.0(10.1) 52.4(5.8) 83.4(10.1)

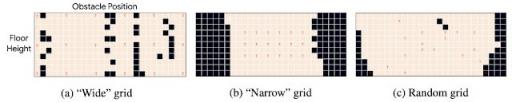

跳跃任务结果:使用不同方法(未使用和使用数据增强)解决的测试任务的百分比(%)。下图中显示的“宽”、“窄”和“随机”网格配置包含 18 个训练任务和 268 个测试任务。我们报告了使用不同随机初始化的 100 次运行的平均性能,括号中为标准差。

跳跃任务网格配置:可视化不同配置中数据增强的 PSE 平均性能。对于每个网格配置,高度沿 y 轴变化(11 个高度),而障碍物位置沿 x 轴变化(26 个位置)。红色字母电视表示训练任务。米色方块是PSE已解决的任务,黑色方块是未解决的任务,结合数据增强。

我们还通过使用UMAP(一种流行的高维数据可视化技术) 将 PSE 和基线方法学习到的表示投影到 2D 点,从而对它们进行可视化。如可视化所示,与之前的方法不同,PSE 将行为相似的状态聚集在一起,将不相似的状态分开。此外,PSE 将状态划分为两组:(1) 跳跃前的所有状态和 (2) 动作不影响结果的状态(跳跃后的状态)。

可视化学习到的表示。(a)跳跃任务中的最佳轨迹(可视化为不同颜色的块),具有不同的障碍物位置。具有相同数字标签的点对应于代理与障碍物之间的相同距离,这是各种跳跃任务中潜在的最佳不变特征。(b - d )我们使用UMAP将隐藏表示可视化,其中点的颜色表示相应观测的任务。(b)PSE 捕获了正确的不变特征,从具有相同数字标签的点聚集在一起可以看出。也就是说,在跳跃动作(编号块 2)之后,所有其他动作(非编号块)都相似,如重叠曲线所示。与 PSE 相反,包括(c)l2 损失嵌入(而不是对比损失)和(d)基于奖励的双模拟指标的基线不会将具有相似数字标签的行为相似状态放在一起。 ( c , d )的泛化能力较差,可能是由于具有相似最优行为的状态最终导致距离较远的嵌入。

结论

总体而言,这项研究展示了利用强化学习中的固有结构来学习有效表征的好处。具体来说,这项研究通过两项贡献推动了强化学习中的泛化:策略相似性度量和对比度量嵌入。PSE 结合了这两个想法来增强泛化。未来研究的令人兴奋的途径包括找到更好的方法来定义行为相似性并利用这种结构进行表征学习。

致谢

这是与 Pablo Samuel Castro、Marlos C. Machado 和 Marc G. Bellemare 合作完成的作品。我们还要感谢 David Ha、Ankit Anand、Alex Irpan、Rico Jonschkowski、Richard Song、Ofir Nachum、Dale Schuurmans、Aleksandra Faust 和 Dibya Ghosh 对本作品的深刻评论。

评论