强化学习(RL) 是机器学习的一个领域,专注于从经验中学习以解决决策任务。虽然 RL 领域取得了长足进步,在玩视频游戏、驾驶平流层气球和设计硬件芯片等复杂任务上取得了令人印象深刻的经验成果,但越来越 明显 的是,当前的经验评估标准可能会给人一种科学进步迅速的错觉,而实际上却减慢了科学进步的速度。

为此,在NeurIPS 2021的口头报告“统计悬崖边缘的深度强化学习”中,我们讨论了如何考虑结果的统计不确定性,尤其是在仅使用少量训练运行的情况下,以使深度强化学习的评估可靠。具体而言,报告点估计的主要做法忽略了这种不确定性并阻碍了结果的可重复性。与此相关的是,通常报告的每项任务得分表在少数任务之外可能会让人不知所措,并且通常会忽略标准差。此外,简单的性能指标(如平均值)可能受少数异常任务的影响,而即使多达一半的任务的性能得分为零,中位数得分也不会受到影响。因此,为了提高该领域对报告的少量运行结果的信心,我们提出了各种统计工具,包括分层引导置信区间、性能概况和更好的指标,例如四分位均值和改进概率。为了帮助研究人员利用这些工具,我们还发布了一个易于使用的 Python 库RLiable和一个快速入门 colab。

RL 评估中的统计不确定性

强化学习的实证研究依赖于评估各种任务(例如Atari 2600 视频游戏)的表现,以评估进展。深度强化学习基准测试的已发布结果通常比较跨任务汇总的平均分和中位数的点估计。这些分数通常相对于某些定义的基线和最佳表现(例如,分别是 Atari 游戏中的随机代理和“平均”人类表现),以使不同任务之间的分数具有可比性。

在大多数 RL 实验中,从不同训练运行中获得的分数具有随机性,因此仅报告点估计值并不能揭示是否会通过新的独立运行获得类似的结果。训练运行次数少,再加上深度 RL 算法性能的高度 可变性 ,通常会导致此类点估计值中存在很大的统计不确定性。

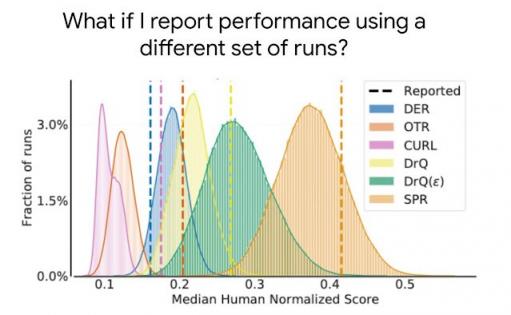

这是最近发布的五种算法( DER、OTR、CURL 、 DrQ的两个变体和SPR )在包含 26 款游戏的Atari 100k基准测试中的中位人类标准化得分分布。如虚线所示,基于出版物中的几次运行而报告的中位得分点估计未提供有关中位得分变化的信息,并且通常会高估(例如, CURL、SPR、DrQ)或低估(例如, DER)预期中位数,从而导致错误的结论。

随着基准测试变得越来越复杂,由于解决此类任务所需的计算和数据量增加,评估多次运行将变得越来越困难。例如,对 50 款 Atari 游戏进行 5 次运行,获得 2 亿帧需要 1000 多个 GPU 天。因此,评估更多运行并不是减少计算要求高的基准测试的统计不确定性的可行解决方案。虽然先前的 研究建议使用统计显着性检验作为解决方案,但此类检验本质上是二分法的(“显着”或“不显着”),因此它们通常缺乏产生有意义见解所需的粒度,并且被广泛误解。

多年来强化学习论文中的运行次数。从Arcade 学习环境(ALE) 开始,向计算要求高的基准的转变导致了对每个任务仅评估少量运行的做法,这增加了点估计的统计不确定性。

可靠评估的工具

任何基于有限运行次数的总体指标都是随机变量,因此考虑到这一点,我们主张报告分层引导 置信区间(CI),这些置信区间可以预测如果重复同一实验并进行不同运行,总体指标的可能值。这些 CI 使我们能够了解结果的统计不确定性和可重复性。此类 CI 使用跨任务组合运行的分数。例如,对包含 26 个任务的Atari 100k进行 3 次运行评估,将得到 78 个用于不确定性估计的样本分数。

在每个任务中,彩色球表示不同运行的得分。要使用百分位数法计算统计引导 CI ,引导样本是通过从每个任务中按比例随机抽取替换得分来创建的。然后,这些样本上的总得分分布是引导分布,其围绕中心的分布为我们提供了置信区间。

大多数深度 RL 算法通常在某些任务和训练运行中表现更好,但总体性能指标可以掩盖这种变化,如下所示。

数据外观各异,但总体统计数字相同。资料来源:相同的统计数据,不同的图表。

相反,我们推荐使用性能配置文件,它通常用于比较优化软件的求解时间。这些配置文件使用分层引导置信带绘制所有运行和任务的分数分布,并带有不确定性估计。这些图显示了所有任务的总运行次数,这些任务的得分高于阈值(𝝉),是阈值的函数。

表现概况对应于所有任务中运行得分的经验尾部分布。阴影区域显示 95% 分层引导置信带。

此类概况可以一目了然地进行定性比较。例如,一种算法的曲线高于另一种算法意味着一种算法比另一种算法更好。我们还可以读取任何分数百分位数,例如,概况在中位数分数处与 y = 0.5(上方的虚线)相交。此外,概况下的面积对应于平均分数。

虽然性能概况对于定性比较很有用,但算法很少在所有任务上都胜过其他算法,因此它们的概况经常相交,所以更精细的定量比较需要综合性能指标。然而,现有的指标有局限性:(1)单个高性能任务可能主导任务平均得分,而(2)任务中位数不受近一半任务的零分影响,并且需要大量的训练运行才能解决较小的统计不确定性。为了解决上述限制,我们推荐两种基于稳健统计数据的替代方案:四分位均值(IQM) 和最优性差距,这两者都可以理解为下面的性能概况下的区域。

IQM(红色)对应于性能概况下方的区域(以蓝色显示),位于 x 轴上 25 和 75 百分位分数之间。最优性差距(黄色)对应于概况和 y = 1(人类表现)水平线之间的区域,分数小于 1。

作为中位数和平均值的替代,IQM 对应于所有任务中中间 50% 的运行结果的平均得分。它比平均值更能抵抗异常值,比中位数更能指示整体性能,并且 CI 更小,因此需要更少的运行次数即可获得改进。另一种替代平均值的方法是最优性差距,它衡量算法与最佳性能之间的差距。

IQM 丢弃组合得分(彩球)的最低 25% 和最高 25% 并计算剩余 50% 得分的平均值。

为了直接比较两种算法,需要考虑的另一个指标是平均改进概率,它描述了改进的可能性,无论改进程度如何。该指标使用Mann-Whitney U 统计量计算,在各个任务中取平均值。

重新评估评估

使用上述评估工具,我们重新审视了广泛使用的强化学习基准上现有算法的性能评估,揭示了先前评估中的不一致之处。例如,在Arcade Learning Environment (ALE)(一种广为认可的强化学习基准)中,算法的性能排名会根据综合指标的选择而变化。由于性能概况可以反映整体情况,因此它们通常可以说明为什么存在这种不一致。

中位数(左)和 IQM(右)是 ALE 上的人类标准化分数,是训练期间看到的环境帧数量的函数。IQM 产生的 CI 明显小于中位数分数。

在流行的连续控制基准DM Control上,大多数算法的平均归一化分数的 95% CI 存在很大的重叠。

DM Control Suite 结果,在 100k 和 500k 步基准上对六项任务取平均值。由于分数是使用最大性能进行归一化的,因此平均分数对应于 1 减去最优性差距。算法的排序基于其声称的相对性能 — 除了 Dreamer 之外,所有算法都声称比排在其下面的至少一个算法有所改进。阴影区域显示 95% CI。

最后,在用于评估RL 泛化的基准Procgen上,改进的平均概率表明,一些声称的改进只有 50-70% 的可能性,这表明一些报告的改进可能是虚假的。

假设算法 X 被认为优于算法 Y,则每行显示左侧算法 X 优于右侧算法 Y 的概率。阴影区域表示 95% 分层引导 CI。

结论

我们对广泛使用的深度强化学习基准的发现表明,统计问题可能会对之前报告的结果产生很大影响。在这项工作中,我们重新审视评估,以改进对报告结果的解释并标准化实验报告。我们想强调发表的论文提供所有运行结果的重要性,以便将来进行统计分析。为了对您的结果充满信心,请查看我们的开源库RLiable和quickstart colab。

致谢

这项工作是与 Max Schwarzer、Aaron Courville 和 Marc G. Bellemare 合作完成的。我们要感谢 Tom Small 为本文提供的动画人物。我们也非常感谢 Google Research、Brain Team 和 DeepMind 的几位成员的反馈。

评论