近年来,扩大语言模型的规模已被证明是提高一系列自然语言处理 (NLP) 任务性能的可靠方法。当今规模达 100B 或更多参数的语言模型即使在没有或只有很少的训练示例的情况下,也能在情感分析和机器翻译等任务上取得优异表现。然而,即使是最大的语言模型,在某些多步骤推理任务(如数学应用题和常识推理)中仍会遇到困难。我们如何才能让语言模型执行这样的推理任务?

在“思路链提示引出大型语言模型中的推理”中,我们探索了一种用于提高语言模型推理能力的提示方法。这种方法称为思路链提示,它使模型能够将多步骤问题分解为中间步骤。借助思路链提示,足够规模(约 100B 个参数)的语言模型可以解决标准提示方法无法解决的复杂推理问题。

与标准提示的比较

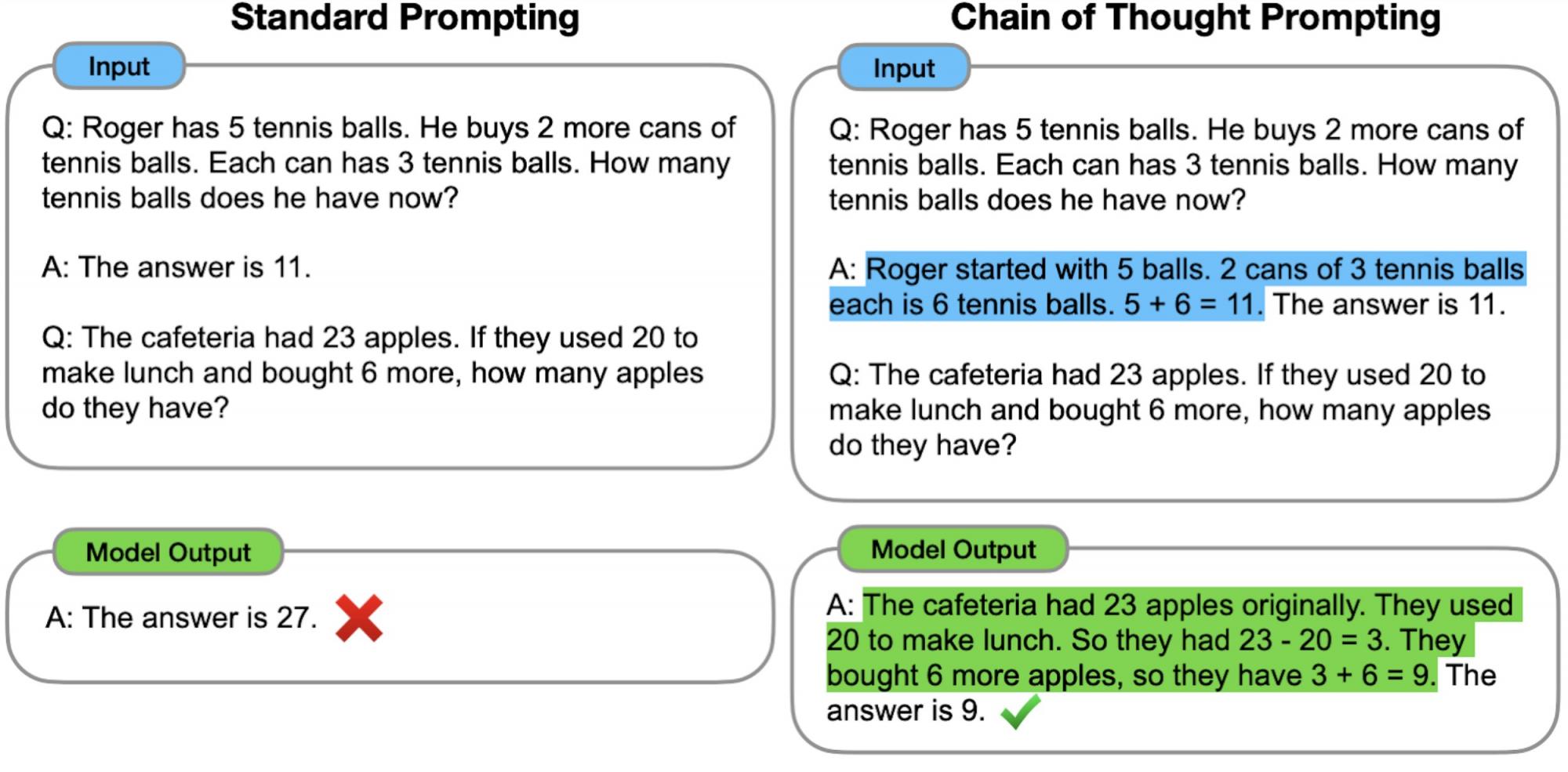

使用标准提示(由GPT-3推广),模型会获得输入输出对的示例(格式化为问题和答案),然后被要求预测测试时间示例的答案(如下图左所示)。在思路链提示(下图右)中,模型被提示产生中间推理步骤,然后给出多步骤问题的最终答案。我们的想法是,模型生成的思路链会在解决多步骤推理问题时模仿直觉的思维过程。虽然产生思维过程以前是通过微调来实现的,但我们表明,仅通过提示包含一些思路链示例就可以引出这种思维过程,而这不需要大量的训练数据集或修改语言模型的权重。

标准提示要求模型直接给出多步骤推理问题的答案,而思路链提示则诱导模型将问题分解为中间推理步骤,在这种情况下会产生正确的最终答案。

思路链推理允许模型将复杂问题分解为可单独解决的中间步骤。此外,思路链基于语言的特性使其适用于人类可以通过语言解决的任何任务。我们通过实证实验发现,思路链提示可以提高各种推理任务的表现,并且成功的思路链推理是模型规模的新兴特性——也就是说,思路链提示的好处只有在模型参数数量足够多(约 100B)时才会实现。

算术推理

语言模型通常难以完成的一类任务是算术推理(即解决数学应用题)。算术推理中的两个基准是MultiArith和GSM8K,它们测试语言模型解决类似于上图所示的多步骤数学问题的能力。我们评估了LaMDA语言模型集合(参数范围从 422M 到 137B)以及PaLM语言模型集合(参数范围从 8B 到 540B)。我们手动编写思路链,将其包含在思路链提示的示例中。

对于这两个基准测试,使用标准提示会导致相对平坦的扩展曲线:增加模型规模不会显著提高性能(如下所示)。但是,我们发现,当使用思路链提示时,增加模型规模可以提高性能,对于大型模型,其性能大大优于标准提示。

采用思路链提示可以使语言模型解决算术推理问题,而标准提示的缩放曲线基本是平坦的。

在 GSM8K 数学应用题数据集上,PaLM 在扩展到 540B 参数时表现出色。如下表所示,将思路链提示与 540B 参数的 PaLM 模型相结合,可实现 58% 的全新最佳性能,超越之前通过在大型训练集上微调 GPT-3 175B,然后通过经过专门训练的验证器对潜在解决方案进行排序而实现的 55% 的最佳性能。此外,后续关于自洽性的研究表明,通过对大量生成的推理过程进行多数投票,思路链提示的性能可以进一步提高,在 GSM8K 上的准确率达到 74%。

使用PaLM的思路链提示在GSM8K数学应用题基准上达到了新的最高水平。为了与经过微调的 GPT-3 基线进行公平比较,此处显示的思路链提示结果还使用外部计算器来计算基本算术函数(即加法、减法、乘法和除法)。

常识推理

除了算术推理之外,我们还考虑了思维链提示的语言性质是否也使其适用于常识推理,常识推理涉及在一般背景知识的假设下对物理和人类互动进行推理。对于这些评估,我们使用CommonsenseQA和StrategyQA基准,以及BIG-Bench 合作的两个领域特定任务,涉及日期理解和体育理解。示例问题如下:

如下所示,对于 CommonsenseQA、StrategyQA 和 Date Understanding,性能随着模型规模的扩大而提高,而采用思路链提示则带来了额外的小幅改进。思路链提示对体育理解的改进最大,PaLM 540B 的思路链性能超过了没有辅助的体育爱好者(95% vs 84%)。

思路链提示也能提高各类常识推理任务的表现。

结论

思路链提示是一种简单且广泛适用的方法,可以提高语言模型执行各种推理任务的能力。通过对算术和常识推理的实验,我们发现思路链提示是模型规模的一个新兴特性。扩大语言模型可以执行的推理任务范围有望激发基于语言的推理方法的进一步研究。

致谢

我很荣幸能够与 Xuezhi Wang、Dale Schuurmans、Maarten Bosma、Ed Chi、Sharan Narang、Aakanksha Chowdhery 和 Quoc Le 合作完成这个项目。

评论