过去几年,人们越来越关注开发差分隐私(DP) 机器学习 (ML) 算法。DP 已成为行业中多项实际部署的基础,甚至已被美国人口普查所采用,因为它能够帮助人们理解系统和算法的隐私保障。DP 的基本假设是,改变单个用户对算法的贡献不应显著改变其输出分布。

在标准监督学习设置中,给定一组示例对 {[输入1,标签1 ],...,[输入n,标签n ]},训练模型对每个输入的标签进行预测。在深度学习的情况下,之前的工作引入了一个 DP 训练框架DP-SGD,该框架已集成到TensorFlow和PyTorch中。DP-SGD 通过在随机梯度下降(SGD) 训练算法中添加噪声来保护每个示例对 [输入,标签] 的隐私。然而,尽管付出了大量努力,但在大多数情况下,使用 DP-SGD 训练的模型的准确性仍然明显低于非隐私模型。

DP 算法包括一个隐私预算ε,它量化了每个用户的最坏情况隐私损失。具体而言,ε 反映了如果用任意不同的示例替换训练集中的任何示例,DP 算法的任何特定输出的概率会发生多大变化。因此,较小的 ε 对应更好的隐私,因为算法对单个示例的变化更加无动于衷。然而,由于较小的 ε 往往会对模型效用造成更大的损害,因此在深度学习应用中将 ε 考虑为 8并不罕见。值得注意的是,对于广泛使用的多类图像分类数据集CIFAR-10, ε = 3 的 DP 模型的最高报告准确率(无需预训练)为 69.3%,这个结果依赖于手工制作的视觉特征。相比之下,使用现代神经网络架构时,具有学习特征的非隐私场景(ε = ∞)已显示出可实现 >95% 的准确率。这种性能差距仍然是许多实际应用采用 DP 的障碍。此外,尽管最近 取得了进展,但由于收敛速度较慢且需要计算每个示例梯度的范数,DP-SGD 通常会增加计算和内存开销。

在NeurIPS 2021上发表的 “具有标签差分隐私的深度学习”中,我们考虑了一种更宽松但重要的特殊情况,称为标签差分隐私( LabelDP ),其中我们假设输入(输入1,...,输入n )是公开的,并且只需要保护训练标签(标签1,...,标签n )的隐私。有了这种宽松的保证,我们可以设计新颖的算法,利用对标签的先前理解来改进模型效用。我们证明 LabelDP 在 CIFAR-10 数据集上的准确率比 DP-SGD 高 20%。我们在多个任务中的结果证实,LabelDP 可以显著缩小隐私模型与非隐私模型之间的性能差距,从而减轻现实世界应用中的挑战。我们还提出了一种使用 LabelDP 训练深度神经网络的多阶段算法。最后,我们很高兴发布这种多阶段训练算法的 代码。

标签DP

LabelDP 的概念已在可能近似正确(PAC) 学习设置中进行了研究,并涵盖了几种实际场景。示例包括:(i)计算广告,其中展示次数为广告商所知,因此被视为非敏感信息,但转化次数会揭示用户兴趣,因此是私密的;(ii) 推荐系统,其中流媒体服务提供商知道选择,但用户评分被视为敏感信息;(iii) 用户调查和分析,其中人口统计信息(例如年龄、性别)不敏感,但收入敏感。

针对这一情况,我们做出了几个关键的观察。(i)当只需要保护标签时,可以应用更简单的算法进行数据预处理以实现 LabelDP,而无需对现有的深度学习训练流程进行任何修改。例如,经典的随机响应(RR) 算法旨在消除调查聚合中的回避性回答偏见,它通过简单地将标签翻转为随机标签(概率取决于 ε)来实现 LabelDP。(ii)以(公共)输入为条件,我们可以计算先验概率分布,这为给定输入的类标签的可能性提供了先验信念。利用 RR 的一种新变体RR-with-prior,我们可以结合先验信息来减少标签噪音,同时保持与传统 RR 相同的隐私保证。

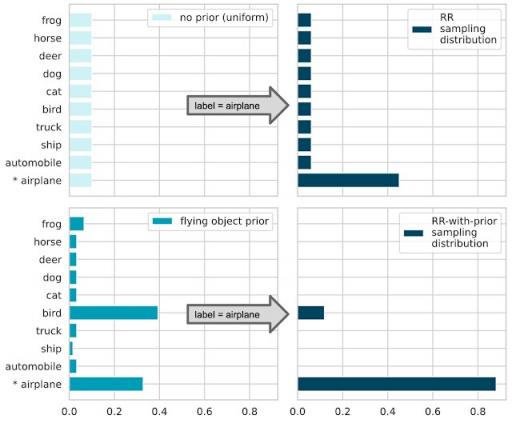

下图说明了 RR-with-prior 的工作原理。假设建立一个模型将输入图像分为 10 个类别。考虑一个带有标签“飞机”的训练示例。为了保证 LabelDP,经典 RR 返回根据给定分布采样的随机标签(参见下图的右上面板)。目标隐私预算 ε 越小,采样错误标签的概率就越大。现在假设我们有一个先验概率,表明给定的输入“可能是飞行的物体”(左下图)。有了先验,RR-with-prior 将丢弃所有先验较小的标签,只从剩余的标签中采样。通过删除这些不太可能的标签,返回正确标签的概率显著增加,同时保持相同的隐私预算 ε(右下图)。

随机响应:如果没有给出先验信息(左上角),则所有类别都以相同的概率进行采样。如果隐私预算较高(右上角),则采样真实类别(P[airplane] ≈ 0.5)的概率较高。RR-with-prior:假设先验分布(左下角),不太可能的类别会被“抑制”出采样分布(右下角)。因此,在相同的隐私预算下,采样真实类别(P[airplane] ≈ 0.9)的概率会增加。

多阶段训练算法

基于 RR-with-prior 观察,我们提出了一种使用 LabelDP 训练深度神经网络的多阶段算法。首先,将训练集随机划分为多个子集。然后使用经典 RR 在第一个子集上训练初始模型。最后,该算法将数据划分为多个部分,在每个阶段,使用单个部分来训练模型。标签是使用 RR-with-prior 生成的,先验则基于迄今为止训练的模型的预测。

多阶段训练算法的说明。训练集被划分为t 个不相交的子集。使用经典 RR 在第一个子集上训练初始模型。然后使用训练后的模型在 RR-with-prior 步骤和后续阶段的训练中提供先验预测。

结果

我们对多阶段训练算法在多个数据集、域和架构上的实证性能进行了基准测试。在相同隐私预算 ε 的 CIFAR-10 多类分类任务中,保证 LabelDP 的多阶段训练算法(下图中的蓝色)比 DP-SGD 的准确率高出 20%。我们强调,LabelDP 仅保护标签,而 DP-SGD 同时保护输入和标签,因此这并不是一个严格公平的比较。尽管如此,该结果表明,对于只需要保护标签的特定应用场景,LabelDP 可以显著提高模型效用,同时缩小隐私模型和公共基线之间的性能差距。

不同隐私预算下不同算法的模型效用(测试准确率)比较。

在某些领域,先验知识是自然可用的,或者只能使用公开可用的数据来构建。例如,许多机器学习系统都有历史模型,可以根据新数据对其进行评估以提供标签先验。在无监督或自监督学习算法效果良好的领域,也可以从在未标记(因此就 LabelDP 而言是公开的)数据上预先训练的模型中构建先验。具体来说,我们在 CIFAR-10 评估中演示了两种自监督学习算法(上图中的橙色和绿色轨迹)。我们使用自监督学习模型来计算训练示例的表示,并对表示运行k 均值聚类。然后,我们花费少量的隐私预算(ε ≤ 0.05)来查询每个聚类的标签分布直方图,并将其用作每个聚类中点的标签先验。这种先验显著提高了低隐私预算制度(ε < 1)下的模型效用。

类似的观察结果适用于多个数据集(例如MNIST、Fashion-MNIST)和非视觉领域(例如MovieLens-1M电影评分任务)。请参阅我们的论文,了解关于实证结果的完整报告。

实证结果表明,保护标签的隐私比保护输入和标签的隐私要容易得多。这也可以在特定设置下用数学方法证明。具体来说,我们可以证明,对于凸随机优化,将标签私有化的算法的样本复杂度比将标签和输入都私有化的算法的样本复杂度小得多。换句话说,为了在相同的隐私预算下实现相同的模型效用水平,LabelDP 需要更少的训练示例。

结论

我们证明了经验和理论结果都表明 LabelDP 是对完整 DP 保证的一种有希望的放宽。在不需要保护输入隐私的应用中,LabelDP 可以缩小隐私模型和非隐私基线之间的性能差距。对于未来的工作,我们计划为多类分类以外的其他任务设计更好的 LabelDP 算法。我们希望多阶段训练算法代码的发布能为研究人员提供有用的 DP 研究资源。

致谢

这项工作是与 Badih Ghazi、Noah Golowich 和 Ravi Kumar 合作完成的。我们还感谢 Sami Torbey 对我们工作的宝贵反馈。

评论