随着深度强化学习的进步,关于人工智能体如何做出决策 的研究也迅速发展起来。与GPT-3和Imagen等生成式机器学习模型相比,人工智能体可以通过各种操作直接影响其环境,例如根据摄像头输入移动机械臂或单击 Web 浏览器中的按钮。虽然人工智能体有可能为人类提供越来越多的帮助,但当前的方法受到需要以频繁提供的奖励形式接收详细反馈以学习成功策略的阻碍。例如,尽管计算预算很大,但即使是像AlphaGo这样强大的程序也只能走几百步才能获得下一个奖励。

相比之下,做饭这样的复杂任务需要各个层面的决策,从规划菜单、导航到商店取杂货、在厨房里按照菜谱做,到根据高维感官输入正确执行沿途每一步所需的精细动作技能。分层强化学习(HRL) 有望将这些复杂任务自动分解为可管理的子目标,使人工智能体能够从较少的奖励(也称为稀疏奖励)中更自主地解决任务。然而,事实证明,HRL 的研究进展具有挑战性;当前的方法依赖于手动指定的目标空间或子任务,并且不存在通用的解决方案。

为了推动这一研究挑战的进展,我们 与加州大学伯克利分校合作,推出了Director 代理,它能从原始像素中学习实用、通用且可解释的分层行为。Director 训练管理者策略,在学习世界模型的潜在空间内提出子目标,并训练工作者策略来实现这些目标。尽管操作的是潜在表示,但我们可以将 Director 的内部子目标解码成图像,以检查和解释其决策。我们在多个基准测试中对 Director 进行了评估,结果表明它可以学习不同的分层策略,并能够解决以前的方法无法解决的奖励非常稀疏的任务,比如直接从第一人称像素输入使用四足机器人探索 3D 迷宫。

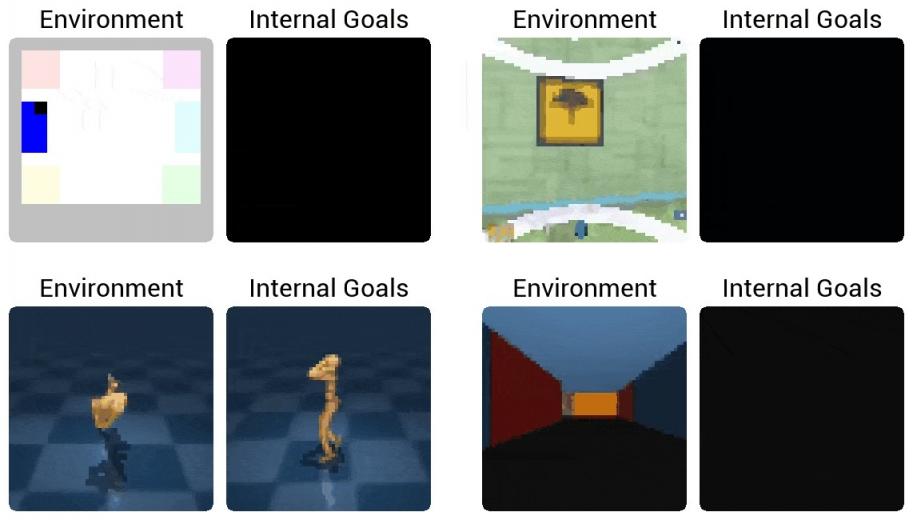

Director 通过自动将复杂的长期任务分解为子目标来学习解决它们。每个面板左侧显示环境交互,右侧显示解码的内部目标。

Director 的工作原理

Director 从像素中学习世界模型,从而能够在潜在空间中进行高效规划。世界模型将图像映射到模型状态,然后根据潜在动作预测未来的模型状态。从模型状态的预测轨迹中,Director 优化了两种策略:管理器 每经过固定数量的步骤选择一个新目标,而工作者 则通过低级动作学习实现目标。但是,直接在世界模型的高维连续表示空间中选择目标对于管理器来说是一个具有挑战性的控制问题。相反,我们学习目标自动编码器来将模型状态压缩为较小的离散代码。然后,管理器选择离散代码,目标自动编码器将它们转换为模型状态,然后将它们作为目标传递给工作者。

左图:目标自动编码器(蓝色)将世界模型(绿色)状态(s t)压缩为离散代码(z)。右图:管理策略(橙色)选择一个代码,目标解码器(蓝色)将其转换为特征空间目标(g )。工作策略(红色)从世界模型预测的未来轨迹( s 1,...,s 4 )中学习实现目标。

Director 的所有组件都是同时优化的,因此管理器会学习选择工人可以实现的目标。管理器会学习选择目标以最大化任务奖励和探索奖励,从而引导代理探索并转向环境的远程部分。我们发现,优先选择目标自动编码器产生高预测误差的模型状态是一种简单有效的探索奖励。与Feudal Networks等先前的方法不同,我们的工人不会获得任何任务奖励,而纯粹通过最大化当前模型状态和目标之间的特征空间相似性来学习。这意味着工人不了解任务,而是将所有能力集中在实现目标上。

基准测试结果

尽管 HRL 中的先前工作通常采用自定义评估协议(例如假设不同的练习目标、访问代理在 2D 地图上的全局位置或地面真实距离奖励),但 Director 在端到端 RL 设置中运行。为了测试探索和解决长期任务的能力,我们提出了具有挑战性的Egocentric Ant Maze基准。这组具有挑战性的任务要求通过控制四足机器人的关节在 3D 迷宫中找到并到达目标,仅提供本体感受和第一人称摄像机输入。当机器人到达目标时会给出稀疏奖励,因此代理必须在大部分学习过程中在没有任务奖励的情况下自主探索。

以自我为中心的蚂蚁迷宫基准测试了代理以时间抽象的方式探索以找到迷宫尽头的稀疏奖励的能力。

我们将 Director 与两种同样基于世界模型的先进算法进行比较:Plan2Explore,它基于集成分歧最大化任务奖励和探索奖励;Dreamer,它只是最大化任务奖励。这两个基线都从世界模型的想象轨迹中学习非分层策略。我们发现 Plan2Explore 会导致嘈杂的运动,使机器人翻转到背面,从而阻止其到达目标。Dreamer 在最小的迷宫中到达目标,但无法探索更大的迷宫。在这些更大的迷宫中,Director 是找到并可靠地到达目标的唯一方法。

为了研究代理在独立于 3D 环境表征学习挑战的情况下发现非常稀疏奖励的能力,我们提出了Visual Pin Pad套件。在这些任务中,代理控制一个黑色方块,移动它来踩踏不同颜色的垫子。在屏幕底部,显示了之前激活的垫子的历史记录,无需长期记忆。任务是找到激活所有垫子的正确顺序,此时代理会收到稀疏奖励。Director 再次大大优于以前的方法。

Visual Pin Pad 基准测试允许研究人员在非常稀疏的奖励下评估代理,并且不会产生诸如感知 3D 场景或长期记忆等混淆挑战。

除了解决奖励稀疏的任务外,我们还研究了 Director 在文献中常见的各种任务上的表现,这些任务通常不需要长期探索。我们的实验包括 12 项任务,涵盖Atari 游戏、 Control Suite 任务、 DMLab 迷宫环境和研究平台 Crafter。我们发现 Director 在所有这些具有相同超参数的任务中都取得了成功,证明了层次学习过程的稳健性。此外,向工作者提供任务奖励使 Director 能够学习任务的精确动作,完全匹配或超越最先进的 Dreamer 算法的性能。

Director 解决了具有相同超参数的多种具有密集奖励的标准任务,证明了层次学习过程的稳健性。

目标可视化

虽然 Director 使用潜在模型状态作为目标,但学习世界模型允许我们将这些目标解码为图像以供人类解释。我们将 Director 在多种环境中的内部目标可视化,以深入了解其决策过程,并发现 Director 学习了多种策略来分解长期任务。例如,在Walker 和 Humanoid任务中,管理者要求机器人前倾并改变地板图案,工人则填写腿部需要如何移动的细节。在 Egocentric Ant Maze 中,管理者通过请求一系列不同的墙壁颜色来操纵蚂蚁机器人。在 2D 研究平台 Crafter 中,管理者通过屏幕底部的库存显示请求收集资源和工具;在 DMLab 迷宫中,管理者通过收集所需物体后立即出现的传送动画来鼓励工人。

左图:在 Egocentric Ant Maze XL 中,经理通过瞄准不同颜色的墙壁来指导工人穿越迷宫。右图:在 Visual Pin Pad Six 中,经理通过底部的历史记录显示和突出显示不同的垫子来指定子目标。

左图:在 Walker 中,经理要求机器人摆出前倾姿势,双脚离地,地面图案不断变换,工人则填写腿部运动的细节。右图:在具有挑战性的 Humanoid 任务中,Director 学习如何从像素中可靠地站立和行走,并且不会提前终止情节。

左图:在 Crafter 中,经理通过屏幕底部的库存显示请求收集资源。右图:在 DMLab Goals Small 中,经理请求在收到奖励时出现的传送动画,以此将任务传达给工人。

未来方向

我们认为 Director 是 HRL 研究的一大进步,并正在准备在未来发布其代码。Director 是一种实用、可解释且普遍适用的算法,它为研究界未来开发分层人工智能代理提供了一个有效的起点,例如允许目标仅与完整表示向量的子集相对应、动态学习目标的持续时间以及构建具有三个或更多时间抽象级别的分层代理。我们乐观地认为,未来 HRL 的算法进步将开启智能代理性能和自主性的新水平。

评论