无论是专业人士磨练技能还是儿童学习阅读,教练和教育者在评估学习者在特定情境下对问题的回答并引导他们实现目标方面都发挥着关键作用。这些互动具有与其他形式的对话不同的独特特征,但当学习者独自在家练习时,这些互动是无法实现的。在自然语言处理领域,这种能力尚未受到太多关注,而且在技术上具有挑战性。我们开始探索如何使用机器学习来评估答案,以促进学习。

在这篇博文中,我们介绍了一种重要的自然语言理解 (NLU) 功能,即自然语言评估 (NLA),并讨论了它在教育领域如何发挥作用。典型的 NLU 任务侧重于用户的意图,而 NLA 则允许从多个角度评估答案。当用户想知道他们的答案有多好时,NLA 可以分析答案与预期的接近程度。当没有“正确”答案时,NLA 可以提供微妙的见解,包括主题性、相关性、详细程度等。我们制定了 NLA 的范围,提出了实施主题性 NLA 的实用模型,并展示了如何使用 NLA 帮助求职者使用 Google 的新面试准备工具Interview Warmup练习回答面试问题。

自然语言评估 (NLA) 概述

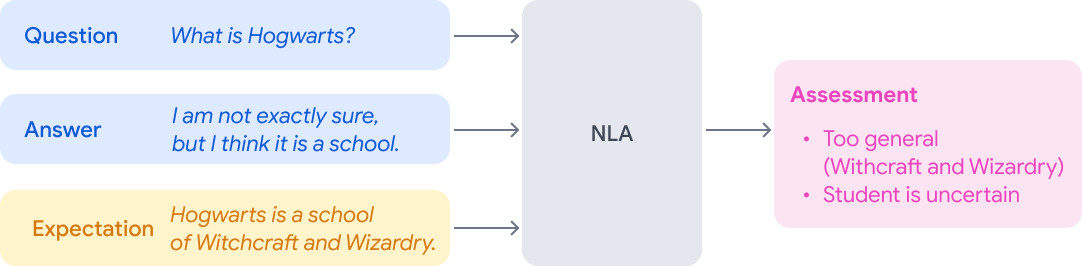

NLA 的目标是根据一组期望来评估用户的答案。考虑与学生互动的 NLA 系统的以下组件:

向学生提出的 问题

定义我们期望在答案中找到什么的期望(例如,具体的文本答案,我们期望答案涵盖的一组主题,简洁性 )

学生提供的 答案

评估输出(例如,正确性、缺失信息、过于具体或笼统、风格反馈、发音等)

[可选]上下文(例如,一本书或一篇文章中的一章)

有了 NLA,对答案的期望和对答案的评估都可以非常广泛。这使得师生互动更具表现力和微妙。以下是两个例子:

具有明确正确答案的问题:即使在有明确正确答案的情况下,更细致地评估答案比简单地判断正确或错误也会有所帮助。请考虑以下几点:

上下文:《哈利·波特与魔法石》

问题:“霍格沃茨是什么?”

期望:“霍格沃茨是一所魔法学校” [期望以文本形式给出]

答案:“我不太确定,但我认为它是一所学校。”

答案可能缺少突出的细节,但将其标记为不正确并不完全正确,对用户来说也无用。NLA 可以提供更细致的理解,例如,识别出学生的答案过于笼统,以及学生的不确定。

从输入问题、答案和期望到评估输出的 NLA 过程的说明。

这种微妙的评估,以及注意学生所表达的不确定性,对于帮助学生培养对话技能非常重要。

主题性期望:在很多情况下,面试官并不期望学生给出具体的答案。例如,如果面试官问学生一个观点问题,面试官并不期望学生给出具体的文字回答。相反,面试官期望学生回答具有相关性和观点性,也许还需要一定程度的简洁性和流畅性。请考虑以下面试练习设置:

问题:“请简单介绍一下你自己?”

期望:{“教育”、“经历”、“兴趣”}(一组主题)

答案:“让我们看看。我在加利福尼亚州的萨利纳斯山谷长大,后来在斯坦福大学主修经济学,但后来对技术产生了兴趣,所以接下来我……”

在这种情况下,有用的评估输出会将用户的答案映射到所涵盖主题的子集,可能还会附带文本的哪些部分与哪个主题相关的标记。从 NLP 的角度来看,这可能具有挑战性,因为答案可能很长,主题可能混杂,并且每个主题本身可能都是多方面的。

主题性 NLA 模型

原则上,主题性 NLA 是一项标准的多类别任务,可以使用标准技术轻松训练分类器。但是,此类场景的训练数据稀缺,而且收集每个问题和主题的数据既昂贵又耗时。我们的解决方案是将每个主题分解为细粒度组件,这些组件可以使用大型语言模型 (LLM) 进行识别,并进行简单的通用调整。

我们将每个主题映射到一系列潜在问题,并定义如果句子包含其中一个潜在问题的答案,则它涵盖该主题。对于“体验”这个主题,我们可能会选择以下潜在问题:

你在哪里工作?

你学了什么?

…

而对于“兴趣”这个话题,我们可能会选择如下潜在问题:

你对什么感兴趣?

你喜欢做什么?

…

这些底层问题是通过迭代手动过程设计的。重要的是,由于这些问题足够细化,当前的语言模型(见下文详细信息)可以捕捉它们的语义。这使我们能够为 NLA 主题性任务提供零样本设置:一旦训练完成(有关模型的更多信息见下文),就可以轻松添加新问题和新主题,或通过修改其底层内容期望来调整现有主题,而无需收集特定于主题的数据。请参见下面的模型对上述两个主题 的句子“我在零售业工作了 3 年”的预测:

该图表展示了模型如何使用基础问题来预测用户答案最有可能涉及的主题。

由于与主题“经验”的潜在问题相匹配,因此该句子将被归类为“经验”。

应用程序:帮助求职者准备面试

Interview Warmup是一款与求职者合作开发的新工具,旨在帮助他们为 IT 支持和 UX 设计等快速增长的就业领域的面试做准备。它让求职者可以练习回答行业专家选择的问题,并在面试中变得更加自信和自在。当我们与求职者合作,了解他们在准备面试时面临的挑战以及面试练习工具如何发挥最大作用时,它启发了我们的研究和主题性 NLA 的应用。

我们按照如下方式构建主题性 NLA 模型(一次性解决所有问题和主题):我们在问答数据上训练一个仅编码器的 T5 模型( EncT5

架构),该模型具有 3.5 亿个参数,用于预测一对的兼容性。我们依靠来自SQuAD 2.0的数据,该数据经过处理后可生成

三元组。

在面试热身工具中,用户可以在谈话要点之间切换,看看在他们的回答中检测到了哪些要点。

该工具不会对答案进行评分或评判。相反,它使用户能够自己练习并找到改进的方法。用户回答完面试问题后,他们的答案会通过 Topicality NLA 模型逐句解析。然后,他们可以在不同的谈话要点之间切换,看看在他们的答案中检测到了哪些要点。我们知道,向用户发出信号表示他们的回答“很好”存在许多潜在的陷阱,尤其是当我们仅检测到一组有限的主题时。相反,我们将控制权掌握在用户手中,仅使用 ML 来帮助用户自己发现如何改进。

到目前为止,该工具已经取得了巨大的成果,帮助了包括美国在内的世界各地的求职者,我们最近将其扩展到了非洲。我们计划继续与求职者合作,不断改进,使该工具对数百万寻找新工作的人更加有帮助。

一部短片展示了如何与求职者合作开发 Interview Warmup 及其 NLA 功能。

结论

自然语言评估 (NLA) 是一个技术挑战性强且有趣的研究领域。它为新的对话应用程序铺平了道路,这些应用程序通过从多个角度对答案进行细致的评估和分析来促进学习。通过与社区(从求职者和企业到课堂教师和学生)合作,我们可以确定 NLA 有可能帮助人们学习、参与和发展一系列学科技能的情况,并且我们可以以负责任的方式构建应用程序,使用户能够评估自己的能力并发现改进的方法。

致谢

这项工作是 Google 多个团队通力合作的结果。我们要感谢 Google Research Israel、Google Creative Lab 和 Grow with Google 团队等做出的贡献。

评论