语音到语音翻译 (S2ST) 是一种机器翻译,可将口语从一种语言转换为另一种语言。这项技术有望打破语言障碍,促进不同文化和背景的人们之间的交流。

语音到语音翻译 (S2ST) 是一种机器翻译,可将口语从一种语言转换为另一种语言。这项技术有望打破语言障碍,促进不同文化和背景的人们之间的交流。

之前,我们介绍了Translatotron 1和Translatotron 2,这是有史以来第一个能够直接在两种语言之间翻译语音的模型。然而,它们是在有监督的环境中用平行语音数据进行训练的。平行语音数据的稀缺是该领域的一大挑战,以至于大多数公共数据集都是半合成或完全合成自文本的。这给学习翻译和重建文本中未表示的语音属性增加了额外的障碍,因此这些属性未反映在合成的训练数据中。

这里我们介绍了一种新颖的无监督语音到语音翻译架构Translatotron 3。在 Translatotron 3 中,我们展示了仅从单语数据中学习语音到语音翻译任务是可能的。这种方法不仅可以实现更多语言对之间的翻译,还可以实现非文本语音属性(如停顿、语速和说话人身份)的翻译。我们的方法不包含对目标语言的任何直接监督,因此我们认为这是在翻译过程中保留源语音的副语言特征(例如语调、情感)的正确方向。为了实现语音到语音翻译,我们使用了反向翻译,这是一项来自无监督机器翻译 (UMT) 的技术,其中使用源语言的合成翻译来翻译没有双语文本数据集的文本。西班牙语和英语之间的语音到语音翻译任务的实验结果表明,Translatotron 3 的表现优于基线级联系统。

翻译器 3

Translatotron 3 解决了无监督 S2ST 的问题,从而消除了对双语语音数据集的需求。为此,Translatotron 3 的设计融合了三个关键方面:

使用SpecAugment将整个模型作为掩蔽自动编码器进行预训练,SpecAugment 是一种用于语音识别的简单数据增强方法,它对输入音频的对数梅尔频谱图(而不是原始音频本身)进行操作,并被证明可以有效提高编码器的泛化能力。

基于多语言无监督嵌入(MUSE)的无监督嵌入映射,它在非配对语言上进行训练,但允许模型学习在源语言和目标语言之间共享的嵌入空间。

基于反向翻译的重建损失,以完全无监督的方式训练编码器-解码器直接 S2ST 模型。

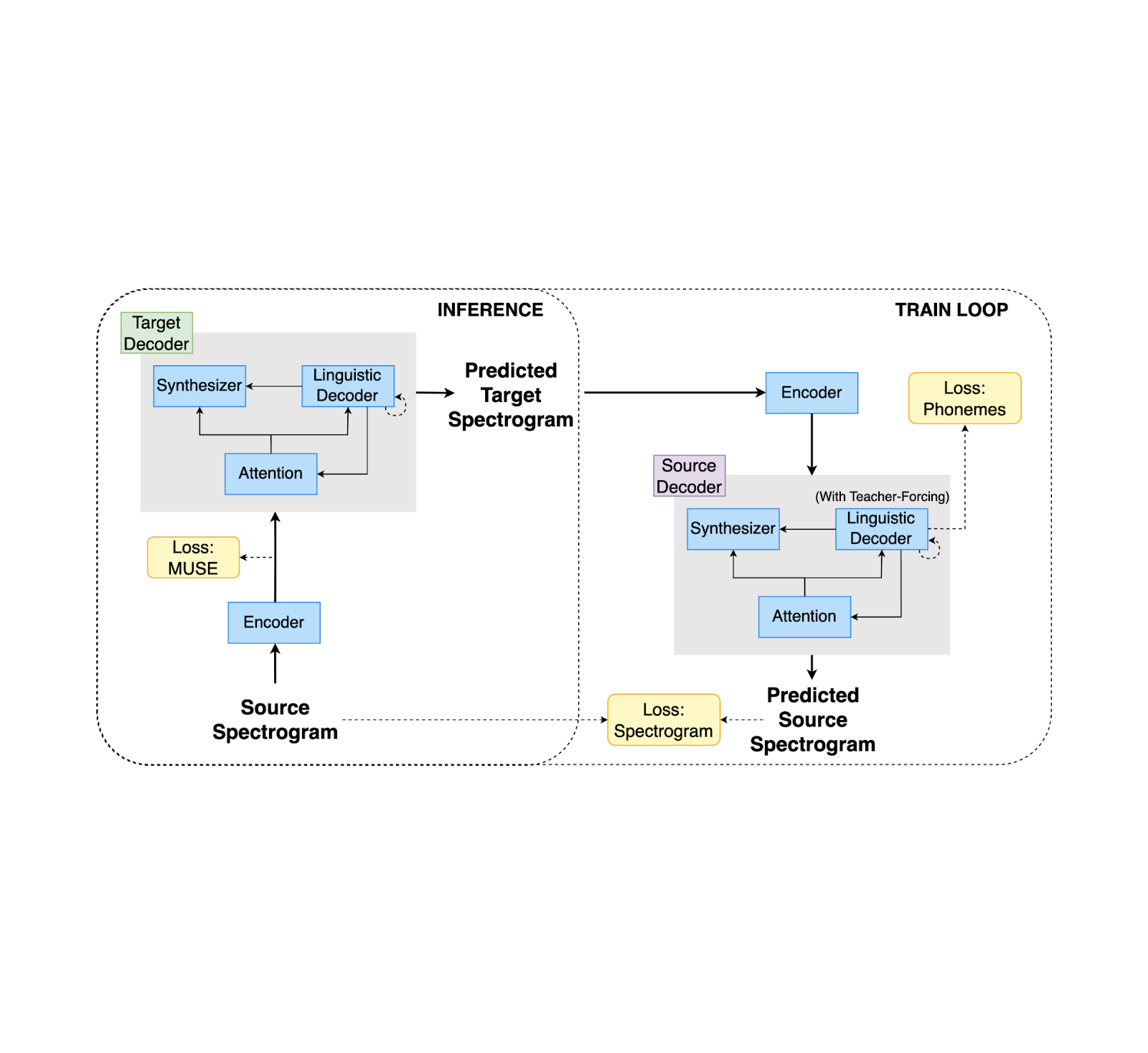

该模型使用无监督 MUSE 嵌入损失、重构损失和 S2S 反向翻译损失的组合进行训练。在推理过程中,共享编码器用于将输入编码到多语言嵌入空间中,随后由目标语言解码器对其进行解码。

建筑学

Translatotron 3 使用共享编码器对源语言和目标语言进行编码。解码器由语言解码器、声学合成器(负责翻译语音的声学生成)和单一注意模块组成,就像 Translatotron 2 一样。但是,对于 Translatotron 3 来说,有两个解码器,一个用于源语言,另一个用于目标语言。在训练期间,我们使用单语语音文本数据集(即,这些数据由语音文本对组成;它们不是翻译)。

编码器

编码器的架构与 Translatotron 2 中的语音编码器相同。编码器的输出分为两部分:第一部分包含语义信息,而第二部分包含声学信息。通过使用 MUSE 损失,输出的前半部分被训练为输入语音频谱图文本的 MUSE 嵌入。后半部分在没有 MUSE 损失的情况下进行更新。值得注意的是,源语言和目标语言共享同一个编码器。此外,MUSE 嵌入本质上是多语言的。因此,编码器能够学习跨源语言和目标语言的多语言嵌入空间。这允许更高效、更有效地对输入进行编码,因为编码器能够将两种语言的语音编码到公共嵌入空间中,而不是为每种语言维护单独的嵌入空间。

解码器

与 Translatotron 2 一样,解码器由三个不同的组件组成,即语言解码器、声学合成器和注意模块。但为了有效处理源语言和目标语言的不同特性,Translatotron 3 有两个独立的解码器,分别用于源语言和目标语言。

两部分训练

训练方法包括两部分:(1) 带重构的自动编码和 (2) 反向翻译项。在第一部分中,使用 MUSE 损失和重构损失训练网络将输入自动编码到多语言嵌入空间。此阶段旨在确保网络生成有意义的多语言表示。在第二部分中,利用反向翻译损失进一步训练网络翻译输入声谱图。为了缓解灾难性遗忘问题并强制潜在空间支持多语言,在训练的第二部分还应用了 MUSE 损失和重构损失。为了确保编码器学习输入的有意义的属性,而不是简单地重构输入,我们在两个阶段都将 SpecAugment 应用于编码器输入。事实证明,通过增强输入数据可以有效提高编码器的泛化能力。

培训目标

在反向翻译训练阶段(如下节所示),网络被训练将输入的语谱图翻译成目标语言,然后再翻译回源语言。反向翻译的目标是强制潜在空间支持多种语言。为了实现这一点,应用了以下损失:

MUSE 损失:MUSE 损失测量输入语谱图的多语言嵌入和反向翻译语谱图的多语言嵌入之间的相似性。

重建损失:重建损失衡量输入频谱图和反向翻译频谱图之间的相似性。

除了这些损失之外,SpecAugment 还应用于两个阶段的编码器输入。在反向翻译训练阶段之前,网络经过训练,使用 MUSE 损失和重构损失将输入自动编码到多语言嵌入空间。

MUSE损失

为了确保编码器生成的多语言表示对两个解码器都有意义,我们在训练期间采用了 MUSE 损失。MUSE 损失迫使编码器使用预先训练的 MUSE 嵌入来生成这样的表示。在训练过程中,给定一个输入文本记录,我们从输入语言的嵌入中提取相应的 MUSE 嵌入。然后最小化 MUSE 嵌入和编码器的输出向量之间的误差。请注意,由于嵌入的多语言性质,编码器在推理过程中对输入的语言无动于衷。

Translatotron 3 中的训练和推理。训练包括通过自动编码路径的重建损失,并采用通过反向翻译的重建损失。

音频样本

以下是 Translatotron 3 直接语音到语音翻译的示例:

西班牙语到英语(会话数据集)

输入(西班牙语)

TTS 合成参考(英文)

Translatotron 3(英语)

西班牙语到英语(基于 CommonVoice11 合成数据集)

输入(西班牙语)

TTS 合成参考(英文)

Translatotron 3(英语)

西班牙语到英语(基于 CommonVoice11 数据集)

输入(西班牙语)

TTS 参考(英语)

Translatotron 3(英语)

表现

为了实证评估所提出方法的性能,我们使用各种数据集对英语和西班牙语进行了实验,包括Common Voice 11数据集以及源自Conversational和 Common Voice 11 数据集的两个合成数据集。

翻译质量通过对翻译语音的 ASR(自动语音识别)转录与相应的参考翻译文本进行比较的BLEU (越高越好)来衡量。而语音质量则通过MOS分数(越高越好)来衡量。此外,说话人相似度通过平均余弦相似度(越高越好) 来衡量。

由于 Translatotron 3 是一种无监督方法,因此我们使用了级联 S2ST 系统作为基准,该系统结合了 ASR、无监督机器翻译 (UMT) 和 TTS (文本转语音)。具体来说,我们采用 UMT,它使用嵌入空间中的最近邻居来创建翻译。

Translatotron 3 在我们测量的各个方面都远远优于基线:翻译质量、说话人相似度和语音质量。它在对话语料库上表现尤为出色。此外,Translatotron 3 实现了与真实音频样本相似的语音自然度(以MOS衡量,越高越好)。

根据三个西班牙语-英语语料库评估的翻译质量(以 BLEU 衡量,分数越高越好)。

在三个西班牙语-英语语料库上评估语音相似度(通过输入说话者和输出说话者之间的平均余弦相似度来衡量,值越高越好)。

对三个西班牙语-英语语料库进行评估的平均意见分数(以平均 MOS 指标衡量,分数越高越好)。

未来工作

在未来的工作中,我们希望将这项工作扩展到更多语言,并研究零样本 S2ST 是否可以与反向翻译技术一起应用。我们还想研究反向翻译在不同类型的语音数据(例如嘈杂语音和低资源语言)中的应用。

致谢

本研究的直接贡献者包括 Eliya Nachmani、Alon Levkovitch、Yifan Ding、Chulayutsh Asawaroengchai、Heiga Zhen 和 Michelle Tadmor Ramanovich。我们还要感谢 Yu Zhang、Yuma Koizumi、Soroosh Mariooryad、RJ Skerry-Ryan、Neil Zeghidour、Christian Frank、Marco Tagliasacchi、Nadav Bar、Benny Schlesinger 和 Yonghui Wu。

评论