我们报告了使用大型语言模型 (LLM) 评估 ASR 成绩单的含义保存的进展,并提出将其作为 WER 的替代指标,特别是对于低资源场景和非典型语音。

词错误率(WER) 及其倒数词准确率 (WACC) 是评估自动语音识别 (ASR) 模型句法准确性的既定指标。然而,这些指标并未衡量 ASR 性能的一个关键方面:可理解性。这种限制对于具有非典型语音模式的用户尤其明显,他们的 WER 通常超过 20%,在某些严重程度下甚至可能超过 60%。尽管如此,具有非典型语音模式的用户仍然可以从具有相对较高 WER 的 ASR 模型中受益,只要他们语音的可理解性或含义得以保留。这对于实时对话、短信语音输入、家庭自动化和其他可以容忍轻微语法错误的应用等用例尤其重要。事实上,这些用户和用例将从保留含义的 ASR 模型中受益最多,因为它们可以大大改善沟通。

以下是几个例子,说明 WACC 不能准确反映转录错误的严重程度。对于几种可能的错误类型,我们提供了两个例子。虽然两个例子的 WACC 相似,但第一个例子中的错误相当轻微,而第二个例子中的错误更严重。

含义Preservation1-TableFin

考虑到这一点,我们着手创建一个系统,该系统将自动评估 ASR 模型有效传达用户意图的能力。在我们的论文“大型语言模型作为人工评估在评估无序语音转录可理解性方面的代理”(ICASSP 2024)中,我们介绍了一种新方法,使用大型语言模型 (LLM) 来确定转录本与参考文本相比是否准确地捕捉到了预期含义。基于这种方法,我们还在此报告了如何使用Gemini让我们既可以使用明显较小的模型而不会损失太多性能,又可以在无需额外训练的情况下为我们的含义评估任务获得多语言性。

意义保存作为替代指标

我们的研究利用了Euphonia 项目语料库,这是一个异常语音库,包含来自大约 2,000 名患有各种不同言语障碍的个体的 120 多万条话语。为了将数据收集范围扩大到西班牙语使用者,Euphonia 项目与国际 ALS/MND 协会联盟合作,后者促成了墨西哥、哥伦比亚和秘鲁ALS患者语音样本的贡献。同样,Euphonia 项目通过与巴黎脑研究所的 Romain Gombert 合作,将范围扩大到法语使用者,收集来自法国言语异常人群的数据。

在我们的实验中,我们生成了一个包含 4,731 个示例的数据集,其中包括基本事实和转录错误对,以及一个人工标签,用于标识这些对是否保留含义(请参阅我们的论文中的详细信息)。我们将数据集分为训练集、测试集和验证集(分别为 80% / 10% / 10%),以确保这三个集在基本事实短语级别上不会重叠。

利用这些数据,我们在基础 LLM 上训练了一个用于保留含义的分类器。使用即时调整(一种调整 LLM 的参数高效方法)我们根据训练集调整了基础 LLM,以预测标签“是”或“否”,以表明含义是否已保留。

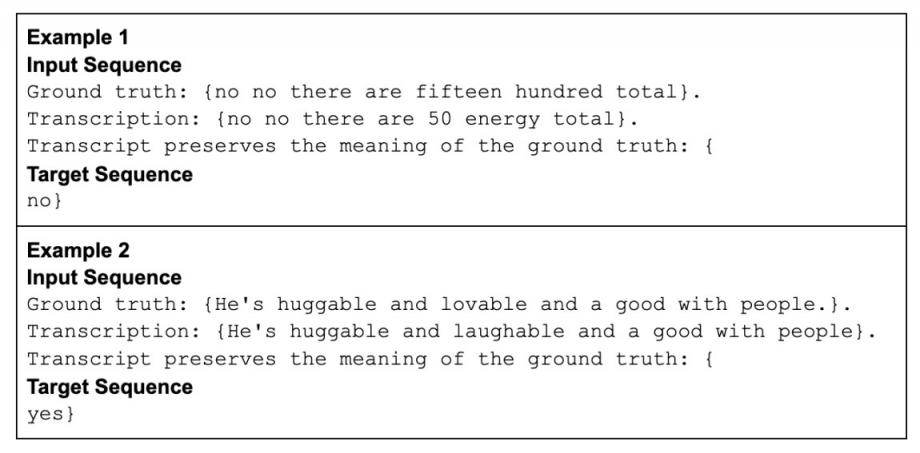

我们使用以下格式向 LLM 呈现数据:

意义保存2-英雄最终版

使用花括号格式表示训练数据的两个示例。“输入序列”也是在推理时输入到模型的内容,“目标序列”是模型学会预测的内容。

为了进行推理,我们不会生成响应,而是获取 LLM 的logit作为与两个类别标签(“是”和“否”)相对应的标记的分数。然后,我们可以选择分数较高的标签,或者,为了评估我们的意义保留分类器(详见下文),我们取“是”类的分数。

在我们利用 LLM 评估意义保存性的工作中,正如我们在原始论文中所报告的那样,我们使用了Google PaLM 语言模型的 62B 参数指令调整版本(称为Flan-cont-PaLM)作为基础 LLM,然后在此基础上训练意义保存分类器。我们在测试集上评估了这个调整后的模型,并测量了高达 0.9 的 AUC ROC(ROC 曲线下面积)分数,大大超过了我们测试过的其他更传统的分类器方法。

使用 Gemini 进行意义保存评估

虽然上述关于 PaLM 的结果令人鼓舞,但近期 AI 模型的巨大改进激励我们评估它们对这项评估任务的适用性。我们重新训练了意义保存分类器,现在使用 Google 的 Gemini 作为基础 LLM。在与这项工作相关的许多用例中,评估任务最好使用小模型来完成(例如,用于设备上的应用程序)。因此,我们选择了Google Gemini 模型的小版本(Gemini Nano-1,拥有 18 亿个参数, Gemini 1.0 技术报告中有详细描述)以实现更高效的推理,其参数不到我们最初使用的 PaLM 62B 模型的 3%。在我们的意义保存测试集上进行评估,我们发现经过微调的 Gemini Nano-1 具有很强的竞争力,尽管它的规模小得多,但 AUC ROC 得分却高达 0.88。

使用 Gemini 进行多语言含义保存评估

作为 Euphonia 项目扩展数据收集工作的一部分,我们还为法语和西班牙语创建了意义保留测试集。这些测试集帮助我们研究了意义保留评估分类器的多语言能力。这些测试集基于收集到的话语、元数据(例如说话者的言语障碍的严重程度和病因)以及从 Google 高度多语言的通用语音模型( USM) 获得的真实转录和 ASR 转录。

对于西班牙语,测试集包含来自 6 位说话者的 518 个示例,而法语测试集包含来自 10 位说话者的 199 个示例。对于这两种语言,不同的说话者有不同的病因和言语障碍程度,包括轻度、中度和重度。

我们基于 Gemini Nano-1 模型的意义保留分类器在法语和西班牙语测试集上均获得了约 0.89 ROC AUC 的开箱即用性能。考虑到此分类器仅使用英语意义保留示例进行训练,这是一个了不起的结果。由于底层 Gemini 模型具有多语言功能,因此无需重新训练模型或创建新语言的训练数据集即可实现这些功能。

结论

我们建议使用意义保留作为比 WER 更有效的指标来评估 ASR 系统的实用性,尤其是在容易出现高错误率的场景中,例如非典型语音和其他资源较少的领域或语言。通过关注意义保留,我们可以更好地评估模型对个人用户的实用性,尤其是与Project Relate等辅助技术一起使用时,该项目旨在通过训练完全个性化的语音识别模型,使具有非典型语音的人能够更好地理解他们。

为了进一步推进我们在意义保存方面的工作,并将其优势惠及更多用户和语言,我们还探索了 Google Gemini 模型的功能。Gemini Nano-1 使我们能够使用比以前小得多的模型实现与意义保存相当的分类器性能。尽管我们的分类器仅使用英语示例进行训练,但它展示了泛化和准确评估其他语言意义保存的能力,正如对法语和西班牙语的测试一样。这一令人兴奋的进展为为世界各地的更多用户构建更高效、更通用的模型开辟了新的可能性。

致谢

我们感谢并认可 Euphonia 项目团队的敬业成员以及语言病理学家 (SLP),他们使这项研究成为可能。我们特别要感谢 Katrin Tomanek、Jimmy Tobin、Subhashini Venugopalan、Julie Cattiau、Richard JN Cave、Katie Seaver、Jordan Green、Rus Heywood、Alicia Martín、Marilyn Ladewig、Bob MacDonald 和 Pan-Pan Jiang 的宝贵贡献。

我们还要感谢国际 ALS/MND 协会联盟以及巴黎脑研究所,感谢他们坚定不移地致力于改善言语不正常用户的沟通。他们的支持对推动这项重要工作发挥了重要作用。我们要特别感谢 Jessica Mabe、Cathy Cummings、Orlando Ruiz 和 Romain Gombert 的杰出贡献,感谢他们卓越的领导能力和专业知识。

评论