密歇根大学的研究人员发现,开源小语言模型 (SLM) 可以提供类似于资源密集型专有大语言模型 (LLM)(例如 OpenAI 的 ChatGPT)的对话响应,但成本更低。他们的研究结果发布在arXiv预印本服务器上。

该团队开发了一款首创的工具,能够评估 SLM 并将其与专有的 LLM 应用程序编程接口进行比较,包括性能和成本。他们最近在2024 年 IEEE 国际系统和软件性能分析研讨会上展示了他们的研究结果。

法学硕士所展示的理解和生成语言的能力已在虚拟助理、聊天机器人和语言翻译系统等应用中得到广泛使用。尽管有用,但法学硕士的培训成本高达数百万甚至更多,这限制了人工智能向科技巨头的发展,而小公司必须依赖其付费服务。

Jason Mars 表示:“Duolingo 和 Slack 等许多公司正在将 OpenAI 的 GPT-4 等法学硕士纳入他们的产品中。严格检验这些模型是否真的是开发人员的最佳选择以及小型开放模型是否有效非常重要。”密歇根大学计算机科学与工程系副教授。

实施专有的法学硕士可以提高速度和便利性,但也带来了有限的定制和数据隐私、性能不可靠、高峰使用期间的滞后和高成本等缺点。

开源 SLM 已经作为一种替代方案出现,但到目前为止,还没有一种方法可以系统地将其性能与更广为人知的 LLM 进行比较。

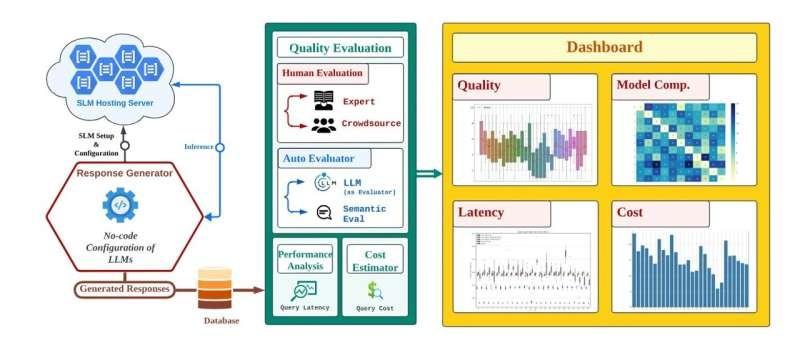

研究团队开发了一种名为SLaM的自动化分析工具,作为第一个报告的用于评估 SLM 及其与 LLM 相比的权衡(质量、性能和成本)的方法。

“我们创建了 SLaM 并将其开源,以填补工具的空白,这些工具可以根据具体情况加速和自动化开放式和封闭式法学硕士的比较分析,”Mars 说。

该工具已在 Myca AI 开发的名为“daily pep talk”的 AI 生产力工具中进行了测试。该功能利用用户的任务列表每天提供个性化和智能的鼓励和建议。

研究人员在日常鼓舞士气的生产环境中对照 OpenAI 的 GPT-4 评估了 9 个 SLM 的 29 个不同版本。虽然 GPT-4 达到了人工小组判断的最高准确度,但大多数 SLM 都接近其质量,并且具有更可预测的延迟性能。

“我们对这些小模型提供的高质量答案感到惊讶。很多时候,用户无法真正区分 SLM 和 LLM,”计算机科学与工程副教授 Lingjia Tang 说。

重要的是,与 LLM 相比,SLM 的成本降低了 5 到 29 倍,具体取决于所使用的模型。

“这一发现对于试图在这场激烈的人工智能竞赛中保持竞争力的小公司具有重大意义。借助 SLaM 工具,公司可以选择较小的开源模型,这些模型可以提供高质量的答案,但成本要低得多,从而减少对科技巨头的依赖。”唐。

其他合著者:Jaseci Labs 的 Chandra Irugalbandara、Ashish Mahendra、Tharuka Kasthuri Arachchige 和 Jayanaka Dantanarayana;密歇根大学的 Yiping Kang、Roland Daynauth 和 Krisztian Flautner。

本站全部资讯来源于实验室原创、合作机构投稿及网友汇集投稿,仅代表个人观点,不作为任何依据,转载联系作者并注明出处:https://www.lvsky.net/39.html

评论