通用机器人要想发挥最大作用,就需要能够执行一系列任务,例如清洁、维护和运送。但是,使用离线强化学习(RL)(一种反复试验的学习方法,其中代理使用之前收集的数据进行训练)训练单个任务(例如抓取)可能需要数千个机器人小时,此外还需要大量工程来实现大型机器人系统的自主运行。因此,随着任务数量的增加,使用当前的机器人学习方法构建通用日常机器人的计算成本变得令人望而却步。

跨多个机器人进行多任务数据收集,其中不同的机器人为不同的任务收集数据。

在其他大规模机器学习领域,如自然语言处理和计算机视觉,已经应用了许多策略来分摊学习多种技能的工作量。例如,在大型自然语言数据集上进行预训练可以实现多项任务的少样本或零样本学习,例如问答和情绪分析。然而,由于机器人会收集自己的数据,因此机器人技能学习带来了一系列独特的机遇和挑战。自动化这一过程是一项巨大的工程工程,而有效地重用不同机器人收集的过去机器人数据仍然是一个悬而未决的问题。

今天,我们介绍了两项大规模机器人强化学习的新进展:MT-Opt,一种用于自动数据收集和多任务强化学习训练的新型多任务强化学习系统;以及可操作模型,它利用获取的数据进行目标条件强化学习。MT-Opt 引入了一种可扩展的数据收集机制,用于收集真实机器人上超过 800,000 次各种任务,并展示了多任务强化学习的成功应用,与基线相比平均提高了约 3 倍。此外,它还使机器人能够通过使用其广泛的多任务数据集(在数据收集后不到 1 天的时间内对新任务进行微调)来快速掌握新任务。可操作模型通过训练一个隐式的世界模型(这也是一项可操作的机器人策略),实现在没有特定任务和奖励的情况下进行学习。这大大增加了机器人可以执行的任务数量(通过视觉目标指定),并使下游任务的学习更加高效。

大规模多任务数据收集系统

MT-Opt 和可操作模型的基石是训练数据的数量和质量。为了大规模收集多样化的多任务数据,用户需要一种方法来指定任务、决定为哪些任务收集数据,最后管理和平衡生成的数据集。为此,我们使用来自所有选定任务的数据创建了一个可扩展且直观的多任务成功检测器。多任务成功检测器使用监督学习进行训练,以检测给定任务的结果,并允许用户快速定义新任务及其奖励。当使用此成功检测器收集数据时,它会定期更新以适应由各种现实因素(例如变化的照明条件、变化的背景环境以及机器人发现的新状态)引起的分布变化。

其次,我们同时收集多个机器人的多个不同任务的数据,方法是使用较简单任务的解决方案有效地引导较复杂任务的学习。这允许为较难的任务训练策略并改进为它们收集的数据。因此,每个任务的数据量和每个任务的成功情节数量会随着时间的推移而增加。为了进一步提高性能,我们将数据收集重点放在表现不佳的任务上,而不是在各个任务之间统一收集数据。

该系统收集了 9600 个机器人小时的数据(来自 7 个机器人上 57 个连续数据收集日)。然而,虽然这种数据收集策略在收集大量任务的数据时很有效,但任务之间的成功率和数据量是不平衡的。

使用 MT-Opt 进行学习

我们通过在任务之间传输数据并重新平衡每个任务的数据来解决数据收集不平衡问题。机器人会生成标记为每个任务成功或失败的事件,然后将其复制并共享到其他任务中。然后,平衡的一批事件被发送到我们的多任务 RL 训练管道以训练 MT-Opt 策略。

MT-Opt 使用的数据共享和任务重新平衡策略。机器人生成事件,然后将其标记为当前任务的成功或失败,然后与其他任务共享。

MT-Opt 使用Q 学习,这是一种流行的 RL 方法,可以学习一个估计未来奖励总和的函数,称为 Q 函数。然后,学习到的策略会选择最大化这个学习到的 Q 函数的操作。对于多任务策略训练,我们将任务指定为大型 Q 学习网络的额外输入(灵感来自我们之前使用 QT -Opt进行大规模单任务学习的工作),然后使用整个多任务数据集通过离线 RL同时训练所有任务。通过这种方式,MT-Opt 能够训练各种各样的技能,包括挑选特定物体、将它们放入各种固定装置、在架子上对齐物品、重新排列和用毛巾覆盖物品等。

与单任务基线相比,MT-Opt 在数据最多的任务上表现类似,并显著提高了代表性不足的任务的性能。因此,对于具有最多支持数据的通用举重任务,MT-Opt 实现了 89% 的成功率(而 QT-Opt 为 88%),并在罕见任务中实现了 50% 的平均成功率,而单任务 QT-Opt 基线的成功率为 1%,使用简单的多任务 QT-Opt 基线的成功率为 18%。使用 MT-Opt 不仅可以实现对新任务的零样本泛化,而且可以快速(在七个机器人上收集数据约 1 天)微调到新的、以前从未见过的任务。例如,当应用于未见过的毛巾覆盖任务时,系统在毛巾拾取和物体覆盖方面的零样本成功率分别为 92% 和 79%,而这在原始数据集中并不存在。

MT-Opt 能够学习的示例任务,例如实例和不加区分的抓取、追逐、放置、对齐和重新排列。

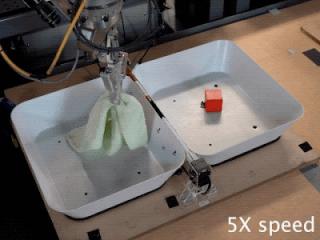

原始数据集中不存在的毛巾覆盖任务。我们在 1 天内对这项新任务的 MT-Opt 进行了微调,以实现较高的 (>90%) 成功率。

通过可操作的模型进行学习

虽然提供严格的任务定义有助于 MT-Opt 自主收集数据,但它将可学习行为的数量限制为一个固定集合。为了能够从相同的数据中学习更广泛的任务,我们使用目标条件学习,即学习达到机器人前方场景的给定目标配置,我们用目标图像指定该配置。与学习未来世界观察的预测模型的显式基于模型的方法或采用在线数据收集的方法相比,这种方法通过离线无模型 RL 学习目标条件策略。

为了学会达到任何目标状态,我们对收集到的数据集中的所有轨迹和子序列进行事后重新标记,并以完全离线的方式训练目标条件 Q 函数(与使用固定的成功示例集进行在线学习(如递归分类)不同)。这种设置中的一个挑战是仅从“正面”事后重新标记的示例中学习会导致分布偏移。我们采用保守策略来解决这个问题,使用人工负面动作来最小化未见动作的 Q 值。此外,为了能够实现临时扩展目标,我们引入了一种跨多个情节链接目标的技术。

使用可操作模型进行训练可让系统学习大量视觉指示技能,例如抓取物体、放置容器和重新排列物体。该模型还能够推广到训练数据中未见过的新物体和视觉目标,这表明它能够学习有关世界的一般功能知识。我们还表明,通过微调预先训练的目标条件模型或通过训练期间实现目标的辅助目标,可以更有效地学习下游强化学习任务。

我们的可操作模型能够学习的示例任务(由目标图像指定)。

结论

MT-Opt 和 Actionable Models 的结果表明,可以在单个模型中从大量不同的真实机器人数据集中收集并学习许多不同的任务,从而有效地分摊学习多项技能的成本。我们认为这是迈向通用机器人学习系统的重要一步,该系统可以进一步扩展以执行许多有用的服务,并作为学习下游任务的起点。

这篇文章基于两篇论文“ MT-Opt:大规模持续多任务机器人强化学习”和“可操作模型:机器人技能的无监督离线强化学习”,并在MT-Opt和可操作模型的项目网站上提供了更多信息和视频。

致谢

这项研究由 Dmitry Kalashnikov、Jake Varley、Karol Hausman、Yevgen Chebotar、Ben Swanson、Rico Jonschkowski、Chelsea Finn、Sergey Levine、Yao Lu、Alex Irpan、Ben Eysenbach、Ryan Julian 和 Ted Xiao 进行。我们要特别感谢 Josh Weaver、Noah Brown、Khem Holden、Linda Luu 和 Brandon Kinman 对机器人操作的支持;感谢 Anthony Brohan 对分布式学习和测试基础设施的帮助;感谢 Tom Small 对视频和项目媒体的帮助;感谢 Julian Ibarz、Kanishka Rao、Vikas Sindhwani 和 Vincent Vanhoucke 的支持;感谢 Tuna Toksoz 和 Garrett Peake 改进了 bin 重置机制;感谢 Satoshi Kataoka、Michael Ahn 和 Ken Oslund 对底层控制堆栈的帮助,感谢 Google 机器人团队其他成员的全面支持和鼓励。以上所有贡献都为这项研究提供了极大的帮助。

评论