机器人研究中的强化和模仿学习方法可以实现自主环境导航和高效的物体操控,从而开辟大量有用的实际应用。之前的研究已经证明了使用深度神经网络进行端到端学习的机器人如何通过理解摄像机观察结果来采取行动和解决任务,从而可靠、安全地与我们周围的非结构化世界交互。但是,虽然端到端学习方法可以概括和扩展到复杂的机器人操控任务,但它们需要数十万个现实世界的机器人训练集,这可能很难获得。人们可以尝试通过使用环境模拟来缓解这种限制,使虚拟机器人能够更快、更大规模地学习,但模拟无法与现实世界完全匹配,这带来了一个挑战,通常称为模拟与现实的差距。差距的一个重要来源是模拟中渲染的图像与真实的机器人摄像机观察结果之间的差异,这导致机器人在现实世界中的表现不佳。

迄今为止,为弥合这一差距,人们采用了一种称为像素级域自适应的技术,该技术将合成图像转换为像素级的真实图像。这种技术的一个例子是GraspGAN,它采用了生成对抗网络(GAN),这是一种在图像生成方面非常有效的框架,可以根据每个域的数据集对模拟图像和真实图像之间的转换进行建模。这些伪真实图像可以纠正一些模拟与真实的差距,因此通过模拟学习到的策略在真实机器人上执行得更成功。然而,它们在模拟到真实的转换中使用的一个限制是,由于 GAN 在像素级转换图像,因此机器人任务学习所必需的多像素特征或结构可能会被任意修改甚至删除。

为了解决上述限制,我们与X的Everyday Robot Project 合作,推出了两项作品RL-CycleGAN和RetinaGAN,它们使用特定于机器人的一致性训练 GAN,这样它们就不会任意修改对机器人任务学习特别必要的视觉特征,从而弥合模拟与真实之间的视觉差异。我们展示了这些一致性如何保留对策略学习至关重要的特征,从而无需手工设计、针对特定任务进行调整,这反过来又允许这种模拟到真实的方法灵活地跨任务、领域和学习算法工作。通过 RL-CycleGAN,我们描述了我们的模拟到真实的迁移方法,并展示了使用 RL 训练的真实世界抓取任务的最新性能。通过 RetinaGAN,我们扩展了我们的方法,将模仿学习纳入开门任务。

RL-CycleGAN

在“ RL-CycleGAN:强化学习感知的模拟到现实”中,我们利用CycleGAN的变体实现模拟到现实的适应,确保真实图像和模拟图像之间任务相关特征的一致性。CycleGAN 通过确保转换回原始域的适应图像与原始图像相同来鼓励保留图像内容,这称为循环一致性。为了进一步鼓励适应后的图像用于机器人技术,CycleGAN 与强化学习(RL) 机器人代理联合训练,以确保机器人在原始图像和 GAN 适应后的图像下的动作相同。也就是说,机械臂或可抓取物体位置等任务特定特征不会改变,但 GAN 仍可能改变域之间的光照或纹理差异,而这些差异不会影响任务级决策。

评估 RL-CycleGAN

我们在机器人无差别抓取任务 上评估了 RL-CycleGAN 。经过 580,000 次真实试验和使用 RL-CycleGAN 调整的模拟训练,机器人抓取物体的成功率为 94%,超过了之前最先进的模拟到真实方法 GraspGAN 的 89% 的成功率和使用非模拟的真实数据的 87% 的成功率。仅通过 28,000 次试验,RL-CycleGAN 方法就达到了 86%,与之前使用 20 倍数据的基线相当。下面显示了一些 RL-CycleGAN 输出示例以及模拟图像。

RL-CycleGAN 翻译前(左)和翻译后(右)的机器人抓取模拟图像比较。

RetinaGAN

虽然 RL-CycleGAN 使用任务感知可靠地将 RL 域从模拟转移到真实,但一个自然的问题出现了:我们能否开发一种更灵活的模拟到真实转移技术,广泛应用于不同的任务和机器人学习技术?

在ICRA 2021上发表的 “ RetinaGAN:一种基于对象感知的模拟到现实迁移方法”中,我们开发了一种任务解耦、算法解耦的 GAN 方法,通过专注于机器人对物体的感知来实现模拟到现实的迁移。RetinaGAN 通过物体检测实现感知一致性,以预测所有图像上所有物体的边界框位置,从而实现强大的物体语义感知。在理想的模拟到现实模型中,我们期望物体检测器在 GAN 转换之前和之后预测相同的框位置,因为物体在结构上不应该发生变化。RetinaGAN 通过反向传播朝着这个理想方向训练,这样当a ) 模拟图像从模拟转换为现实再转换回模拟时,以及b ) 真实图像从现实转换为模拟再转换回真实时,对物体的感知都是一致的。我们发现这种基于对象的一致性比 RL-CycleGAN 所需的任务特定一致性具有更广泛的适用性。

RetinaGAN 阶段图。模拟图像(左上)由模拟到真实生成器转换,随后由真实到模拟生成器转换。真实图像(左下)以相反的顺序进行转换。从模拟图像和真实图像开始的单独管道可以提高 GAN 的性能。

在真实机器人上评估 RetinaGAN

为了实现构建更灵活的模拟到现实的传输技术的目标,我们通过多种方式评估 RetinaGAN,以了解它针对哪些任务以及在什么条件下完成模拟到现实的传输。

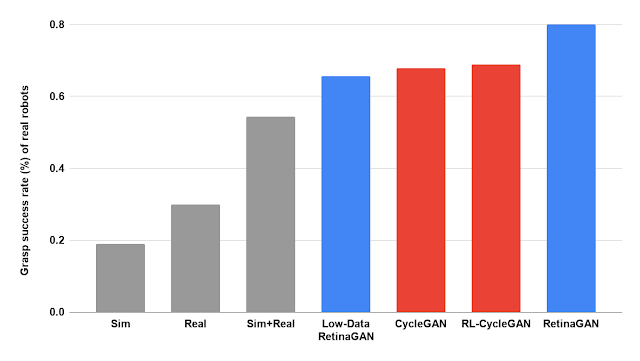

我们首先将 RetinaGAN 应用于抓取任务。如下图所示,RetinaGAN 强调真实物体纹理、阴影和光照的转换,同时保持可抓取物体的视觉质量和显著性。我们将预训练的 RetinaGAN 模型与分布式强化学习方法Q2-Opt相结合,以训练基于视觉的任务模型,例如抓取。在真实机器人上,该策略在十万集上训练后,抓取物体实例的成功率为 80% — 优于之前的自适应方法 RL-CycleGAN 和 CycleGAN(均达到约 68%)和没有领域自适应的训练(下图灰色条:使用模拟数据为 19%,使用真实数据为 22%,使用混合数据为 54%)。这让我们相信感知一致性是模拟到真实迁移的宝贵策略。此外,仅使用 10,000 个训练集(占数据的 8%),使用 RetinaGAN 的 RL 策略抓取成功率为 66%,证明了使用明显更少数据之前方法的性能。

使用各种数据集和模拟到真实方法训练的 RL 策略在实例抓取方面的评估性能。低数据 RetinaGAN 使用了 8% 的真实数据集。

使用 RetinaGAN 将模拟的抓取环境(左)转换为真实的图像(右)。

接下来,我们将 RetinaGAN 与另一种学习方法(行为克隆)相结合,在人类操作员的演示下打开会议室的门。使用来自模拟和真实演示的图像,我们训练 RetinaGAN 将合成图像转换为看起来逼真的图像,从而弥合模拟与现实之间的差距。然后,我们训练行为克隆模型,以模仿人类操作员在真实和 RetinaGAN 改编的模拟演示中解决任务的动作。当通过预测要采取的行动来评估该模型时,机器人进入真实会议室的概率超过 93%,超过了 75% 及以下的基线。

上面两张图片展示的是相同的模拟,但是 RetinaGAN 将模拟的开门图像(左)转换为看起来更像真实的机器人传感器数据(右)。

真实机器人使用 RetinaGAN 训练的行为克隆策略成功打开会议室门的三个示例。

结论

这项工作证明了 GAN 上的额外约束如何解决视觉模拟与现实差距,而无需针对特定任务进行调整;这些方法可以用更少的数据收集达到更高的真实机器人成功率。RL-CycleGAN 使用 RL 一致性损失将合成图像转换为真实图像,从而自动保留与任务相关的特征。RetinaGAN 是一种对象感知的模拟到现实自适应技术,可在环境和任务之间进行稳健传输,与任务学习方法无关。由于 RetinaGAN 没有经过任何特定于任务的知识训练,我们展示了如何将其重新用于新颖的物体推动任务。我们希望模拟到现实差距方面的工作能够进一步推广到解决非结构化环境中与任务无关的机器人操作问题。

致谢

RL-CycleGAN 的研究由 Kanishka Rao、Chris Harris、Alex Irpan、Sergey Levine、Julian Ibarz 和 Mohi Khansari 负责。RetinaGAN 的研究由 Daniel Ho、Kanishka Rao、Zhuo Xu、Eric Jang、Mohi Khansari 和 Yunfei Bai 负责。我们还要特别感谢 Ivonne Fajardo、Noah Brown、Benjamin Swanson、Christopher Paguyo、Armando Fuentes 和 Sphurti More 监督机器人的运行。我们感谢 Paul Wohlhart、Konstantinos Bousmalis、Daniel Kappler、Alexander Herzog、Anthony Brohan、Yao Lu、Chad Richards、Vincent Vanhoucke 以及 Mrinal Kalakrishnan、Max Braun 和Google 机器人团队和Everyday Robot Project的其他成员提供的宝贵讨论和帮助。

评论