机器学习 (ML) 在医学成像应用中的应用为提高胸部 X 光 (CXR) 图像解释的可用性、延迟、准确性和一致性提供了一个激动人心的机会。事实上,已经开发了大量算法来检测特定疾病,例如肺癌、肺结核和气胸。然而,由于这些算法是经过训练来检测特定疾病的,因此在可能出现各种异常的一般临床环境中,它们的实用性可能受到限制。例如,气胸检测器预计不会突出显示提示癌症的结节,而肺结核检测器可能无法识别肺炎特有的发现。由于初始分类步骤是确定 CXR 是否包含令人担忧的异常,因此识别包含任何类型异常的 X 光的通用算法可以大大简化工作流程。然而,由于 CXR 上存在各种各样的异常发现,开发一个分类器来做到这一点具有挑战性。

在《科学报告》上发表的 “深度学习区分正常与异常胸部 X 光片并推广到两种看不见的疾病结核病和 COVID-19 ”中,我们提出了一个模型,该模型可以在多个去识别数据集和设置中区分正常和异常 CXR。我们发现该模型在一般异常以及看不见的结核病和 COVID-19 示例上表现良好。我们还将针对公开的ChestX-ray14 数据集发布本研究中使用的测试集的放射科医生标签集1。

用于检测胸部 X 光片异常的深度学习系统

我们使用的深度学习系统基于EfficientNet-B7架构,在ImageNet上进行了预训练。我们使用来自印度阿波罗医院的 200,000 多张去识别的 CXR 训练该模型。使用基于正则表达式的自然语言处理方法,根据相关放射学报告为 每个 CXR 分配“正常”或“异常”标签。

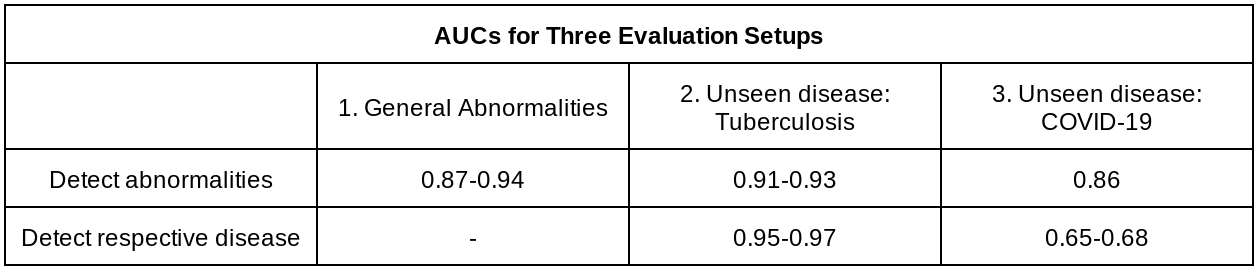

为了评估该系统对新患者群体的推广效果,我们比较了它在两个包含各种异常的数据集上的表现:从阿波罗医院数据集 (DS-1) 中分割出来的测试集和公开的ChestX-ray14 (CXR-14)。一组美国委员会认证的放射科医生为这个项目注释了这两个测试集的标签。该系统在 DS-1 上实现了0.87 的受试者工作特征曲线下面积( AUROC ),在 CXR-14 上实现了 0.94(越高越好)。

尽管对 DS-1 和 CXR-14 的评估包含了广泛的异常,但一个可能的用例是将这种异常检测器用于以前从未遇到过的疾病的新环境或不可预见的环境。为了评估该系统对新患者群体的普遍性以及在训练集中未见的疾病存在的情况下,我们使用了来自三个国家的四个去识别数据集,包括两个可公开获得的结核病数据集和两个来自西北医学的 COVID-19 数据集。该系统在检测结核病时实现了 0.95-0.97 的 AUC,在检测 COVID-19 时实现了 0.65-0.68 的 AUC。由于对这些疾病呈阴性的 CXR 仍可能包含其他令人担忧的异常,我们进一步评估了该系统更广泛地检测异常的能力(而不是疾病阳性与阴性),发现结核病数据集的 AUC 为 0.91-0.93,COVID-19 数据集的 AUC 为 0.86。

多项评估(异常检测和疾病检测)的目的是区分两者:一种疾病可以表现出某种异常,也可以不表现出某种异常;某种异常可以由多种疾病引起。我们的研究对两者都进行了评估。

COVID-19 的表现大幅下降,是因为许多被系统标记为“阳性”的病例对 COVID-19 的检测结果为阴性,但仍然含有需要注意的异常 CXR 结果。这进一步凸显了异常检测器的实用性,即使有针对特定疾病的模型可用。

此外,值得注意的是,推广至未见疾病(例如结核病和 COVID-19)与推广至未见 CXR 发现(例如胸腔积液、实变/浸润)之间存在差异。在本研究中,我们证明了该系统对未见疾病的可推广性,但不一定对未见 CXR 发现具有可推广性。

临床上的潜在益处

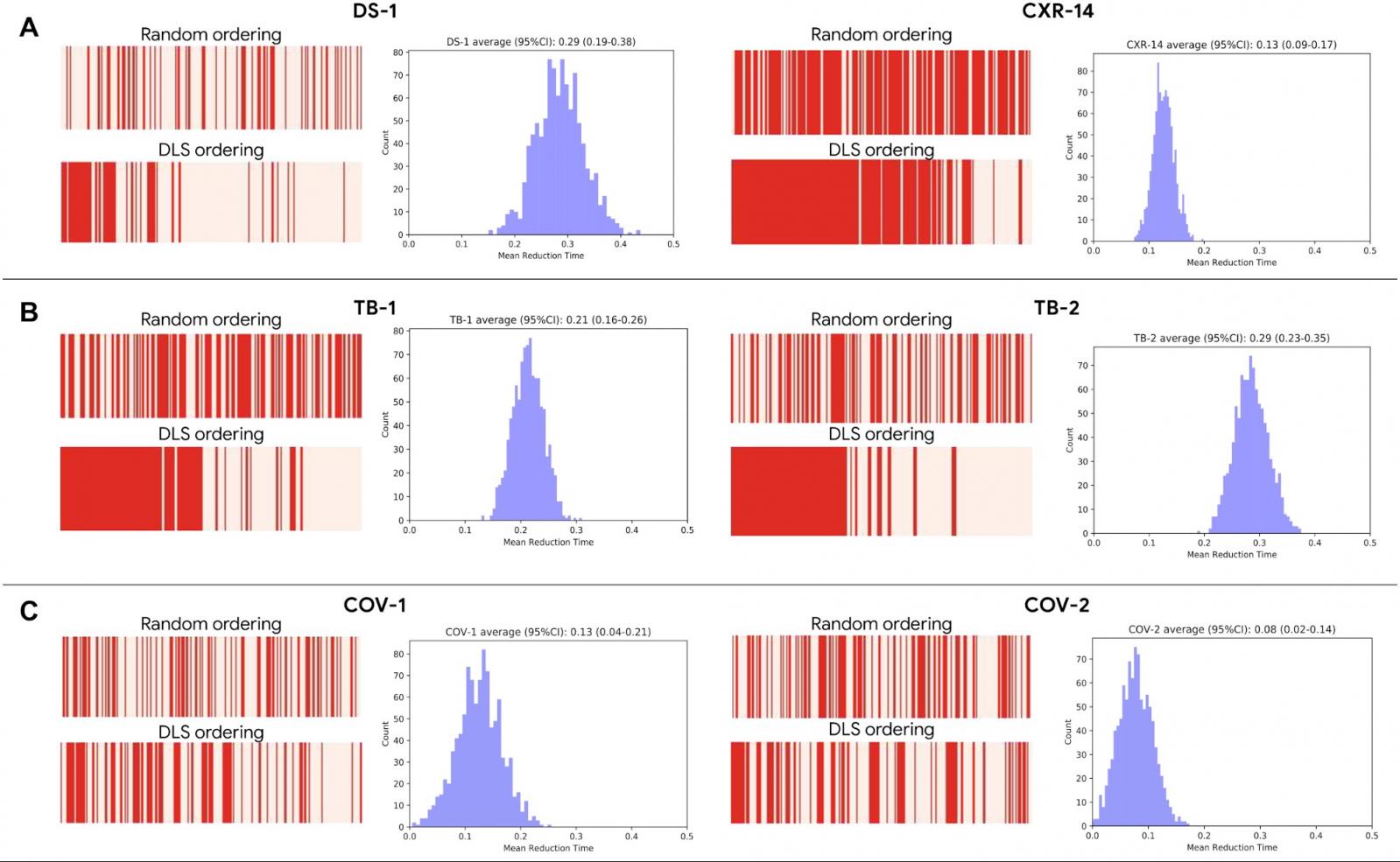

为了了解深度学习模型在改善临床工作流程方面的潜在效用,我们模拟了其用于病例优先级排序的用途,其中异常病例比正常病例“优先处理”。在这些模拟中,系统将异常病例的周转时间缩短了高达 28%。这种重新排序设置可用于将复杂的异常病例转移给心胸外科专科放射科医生,快速分类可能需要紧急决策的病例,并提供批量处理阴性 CXR 以简化审查的机会。

与随机审查顺序相比,基于模拟深度学习模型的优先级对(A)一般异常、(B)结核病和(C)COVID-19 的影响。红色条表示红色异常 CXR 序列和粉红色正常 CXR 序列;左侧红色密度越大表示异常 CXR 审查时间越早。直方图显示周转时间的平均改善。

此外,我们发现该系统可用作预训练模型来改进胸部 X 光片的其他 ML 算法,尤其是在数据有限的情况下。例如,我们在最近的研究中使用了正常/异常分类器来从胸部 X 光片中检测肺结核。在缺乏训练有素的放射科医生或分子检测等资源的地区,异常和结核病检测器可以在支持早期诊断方面发挥关键作用。

分享改进的参考标准标签

要实现机器学习在世界各地辅助胸部 X 光检查解读的潜力,还有许多工作要做。特别是,获取去识别化数据的高质量标签可能是开发和评估医疗保健领域机器学习算法的一大障碍。为了加速这些努力,我们在之前的标签发布基础上进行了扩展,发布了本研究中使用的用于公开可用的ChestX-ray14 数据集的标签。我们期待社区未来在这个领域开展机器学习项目。

致谢

Google 该项目的主要贡献者包括 Zaid Nabulsi、Andrew Sellergren、Shahar Jamshy、Charles Lau、Eddie Santos、Atilla P. Kiraly、Wenxing Ye、Jie Yang、Rory Pilgrim、Sahar Kazemzadeh、Jin Yu、Greg S. Corrado、Lily Peng、Krish Eswaran、Daniel Tse、Neeral Beladia、Yun Liu、Po-Hsuan Cameron Chen 和 Shravya Shetty。放射科医生 Sreenivasa Raju Kalidindi、Mozziyar Etemadi、Florencia Garcia Vicente 和 David Melnick 也做出了重大贡献和贡献。对于 CXR-14 数据集,我们感谢 NIH 临床中心将其公开。对于结核病数据收集,感谢 Sameer Antani、Stefan Jaeger、Sema Candemir、Zhiyun Xue、Alex Karargyris、George R. Thomas、Pu-Xuan Lu、Yi-Xiang Wang、Michael Bonifant、Ellan Kim、Sonia Qasba 和 Jonathan Musco。作者还要感谢 Google 健康放射学和标签软件团队的许多成员,特别是 Shruthi Prabhakara、Scott McKinney 和 Akib Uddin。我们还要真挚地感谢放射科医生在整个研究过程中通过图像解释和注释工作使这项工作成为可能;感谢 Jonny Wong 协调影像注释工作;感谢 Gavin Bee、Mikhail Fomitchev、Shabir Adeel、Jeff Bertram 和 Benedict Noero 发布数据;感谢 David F. Steiner、Kunal Nagpal 和 Michael D. Howell 对手稿提供反馈; Craig Mermel、Lauren Winer、Johnny Luu、Adrienne Welch、Annisah Um'rani 和 Ashley Zlatinov 对博文提出反馈。

评论