近年来,我们看到词汇任务(例如自动语音识别(ASR))取得了显著进步。然而,机器系统仍然难以理解副语言方面的内容,例如语调、情绪、说话者是否戴着口罩等。理解这些方面是机器听力中剩下的难题之一。此外,最先进的结果通常来自使用私人数据训练的超大型模型,因此它们不适合在移动设备上运行或公开发布。

在ICASSP 2022中发表的 “使用自监督一致性的通用副语言语音表示”中,我们引入了CAP12 —使用自监督在YT-U 训练数据集上训练的 600M 参数模型的第 12 层。我们证明,CAP12 模型在我们的副语言基准中优于几乎所有以前的结果,有时甚至大幅超越,即使以前的结果通常是特定于任务的。在“ TRILLsson:提炼的通用副语言语音表示”中,我们介绍了小型、高性能、公开可用的 TRILLsson模型,并展示了我们如何将高性能 CAP12 模型的大小缩小 6 到 100 倍,同时保持 90-96% 的性能。为了创建 TRILLsson,我们对适当大小的音频块应用知识提炼,并使用不同的架构类型来训练更小、更快、足够小以在移动设备上运行的网络。

100 万小时数据集用于训练超大型自监督模型

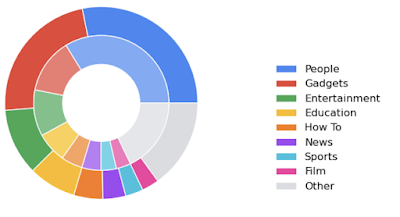

我们利用 YT-U 训练数据集来训练超大型自监督 CAP12 模型。YT-U 数据集变化多样,超过 9 亿小时,包含各种主题、背景条件和说话者声学特性的音频。

按长度(外部)和数量(内部)对视频进行分类,展示了 YT-U 数据集的多样性(图片来自BigSSL)

然后,我们修改了Wav2Vec 2.0自监督训练范式,该范式可以使用没有标签的原始数据来解决任务,并将其与超大型Conformer模型相结合。由于自训练不需要标签,我们可以充分利用 YT-U,将我们的模型扩展到有史以来训练过的一些最大的模型大小,包括 600M、1B 和 8B 参数。

NOSS:副语言任务的基准

我们证明,先前模型之一的中间表示包含最先进的副语言语音表示。我们将没有相对注意的 600M 参数 Conformer 模型称为应用于副语言的 Conformer (CAP)。我们详尽搜索了六个超大型模型的所有中间表示,发现第 12 层 ( CAP12 ) 的表现远胜于之前的表示。

为了衡量大约 300 个候选副语言语音表示的质量,我们根据非语义语音(NOSS) 基准的扩展版本进行评估,该基准是一系列经过充分研究的副语言语音任务,例如语音情感识别、语言识别和说话人识别。这些任务侧重于语音的副语言方面,需要评估大约 1 秒或更长时间的语音特征,而不是需要 100 毫秒或更短时间的词汇特征。然后,我们在基准中添加了 Interspeech 2020上推出的戴口罩任务、假语音检测任务 ( ASVSpoof 2019 )、来自Euphonia项目的检测构音障碍程度的任务,以及额外的语音情感识别任务 ( IEMOCAP )。通过扩展基准并增加任务的多样性,我们通过实证证明 CAP12 比以前的表示更有用。

在八项副语言任务中的五项中,时间平均 CAP12 表示上的简单线性模型甚至优于复杂的任务特定模型。这令人惊讶,因为可比较的模型有时也会使用其他模态(例如视觉和语音,或文本和语音)。此外,CAP12 在情绪识别任务上表现异常出色。CAP12 嵌入在所有其他任务上也优于所有其他嵌入,只有一个例外:构音障碍检测任务中来自监督网络的一个嵌入。

模型 沃克斯名人† 沃克斯福吉 语音命令 ASVSpoof2019 ∗∗ 悦耳动听# CREMA-D 电磁兼容

上一页 SoTA - 95.4 97.9 5.11 45.9 74.0 ∗ 67.6 +

颤音 12.6 84.5 77.6 74.6 48.1 65.7 54.3

ASR 嵌入 5.2 98.9 96.1 11.2 54.5 71.8 65.4

Wav2Vec2 第 6 层†† 17.9 98.5 95.0 6.7 48.2 77.4 65.8

第 12 章 51.0 99.7 97.0 2.5 51.5 88.2 75.0

在 NOSS Benchmark 和扩展任务上测试性能。 “Prev SoTA” 表示之前表现最佳的最先进的模型,该模型具有任意复杂度,但其他所有行都是基于时间平均输入的线性模型。†根据 YouTube 的隐私指南进行过滤。∗∗使用相等错误率 [20]。#唯一的非公开数据集。我们将其排除在总分之外。∗以前最先进的模型中使用的音频和视觉特征。+以前最先进的模型执行了交叉验证。为了进行评估,我们选出两个特定的说话者作为测试。 †† HuggingFace 的 Wav2Vec 2.0 模型。最佳整体层是第 6 层。

TRILLsson:小型、高质量、公开可用的模型

与FRILL 类似,我们的下一步是制作一个可在设备上公开使用的 CAP12 版本。这涉及使用知识蒸馏来训练更小、更快、更适合移动设备的架构。我们尝试了EfficientNet、音频频谱图变换器(AST) 和ResNet。这些模型类型非常不同,涵盖固定长度和任意长度的输入。EfficientNet 源自对视觉模型的神经架构搜索,可同时找到高性能和高效的模型结构。AST 模型是适用于音频输入的变换器。ResNet 是一种标准架构,在许多不同的模型中都表现出良好的性能。

我们训练的模型虽然规模只有 1%-15%,而且只使用了 6% 的数据,但平均性能却达到了 CAP12 的 90-96%。有趣的是,我们发现不同类型的架构在不同规模下表现更好。ResNet 模型在低端表现最佳,EfficientNet 在中间,AST 模型在较大端表现最佳。

各种学生模型架构和大小的总体嵌入性能与模型大小。我们证明 ResNet 架构在小尺寸下表现最佳,EfficientNetV2 在中等尺寸模型范围内表现最佳,直到测试的最大模型尺寸,之后较大的 AST 模型表现最佳。

我们进行知识蒸馏的目的是将具有固定大小输入的学生与具有可变大小输入的老师的输出进行匹配,为此有两种生成学生目标的方法:全局匹配和局部匹配。全局匹配通过为整个音频片段生成 CAP12 嵌入来生成蒸馏目标,然后要求学生仅从一小段音频(例如 2 秒)中匹配目标。局部匹配要求学生网络在学生看到的较小部分音频上匹配平均 CAP12 嵌入。在我们的工作中,我们专注于局部匹配。

两种生成序列蒸馏目标的方法。左:全局匹配使用整个剪辑的平均 CAP12 嵌入作为每个局部块的目标。右:局部匹配使用对局部剪辑取平均的 CAP12 嵌入作为蒸馏目标。

双峰性的观察和未来的方向

副语言信息呈现出意想不到的双峰分布。对于在 500 毫秒输入段上运行的 CAP 模型和两个全输入 Conformer 模型,中间表示中的副语言信息逐渐增加,然后减少,然后再次增加,最后在输出层丢失这些信息。令人惊讶的是,在探索在视网膜图像上训练的网络的中间表示时也看到了这种模式。

500 毫秒的 CAP 输入显示出跨层的副语言信息相对明显的双峰分布。

两个具有完整输入的构象模型显示出跨层的副语言信息的双峰分布。

我们希望更小、更快的副语言语音模型能够解锁语音识别、文本转语音生成和理解用户意图等新应用。我们还希望更小的模型更易于解释,这将使研究人员能够了解语音的哪些方面对副语言学很重要。最后,我们希望社区能够使用 我们的开源语音表示来改进私人或小型数据集中的副语言语音任务和用户理解。

致谢

我要感谢我的合著者 Aren Jansen、Wei Han、Daniel Park、Yu Zhang 和 Subhashini Venugopalan 为这个项目付出的辛勤工作和创造力。我还要感谢大型合作项目的成员为 BigSSL 所做的工作,没有他们的帮助,这些项目就不可能实现。团队成员包括 James Qin、Anmol Gulati、Yuanzhong Xu、Yanping Huang、Shibo Wang、Zongwei Zhou、Bo Li、Min Ma、William Chan、Jiahui Yu、Yongqiang Wang、Liangliang Cao、Khe Chai Sim、Bhuvana Ramabhadran、Tara N. Sainath、Françoise Beaufays、Zhifeng Chen、Quoc V. Le、Chung-Cheng Chiu、Ruoming Pang 和 Yonghui Wu。

评论