LiDAR和视觉摄像头是两种用于自动驾驶汽车和机器人3D 物体检测的互补传感器。LiDAR 是一种利用脉冲激光形式的光来测量范围的遥感技术,它提供低分辨率的形状和深度信息,而摄像头则提供高分辨率的形状和纹理信息。虽然 LiDAR 和摄像头捕获的特征应该合并在一起以提供最佳的 3D 物体检测,但事实证明,大多数最先进的 3D 物体检测器都使用 LiDAR 作为唯一输入。主要原因是,为了开发强大的 3D 物体检测模型,大多数方法需要增强和转换来自两种模态的数据,这使得特征的准确对齐具有挑战性。

现有的融合 LiDAR 和摄像头输出的算法,例如PointPainting、PointAugmenting、EPNet、4D-Net和ContinuousFusion,通常遵循两种方法 - 输入级融合(在早期阶段融合特征,用相应的摄像头特征修饰 LiDAR点云中的点)或中级融合(从两个传感器中提取特征然后组合)。尽管意识到有效对齐的重要性,但这些方法难以有效处理在融合之前增强和聚合特征的常见场景。这表明有效地融合来自两个传感器的信号可能并不简单,而且仍然具有挑战性。

在我们的CVPR 2022论文“ DeepFusion:用于多模态 3D 物体检测的 LiDAR-Camera 深度融合”中,我们介绍了一种完全端到端的多模态 3D 检测框架 DeepFusion,它应用一种简单而有效的深层特征融合策略来统一来自两种感知模态的信号。与使用手动选择的相机特征修饰原始 LiDAR 点云的传统方法不同,我们的方法在端到端框架中融合了深度相机和深度 LiDAR 特征。我们首先介绍两种新技术 InverseAug 和 LearnableAlign,它们可以提高特征对齐的质量并应用于 DeepFusion 的开发。然后,我们展示了 DeepFusion 在Waymo Open Dataset(汽车 3D 物体检测最大的数据集之一)上的最新性能。

InverseAug:几何增强下的精确对齐

为了在现有的自动驾驶汽车 3D 物体检测基准上取得良好性能,大多数方法都需要在训练期间进行强大的数据增强以避免过度拟合。然而,数据增强的必要性对 DeepFusion 流程提出了不小的挑战。具体来说,两种模态的数据使用不同的增强策略,例如,3D 点云沿 z 轴旋转,2D 摄像头图像随机翻转,这通常会导致不准确的对齐。然后,增强的 LiDAR 数据必须经过体素化步骤,将点云转换为存储在三维体素阵列中的体积数据。体素化特征与原始数据有很大不同,这使得对齐更加困难。为了解决由几何相关的数据增强引起的对齐问题,我们引入了逆增强(InverseAug),这是一种在模型训练阶段融合之前逆转增强的技术。

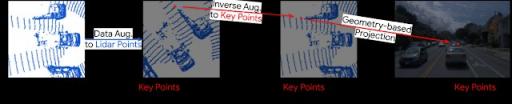

在下面的例子中,我们展示了将增强的 LiDAR 数据与相机数据对齐的困难。在这种情况下,LiDAR 点云通过旋转进行增强,结果是给定的 3D 关键点(可以是任何 3D 坐标,例如 LiDAR 数据点)无法简单地通过使用原始 LiDAR 和相机参数在 2D 空间中对齐。为了使定位可行,InverseAug 首先存储增强参数,然后再应用与几何相关的数据增强。在融合阶段,它会反转所有数据增强以获取 3D 关键点的原始坐标,然后在相机空间中找到其对应的 2D 坐标。

在训练期间,InverseAug 解决了几何增强造成的不准确对齐。

左图:未使用 InverseAug 的比对。右图:使用 InverseAug 后比对质量得到改善。

LearnableAlign:用于学习对齐的跨模态注意模块

我们还引入了可学习对齐(LearnableAlignment),这是一种基于跨模态注意的特征级对齐技术,以提高对齐质量。对于输入级融合方法,例如PointPainting和PointAugmenting,给定 3D LiDAR 点,由于存在一对一映射,因此只能准确定位相应的相机像素。相比之下,在 DeepFusion 管道中融合深度特征时,每个 LiDAR 特征代表一个包含点子集的体素,因此其对应的相机像素位于多边形中。因此,对齐变成了学习体素单元和一组像素之间的映射的问题。

一种简单的方法是对给定体素对应的所有像素进行平均。然而,直观上,并且正如我们的可视化结果所支持的那样,这些像素并不同等重要,因为来自 LiDAR 深度特征的信息与每个相机像素的对齐程度并不相同。例如,一些像素可能包含对检测至关重要的信息(例如,目标对象),而其他像素可能信息量较少(例如,由道路、植物、遮挡物等背景组成)。

LearnableAlign 利用跨模态注意机制来动态捕捉两种模态之间的相关性。这里,输入包含体素单元中的 LiDAR 特征,以及所有对应的相机特征。注意的输出本质上是相机特征的加权和,其中权重由 LiDAR 和相机特征的函数共同确定。更具体地说,LearnableAlign 使用三个全连接层分别将 LiDAR 特征转换为向量 ( ql ),将相机特征转换为向量 ( kc) 和 (vc)。对于每个向量 (ql ) ,我们计算( ql )和( kc )之间的点积,以获得包含 LiDAR 特征和相应相机特征之间相关性的注意亲和力矩阵。然后,通过softmax算子对注意亲和力矩阵进行归一化,使用其计算权重并聚合包含相机信息的向量( vc ) 。然后,聚合的摄像头信息由全连接层处理,并与原始 LiDAR 特征连接 ( Concat )。然后,将输出输入到任何标准 3D 检测框架(例如PointPillars或CenterPoint)中进行模型训练。

LearnableAlign 利用交叉注意机制来对齐 LiDAR 和摄像头功能。

DeepFusion:融合不同模态信息的更好方法

在我们两种新颖的特征对齐技术的支持下,我们开发了 DeepFusion,这是一个完全端到端的多模态 3D 检测框架。在 DeepFusion 管道中,首先将 LiDAR 点输入到现有的特征提取器(例如,来自PointPillars的支柱特征网络)中以获得 LiDAR 特征(例如,伪图像)。同时,将相机图像输入到 2D 图像特征提取器(例如,ResNet )中以获得相机特征。然后,应用 InverseAug 和 LearnableAlign 将相机和 LiDAR 特征融合在一起。最后,融合的特征由所选 3D 检测模型的其余组件(例如,来自PointPillars的主干和检测头)处理以获得检测结果。

DeepFusion 的管道。

基准测试结果

我们在Waymo Open Dataset(自动驾驶汽车最大的 3D 检测挑战之一) 上评估了 DeepFusion ,使用难度等级 2 下的平均航向精度(APH) 指标(在排行榜上对模型性能进行排名的默认指标)。在全球 70 支参赛队伍中,DeepFusion 单一模型和集成模型在相应类别中均取得了最佳表现。

单个 DeepFusion 模型在 Waymo Open Dataset 上实现了新的最佳性能。

Ensemble DeepFusion 模型在 Waymo Open Dataset 上的表现超越所有其他方法,位居排行榜第一名。

InverseAug 和 LearnableAlign 的影响

我们还对所提出的 InverseAug 和 LearnableAlign 技术的有效性进行了简化研究。我们证明,InverseAug 和 LearnableAlign 单独使用都能提高 LiDAR 专用模型的性能,而将两者结合起来可以进一步提高性能。

对 InverseAug (IA) 和 LearnableAlign (LA) 的消融研究以平均精度(AP) 和 APH 进行测量。结合这两种技术有助于获得最佳性能增益。

结论

我们证明,当特征对齐良好时,后期深度特征融合会更有效,但对齐来自两种不同模态的特征可能具有挑战性。为了应对这一挑战,我们提出了两种技术,InverseAug 和 LearnableAlign,以提高多模态特征之间的对齐质量。通过将这些技术集成到我们提出的 DeepFusion 方法的融合阶段,我们在 Waymo Open Dataset 上实现了最先进的性能。

致谢:

特别感谢合著者孟天健、Ben Caine、Jiquan Ngiam、Daiyi Peng、Junyang Shen、Bo Wu、Yifeng Lu、Denny Zhou、Quoc Le、Alan Yuille、Mingshing Tan。

评论