基于表单的文档理解是一个日益增长的研究课题,因为它具有将非结构化文本数据自动转换为结构化信息以深入了解文档内容的实际潜力。最近的序列建模是一种自注意力机制,它直接对选定文本中所有单词之间的关系进行建模,在自然语言任务上表现出了最先进的性能。处理表单文档理解任务的一种自然方法是首先序列化表单文档(通常以从左到右、从上到下的方式),然后将最先进的序列模型应用于它们。

然而,表单文档通常具有更复杂的布局,其中包含结构化对象,例如表格、列和文本块。它们的布局模式多种多样,使得序列化变得困难,从而大大限制了严格序列化方法的性能。表单文档结构建模中的这些独特挑战在文献中尚未得到充分探索。

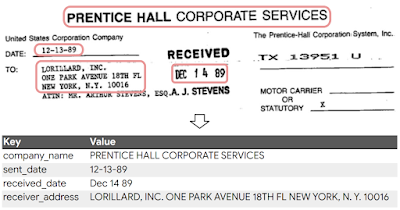

使用来自FUNSD数据集的示例来说明表单文档信息提取任务。

在ACL 2022上发表的 “ FormNet:表单文档信息提取中超越序列建模的结构编码”中,我们提出了一种结构感知序列模型 FormNet,以缓解用于文档信息提取的表单次优序列化问题。首先,我们设计了一种丰富的注意力机制( RichAtt ) ,利用单词标记之间的二维空间关系来更准确地计算注意力权重。然后,我们通过图卷积网络(GCN)嵌入来自相邻标记的表示,为每个单词构建超级标记(从相邻标记中聚合语义上有意义的信息的标记) 。最后,我们证明 FormNet 在使用更少的预训练数据的情况下优于现有方法,并在CORD、FUNSD和Payment基准上实现了最先进的性能。

FormNet 用于信息提取

给定一个表单文档,我们首先使用BERT-多语言词汇表和光学字符识别(OCR) 引擎来识别和标记单词。然后,我们将标记及其对应的 2D 坐标输入到 GCN 中进行图形构建和消息传递。接下来,我们使用带有建议的 RichAtt 机制的扩展 Transformer 构建(ETC) 层继续处理 GCN 编码的结构感知标记以进行模式学习(即语义实体提取)。最后,我们使用Viterbi 算法(该算法找到最大化后验概率的序列)来解码并获得最终的输出实体。

扩展变压器结构 (ETC)

我们采用ETC作为 FormNet 模型主干。ETC 通过将具有二次复杂度的标准注意力机制替换为稀疏全局-局部注意力机制(可区分全局和长输入标记),扩展到相对较长的输入。全局标记会关注所有标记并被所有标记关注,但长标记只会在本地关注指定局部半径内的其他长标记,从而降低复杂性,使其更易于管理长序列。

丰富的关注

我们的新架构 RichAtt 通过完全避免嵌入来避免绝对嵌入和相对嵌入 的缺陷。相反,它会计算标记对相对于布局网格上的 x 轴和 y 轴的顺序和对数距离,并根据这些值的直接函数调整每对标记的预softmax注意力得分。

在传统的注意层中,每个标记表示都会线性转换为查询向量、键向量和值向量。标记会“寻找”其他可能想要从中吸收信息(即关注)的标记,方法是找到具有键向量的标记,这些标记在与其查询向量进行矩阵乘法(称为Matmul)并进行 softmax 归一化时会产生相对较高的分数。然后,该标记将句子中所有其他标记的值向量相加,并按其分数加权,并将其传递给网络,通常会将其添加到标记的原始输入向量中。

但是,除了查询和键向量之外的其他特征通常也与决定一个标记应该多强地关注另一个给定标记有关,例如它们的顺序、它们之间有多少个其他标记,或者它们之间有多少个像素。为了将这些特征整合到系统中,我们使用了一个可训练的参数函数和一个误差网络,该网络采用观察到的特征和参数函数的输出,并返回一个降低点积注意力得分的惩罚。

网络使用查询和键向量来考虑如果标记相关则某些低级特征(例如距离)应该取什么值,并根据错误惩罚注意力分数。

从高层次来看,对于每一层的每个注意力头,FormNet 会检查每对 token 表示,如果 token 之间存在有意义的关系,则确定token 应该具有的理想特征,并根据实际特征与理想特征的差异来惩罚注意力分数。这使得模型能够使用逻辑蕴涵来学习注意力约束。

RichAtt 如何作用于句子的可视化。单词“crow”可能会关注三个形容词。“Lazy”在右边,所以它可能不会修饰“crow”,因此它的注意力边缘会受到惩罚。“Sly”距离单词“crow”有很多标记,因此它的注意力边缘也会受到惩罚。“Cunning”没有受到重大惩罚,因此通过排除法,它是最值得关注的候选词。

此外,如果假设 softmax 归一化的注意力分数代表概率分布,并且观察到的特征的分布是已知的,那么该算法(包括参数函数和误差函数的精确选择)就会在代数上失败,这意味着 FormNet 具有数学正确性,而许多替代方案(包括相对嵌入)都缺乏这种正确性。

通过图学习实现的超级代币

ETC 中长序列建模中注意力机制稀疏化的关键是让每个 token 只关注序列化序列中附近的 token。尽管 RichAtt 机制通过考虑空间布局结构为 transformer 提供了支持,但序列化不佳仍会阻碍相关单词 token 之间重要的注意力权重计算。

为了进一步缓解该问题,我们构建了一个图来连接表单文档中的邻近标记。我们根据强归纳偏差设计图的边缘,以便它们具有更高的属于同一实体类型的概率。对于每个标记,我们通过沿这些边缘应用图卷积来获得其超级标记嵌入,以聚合来自相邻标记的语义相关信息。然后,我们将这些超级标记用作 RichAtt ETC 架构的输入。这意味着,即使实体可能由于序列化不佳而被分解为多个段,GCN 学习到的超级标记仍将保留实体短语的大部分上下文。

FUNSD文档的词级图表说明,标记之间有蓝色边缘。

主要结果

下图显示了CORD基准上最新方法的模型大小与F1 分数(准确率和召回率的调和平均值)的关系。FormNet-A2 在使用小 2.5 倍的模型的情况下,其表现优于最新的DocFormer。FormNet -A3 以 97.28% 的 F1 分数实现了最先进的性能。有关更多实验结果,请参阅论文。

CORD 基准上的模型大小与实体提取 F1 分数。FormNet 在绝对 F1 性能和参数效率方面明显优于其他近期方法。

我们研究了 RichAtt 和 GCN 的 Super-Token 在三个 FormNets 的大规模掩码语言建模(MLM) 预训练任务中的重要性。RichAtt 和 GCN 组件在重建掩码标记方面都比 ETC 基线有了很大的改进,表明了它们在表单文档上结构化编码能力的有效性。当结合使用 RichAtt 和 GCN 时可获得最佳性能。

掩码语言建模 (MLM) 预训练的性能。提出的 RichAtt 和 Super-Token by GCN 组件都比 ETC 基线有了很大的改进,显示了其结构化编码能力对大规模表单文档的有效性。

使用BertViz,我们可视化了标准 ETC 和 FormNet 模型中 CORD 数据集中特定示例的局部到局部注意力得分。从定性上讲,我们确认对于 FormNet,这些标记主要关注同一可视块内的其他标记。此外,对于该模型,特定的注意力头关注水平对齐的标记,这是表单文档的强烈含义信号。ETC 模型没有出现清晰的注意力模式,这表明 RichAtt 和 GCN 的 Super-Token 使模型能够学习结构线索并有效利用布局信息。

ETC 和 FormNet(ETC+RichAtt+GCN)模型的注意力得分。与 ETC 模型不同,FormNet 模型让 token 关注同一视觉块内的其他 token,以及水平对齐的 token,从而充分利用结构线索。

结论

我们提出了 FormNet,一种用于基于表单的文档理解的新型模型架构。我们认为,新型 RichAtt 机制和 Super-Token 组件可帮助 ETC Transformer 在次优且嘈杂的序列化中表现出色,从而更好地理解表单。我们证明 FormNet 可恢复文本序列化过程中可能丢失的局部句法信息,并在三个基准测试中实现最佳性能。

致谢

本研究由 Chen-Yu Lee、Chun-Liang Li、Timothy Dozat、Vincent Perot、Guolong Su、Nan Hua、Joshua Ainslie、Renshen Wang、Yasuhisa Fujii 和 Tomas Pfister 进行。感谢 Evan Huang、Shengyang Dai 和 Salem Elie Haykal 提供的宝贵反馈,以及 Tom Small 制作本文中的动画。

评论