在自然对话中,我们不会每次交谈时都说出对方的名字。相反,我们依靠上下文信号机制来发起对话,而眼神交流通常就足够了。Google Assistant 目前已在 95 多个国家/地区和 29 多种语言中推出,它主要依靠热词机制(“Hey Google”或“OK Google”)帮助每月超过 7 亿人通过 Assistant 设备完成工作。随着虚拟助手成为我们日常生活中不可或缺的一部分,我们正在开发更自然地发起对话的方法。

在 2022 年 Google I/O 大会上,我们宣布推出 Look and Talk功能,这是我们在创建与搭载 Google Assistant 的家用设备进行自然直观交互方式的征程中取得的一项重大进展。这是首个多模式设备内置 Assistant 功能,可同时分析音频、视频和文本,以确定您何时与Nest Hub Max对话。结合使用八种机器学习模型,该算法可以区分有意的互动和一瞥,从而准确识别用户与 Assistant 互动的意图。一旦距离设备 5 英尺以内,用户只需看屏幕并说话即可开始与 Assistant 互动。

我们根据我们的AI 原则开发了 Look and Talk 。它符合我们严格的音频和视频处理要求,并且像我们的其他摄像头感应功能一样,视频永远不会离开设备。您可以随时在myactivity.google.com停止、查看和删除您的 Assistant 活动。这些额外的保护层使 Look and Talk 仅适用于打开它的用户,同时保证您的数据安全。

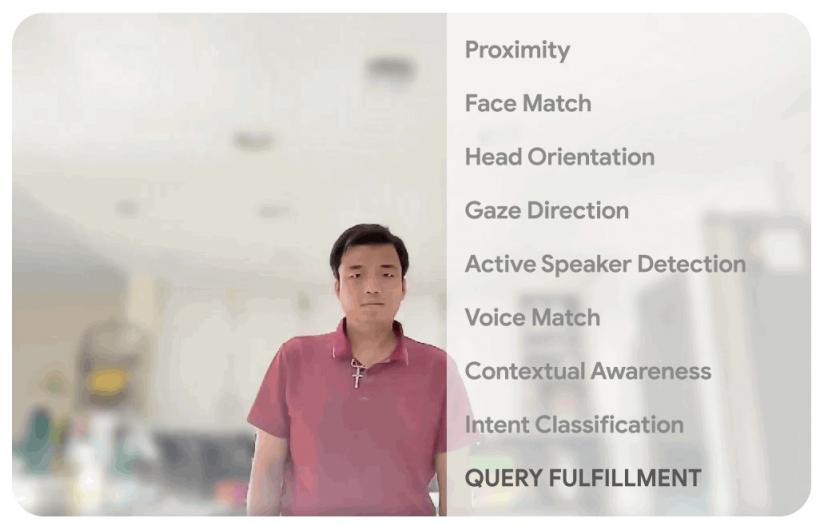

Google Assistant 依靠多种信号来准确判断用户何时与其对话。右侧是所使用的信号列表,其中的指示器根据用户与设备的距离和注视方向显示每个信号的触发时间。

建模挑战

此功能的开发始于一个基于为学术研究开发的模型的技术原型。然而,大规模部署需要解决此功能特有的现实挑战。它必须:

支持一系列人口统计特征(例如年龄、肤色)。

适应现实世界的环境多样性,包括具有挑战性的照明(例如背光、阴影图案)和声学条件(例如混响、背景噪音)。

处理不寻常的相机视角,因为智能显示器通常用作台面设备并仰视用户,这与研究数据集中通常用于训练模型的正面不同。

实时运行以确保在设备上处理视频时及时响应。

该算法的演变涉及多种方法的实验,从领域适应和个性化到特定领域的数据集开发、现场测试和反馈,以及整体算法的反复调整。

技术概述

Look and Talk 交互有三个阶段。在第一阶段,Assistant 使用视觉信号来检测用户何时表现出与其互动的意图,然后“唤醒”以聆听他们的话语。第二阶段旨在使用视觉和听觉信号进一步验证和理解用户的意图。Look and Talk 会考虑第一和第二个处理阶段中的所有信号,以确定交互是否可能是针对 Assistant 的。这两个阶段是 Look and Talk 的核心功能,下面将进行讨论。查询实现的第三阶段是典型的查询流程,超出了本博客的范围。

第一阶段:与助手互动

Look and Talk 的第一阶段旨在评估已注册用户是否有意与 Assistant 互动。Look and Talk 使用人脸检测来识别用户的存在,使用检测到的人脸框大小来推断距离,然后使用现有的Face Match系统来确定他们是否是已注册的 Look and Talk 用户。

对于范围内的注册用户,自定义眼球注视模型会确定他们是否正在看设备。该模型使用多塔卷积神经网络架构从图像帧中估算注视角度和二元注视相机置信度,其中一个塔处理整个面部,另一个塔处理眼睛周围的区域。由于设备屏幕覆盖了相机下方用户自然观看的区域,因此我们将注视角度和二元注视相机预测映射到设备屏幕区域。为了确保最终预测能够抵御虚假的个体预测和不自主的眨眼和扫视,我们对基于帧的各个预测应用了平滑函数,以消除虚假的个体预测。

眼动预测和后处理概述。

在通知用户系统已准备好进行交互之前,我们会强制执行更严格的注意力要求,以尽量减少误触发,例如,当路过的用户短暂瞥了一眼设备时。一旦看着设备的用户开始说话,我们就会放松注意力要求,让用户自然地转移视线。

此处理阶段所需的最终信号可检查人脸匹配用户是否为当前说话者。该信号由多模式当前说话者检测模型提供,该模型将用户面部视频和包含语音的音频作为输入,并预测他们是否正在说话。多种增强技术(包括RandAugment、SpecAugment和使用AudioSet声音增强)有助于提高家庭领域的预测质量,将最终功能性能提高 10% 以上。最终部署的模型是量化的、硬件加速的 TFLite模型,它使用五帧上下文作为视觉输入,0.5 秒作为音频输入。

主动说话人检测模型概述:双塔视听模型为人脸提供“说话”概率预测。视觉网络辅助预测推动视觉网络自身尽可能地发挥其优势,从而改善最终的多模态预测。

第二阶段:助手开始倾听

在第二阶段,系统开始聆听用户查询的内容(仍然完全在设备上),以使用其他信号进一步评估交互是否是针对 Assistant 的。首先,Look and Talk 使用语音匹配来进一步确保说话者已注册并与之前的 Face Match 信号相匹配。然后,它会在设备上运行最先进的自动语音识别模型来转录话语。

下一个关键处理步骤是意图理解算法,该算法可预测用户的话语是否是针对 Assistant 的查询。它包含两个部分:1)一个模型,分析音频中的非词汇信息(即音调、速度、犹豫音)以确定话语听起来是否像 Assistant 查询;2)一个文本分析模型,确定转录文本是否是 Assistant 请求。这些步骤共同过滤掉不是针对 Assistant 的查询。它还使用上下文视觉信号来确定交互针对 Assistant 的可能性。

语义过滤方法概述,用于确定用户话语是否是针对助手的查询。

最后,当意图理解模型确定用户话语很可能是针对助手的时,Look and Talk 进入实现阶段,在此阶段它会与助手服务器进行通信以获取对用户意图和查询文本的响应。

性能、个性化和用户体验

每个支持 Look and Talk 的模型都经过了独立评估和改进,然后在端到端 Look and Talk 系统中进行了测试。Look and Talk 运行的环境条件千差万别,因此必须引入个性化参数来提高算法的稳健性。通过使用在用户基于热词的交互过程中获得的信号,系统可以根据个人用户个性化参数,从而改进通用全局模型。这种个性化也完全在设备上运行。

如果没有预定义的热词作为用户意图的代理,延迟是 Look and Talk 的一个重大问题。通常,直到用户开始说话后才会出现足够强的交互信号,这可能会增加数百毫秒的延迟,而现有的意图理解模型会加剧这种情况,因为它们需要完整的查询,而不是部分的查询。为了弥补这一差距,Look and Talk 完全放弃了将音频流传输到服务器,而转录和意图理解则在设备上进行。意图理解模型可以根据部分话语进行工作。这导致端到端延迟与当前基于热词的系统相当。

UI 体验基于用户研究,提供均衡的视觉反馈和高度易学性。如下图所示。

左图:用户使用“看与说”功能的空间交互图。右图:用户界面 (UI) 体验。

我们开发了一个包含 3,000 多名参与者的多样化视频数据集,以跨人口统计子群体测试该功能。由训练数据多样性推动的建模改进提高了所有子群体的表现。

结论

Look and Talk 是朝着让用户尽可能自然地与 Google Assistant 互动迈出的重要一步。虽然这是我们旅程中的一个重要里程碑,但我们希望这只是我们互动模式的众多改进中的第一个,这些改进将继续负责任地重塑 Google Assistant 体验。我们的目标是让获得帮助变得自然而轻松,最终节省时间,让用户可以专注于最重要的事情。

致谢

这项工作需要软件工程师、研究人员、用户体验和跨职能贡献者组成的多学科团队的通力合作。Google Assistant 的主要贡献者包括 Alexey Galata、Alice Chuang、Barbara Wang、Britanie Hall、Gabriel Leblanc、Gloria McGee、Hideaki Matsui、James Zanoni、Joanna (Qiong) Huang、Krunal Shah、Kavitha Kandappan、Pedro Silva、Sai Aditya Chitturu、Tanya Sinha、Tuan Nguyen、Vishal Desai、Will Truong、Yixing Cai、Yunfan Ye;研究部门的贡献者包括 Hao Wu、Joseph Roth、Sagar Savla、Sourish Chaudhuri 和 Susanna Ricco。感谢 Yuan Yuan 和 Caroline Pantofaru 的领导,以及 Nest、Assistant 和研究团队中为 Look and Talk 的开发提供宝贵意见的每个人。

评论