进化策略(ES) 是一类受自然选择思想启发的优化技术:候选解决方案群体通常经过几代进化,以更好地适应优化目标。ES 已应用于各种具有挑战性的决策问题,例如腿部运动、四轴飞行器控制,甚至电力系统控制。

与基于梯度的强化学习(RL) 方法(如近端策略优化(PPO) 和软演员评论家(SAC))相比,ES 具有几个优势。首先,ES 直接在控制器参数空间中进行探索,而基于梯度的方法通常在有限的动作空间内进行探索,这间接影响控制器参数。研究表明,更直接的探索可以提高学习性能,并通过并行计算实现大规模数据收集。其次,RL 中的一个主要挑战是长期信用分配,例如,当机器人最终完成一项任务时,确定它过去执行的哪些动作最为关键,应分配更大的奖励。由于 ES 直接考虑总奖励,因此研究人员无需明确处理信用分配。此外,由于 ES 不依赖于梯度信息,它可以自然地处理高度非平滑的目标或梯度计算并非平凡的控制器架构,例如元强化学习。然而,基于 ES 的算法的一个主要弱点是它们难以扩展到需要高维感官输入来编码环境动态的问题,例如使用复杂视觉输入训练机器人。

在本研究中,我们提出了“ PI-ARS:通过预测信息表示加速进化学习的视觉运动”,这是一种将表示学习和 ES 相结合的学习算法,能够以可扩展的方式有效解决高维问题。其核心思想是利用预测信息(一种表示学习目标)来获得高维环境动态的紧凑表示,然后应用流行的 ES 算法增强随机搜索(ARS) 将学习到的紧凑表示转换为机器人动作。我们在有腿机器人的视觉运动这一具有挑战性的问题上测试了 PI-ARS。PI-ARS 能够快速训练高性能的基于视觉的运动控制器,这些控制器可以穿越各种困难的环境。此外,在模拟环境中训练的控制器可以成功转移到真实的四足机器人上。

PI-ARS 训练可靠的视觉运动策略,这些策略可以转移到现实世界。

预测信息

策略学习的良好表示应既具有压缩性,以便 ES 可以专注于解决比从原始观察中学习所需的低维问题,又具有任务关键性,以便学习到的控制器具有学习最佳行为所需的所有必要信息。对于具有高维输入空间的机器人控制问题,策略必须了解环境,包括机器人本身及其周围物体的动态信息。

因此,我们提出了一种观察编码器,它保留了原始输入观察中的信息,使策略能够预测环境的未来状态,因此称为预测信息(PI)。更具体地说,我们优化编码器,使得机器人过去看到和计划的内容的编码版本可以准确预测机器人未来可能会看到和获得奖励的内容。描述这种属性的一个数学工具是互信息,它衡量我们通过观察另一个随机变量Y获得的有关一个随机变量X的信息量。在我们的例子中,X和Y将是机器人过去看到和计划的内容,以及机器人未来看到和获得奖励的内容。直接优化互信息目标是一个具有挑战性的问题,因为我们通常只能访问随机变量的样本,而不能访问它们的底层分布。在这项工作中,我们遵循以前的方法,即使用InfoNCE,即互信息的对比变分界限来优化目标。

左图:我们使用表征学习对环境的 PI 进行编码。右图:我们通过重放来自重放缓冲区的轨迹来训练表征,并最大化过去的观察和运动计划与轨迹未来的观察和奖励之间的可预测性。

增强随机搜索的预测信息

接下来,我们将 PI 与增强随机搜索(ARS) 相结合,该算法在具有挑战性的决策任务中表现出色。在 ARS 的每次迭代中,它都会对一组受扰动的控制器参数进行采样,评估它们在测试环境中的性能,然后计算梯度,使控制器向性能更好的参数移动。

我们使用从 PI 中学习到的紧凑表示来连接 PI 和 ARS,我们称之为 PI-ARS。更具体地说,ARS 优化了一个控制器,该控制器将学习到的紧凑表示 PI 作为输入,并预测适当的机器人命令来完成任务。通过优化具有较小输入空间的控制器,它允许 ARS 更有效地找到最佳解决方案。同时,我们使用在 ARS 优化期间收集的数据来进一步改进学习到的表示,然后在下一次迭代中将其输入到 ARS 控制器中。

PI-ARS 数据流概述。我们的算法交错执行两个步骤:1) 优化更新策略的 PI 目标,即提取学习到的表示的神经网络的权重;2) 采样新轨迹并使用 ARS 更新控制器参数。

腿式机器人的视觉运动

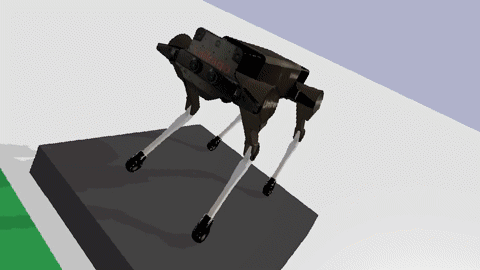

我们在腿式机器人的视觉运动问题上评估了 PI-ARS。我们选择这个问题有两个原因:视觉运动是腿式机器人应用于实际应用的一个关键瓶颈,而策略的高维视觉输入和腿式机器人的复杂动态使其成为展示 PI-ARS 算法有效性的理想测试案例。下面是我们在模拟中任务设置的演示。策略首先在模拟环境中进行训练,然后转移到硬件上。

视觉运动任务设置的图示。机器人配备两个摄像头来观察环境(由透明金字塔表示)。观察结果和机器人状态被发送到策略以生成高级运动计划,例如脚落地位置和所需的移动速度。然后由低级运动预测控制 (MPC) 控制器实现高级运动计划。

实验结果

我们首先在四个具有挑战性的模拟任务上评估 PI-ARS 算法:

不平坦的踏脚石:机器人需要在不平坦的地形上行走,同时避开缝隙。

梅花桩:机器人需要避开前方和侧面的空隙。

移动平台:机器人需要走过随机水平或垂直移动的踏脚石。与明确重建环境相比,此任务说明了学习基于视觉的策略的灵活性。

室内导航:机器人需要在室内环境中避开障碍物的同时导航到随机位置。

如下所示,PI-ARS 在全部四项任务中所能获得的总任务奖励方面均显著胜过 ARS(30-50%)。

左图:模拟中 PI-ARS 策略性能的可视化。右图: PI-ARS(绿线)和 ARS(红线)的总任务奖励(即情节回报)。PI-ARS 算法在四项具有挑战性的视觉运动任务中的表现明显优于 ARS。

我们进一步将训练好的策略部署到真正的Laikago机器人上,执行两项任务:随机踏脚石和室内导航。我们证明,我们训练好的策略可以成功处理现实世界的任务。值得注意的是,随机踏脚石任务的成功率从之前工作的40% 提高到了 100%。

PI-ARS 训练策略使真正的 Laikago 机器人能够绕过障碍物。

结论

在本研究中,我们提出了一种新的学习算法 PI-ARS,该算法将基于梯度的表示学习与无梯度的进化策略算法相结合,以充分利用两者的优势。PI-ARS 具有无梯度算法的有效性、简单性和可并行性,同时通过优化低维表示缓解了 ES 算法在处理高维问题时的一个关键瓶颈。我们将 PI-ARS 应用于一组具有挑战性的视觉运动任务,其中 PI-ARS 的表现明显优于最先进的技术。此外,我们在真实的四足机器人上验证了 PI-ARS 学到的策略。它使机器人能够走过随机放置的踏脚石并在有障碍物的室内空间中导航。我们的方法为将现代大型神经网络模型和大规模数据纳入机器人控制进化策略领域开辟了可能性。

致谢

我们要感谢我们的论文合著者:Ofir Nachum、Tingnan Zhang、Sergio Guadarrama 和 Jie Tan。我们还要感谢 Ian Fischer 和 John Canny 提供的宝贵反馈。

评论