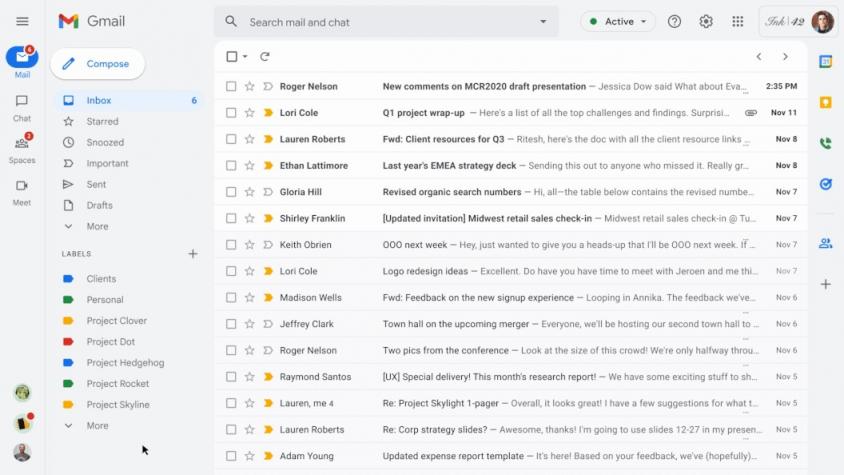

信息过载是当今许多组织和个人面临的重大挑战。每天处理收到的聊天消息和文档可能让人不堪重负。虚拟工作增加加剧了这一问题,而且随着许多团队过渡到混合工作环境(即虚拟和办公室混合工作),信息过载仍然是一项挑战。解决信息过载的一个解决方案是摘要 — 例如,为了帮助用户提高工作效率并更好地管理大量信息,我们最近在 Google Docs 中引入了自动生成的摘要。

今天,我们很高兴在 Google Chat 中推出 Spaces 消息对话摘要功能。当这些摘要可用时,当用户进入 Spaces 并收到未读消息时,会显示一张卡片,其中包含自动生成的摘要。该卡片包含 Spaces 中讨论的不同主题的摘要列表。此功能由我们最先进的抽象摘要模型Pegasus实现,该模型可为聊天对话生成实用而简洁的摘要,目前可供部分高级 Google Workspace 企业客户使用。

对话摘要提供了 Spaces 中对话的有用摘要,使用户可以快速查看未读消息并导航到最相关的主题。

对话摘要建模

文本摘要的目标是为不同类型的文本(例如文档、文章或口头对话)提供有用且简洁的摘要。好的摘要应简明扼要地涵盖要点,并且流畅且语法正确。摘要的一种方法是从文本中提取关键部分并将它们连接在一起形成摘要(即提取摘要)。另一种方法是使用自然语言生成(NLG)技术,使用原始文本中不一定存在的新单词和短语进行摘要。这被称为抽象摘要,被认为更接近于人类通常总结文本的方式。然而,抽象摘要的一个主要挑战是它有时难以生成准确且语法正确的摘要,尤其是在现实世界的应用中。

ForumSum 数据集

大多数抽象摘要数据集和研究都集中在单说话人文本文档上,例如新闻和科学文章,这主要是因为此类文档的人工撰写摘要非常丰富。另一方面,其他类型文本(例如聊天或多人对话)的人工撰写摘要数据集非常有限。

为了解决这个问题,我们创建了ForumSum,这是一个多样化且高质量的对话摘要数据集,其中包含人工撰写的摘要。数据集中的对话是从各种公共互联网论坛收集的,并经过清理和过滤以确保高质量和安全的内容(更多详细信息请参阅论文)。

来自 ForumSum 数据集的一个示例。

对话中的每句话都以新行开始,包含作者姓名和用冒号分隔的消息文本。然后向人工注释者提供详细说明,让他们写出 1-3 句对话摘要。这些说明经过多次迭代,以确保注释者写出高质量的摘要。我们收集了超过六千次对话的摘要,平均每次对话有超过 6 位发言者和 10 句话。ForumSum 为对话摘要问题提供了高质量的训练数据:它具有聊天应用程序中常见的各种主题、发言者和话语数量。

对话摘要模型设计

正如我们之前所写,Transformer是一种流行的模型架构,用于序列到序列任务,例如抽象摘要,其中输入是文档词,输出是摘要词。Pegasus将Transformer 与针对抽象摘要定制的自监督预训练相结合,使其成为对话摘要的绝佳模型选择。首先,我们在 ForumSum 数据集上对 Pegasus 进行微调,其中输入是对话词,输出是摘要词。其次,我们使用知识提炼将 Pegasus 模型提炼为Transformer 编码器和循环神经网络(RNN) 解码器的混合架构。生成的模型具有更低的延迟和内存占用,同时保持与 Pegasus 模型相似的质量。

质量和用户体验

好的摘要不仅要抓住对话的本质,还要流畅、语法正确。根据人工评估和用户反馈,我们了解到摘要模型在大多数情况下都能生成有用且准确的摘要。但有时该模型会生成低质量的摘要。在研究了用户报告的问题后,我们发现低质量摘要主要有两种类型。第一种是错误归因,即模型混淆了哪个人或实体说了或执行了某个动作。第二种是虚假陈述,即模型生成的摘要虚假陈述或与聊天对话相矛盾。

为了解决低质量摘要问题并改善用户体验,我们在以下几个方面取得了进展:

改进 ForumSum:虽然 ForumSum 可以很好地表示聊天对话,但我们注意到 Google Chat 对话中的某些模式和语言风格与 ForumSum 不同,例如,用户如何提及其他用户以及缩写和特殊符号的使用。在研究了用户报告的示例后,我们得出结论,这些分布不均匀的语言模式导致了低质量摘要。为了解决这个问题,我们首先执行了数据格式化和清理,以尽可能减少聊天和 ForumSum 对话之间的不匹配。其次,我们向 ForumSum 添加了更多训练数据,以更好地表示这些风格不匹配。总的来说,这些变化减少了低质量摘要。

受控触发:为了确保摘要为用户带来最大价值,我们首先需要确保聊天对话值得总结。例如,我们发现,当用户积极参与对话且没有太多未读消息时,或者对话太短时,生成摘要的价值就会降低。

检测低质量摘要:虽然上述两种方法限制了低质量和低价值摘要,但我们仍然开发了方法来检测此类摘要,并在生成摘要时避免向用户显示这些摘要。这些是一组启发式方法和模型,用于衡量摘要的整体质量以及它们是否存在错误归因或虚假陈述问题。

最后,虽然混合模型显著提高了性能,但当用户打开有未读消息的 Spaces 时,生成摘要的延迟仍然很明显。为了解决这个问题,我们改为在有新消息发送、编辑或删除时生成和更新摘要。然后摘要会被暂时缓存,以确保当用户打开有未读消息的 Spaces 时,摘要能够顺利显示出来。

结论和未来工作

我们很高兴能够应用最先进的抽象摘要模型来帮助我们的 Workspace 用户提高他们在 Spaces 中的工作效率。虽然这是一个巨大的进步,但我们相信还有很多机会可以进一步改善体验和摘要的整体质量。我们正在探索的未来方向包括更好地建模和总结包含多个主题的复杂对话,以及开发更好地衡量聊天对话和摘要之间事实一致性的指标。

致谢

作者要感谢 Google 内部为本文做出贡献的许多人员:Ahmed Chowdhury、Alejandro Elizondo、Anmol Tukrel、Benjamin Lee、Cameron Oelsen、Chao Wang、Chris Carroll、Don Kim、Hun Jung、Jackie Tsay、Jennifer Chou、Jesse Sliter、John Sipple、Jonathan Herzig、Kate Montgomery、Maalika Manoharan、Mahdis Mahdieh、Mia Chen、Misha Khalman、Peter Liu、Robert Diersing、Roee Aharoni、Sarah Read、Winnie Yeung、Yao Zhao 和 Yonghui Wu。

评论