近年来,机器学习领域取得了巨大进步,从能够解释笑话或回答各种语言的视觉问题的模型,到能够根据文本描述生成图像的模型。这些创新之所以成为可能,是因为大规模数据集的可用性不断提高,以及在这些数据上训练模型的新进展。虽然机器人模型的扩展取得了一些 成功,但由于缺乏与大型文本语料库或图像数据集相当的可用数据集,因此它被其他领域所超越。

今天,我们推出了PaLM-E,这是一种新型通用机器人模型,它通过将来自不同视觉和语言领域的知识转移到机器人系统来克服这些问题。我们从强大的大型语言模型PaLM开始,并通过机器人代理的传感器数据对其进行补充,将其“具体化”(PaLM-E 中的“ E ”)。这是与之前将大型语言模型引入机器人技术的努力的关键区别——使用 PaLM-E,我们不再仅仅依赖文本输入,而是训练语言模型直接获取机器人传感器数据的原始流。由此产生的模型不仅可以实现高效的机器人学习,而且还是最先进的通用视觉语言模型,同时保持了出色的纯语言任务能力。

具身语言模型 ,也是视觉语言通才

一方面,PaLM-E 主要被开发为机器人模型,它解决了多种机器人和多种模态(图像、机器人状态和神经场景表征 )的各种任务。同时,PaLM-E 是一个通用的视觉和语言模型。它可以执行视觉任务,例如描述图像、检测物体或对场景进行分类,并且还擅长语言任务,例如引用诗歌、解决数学方程式或生成代码。

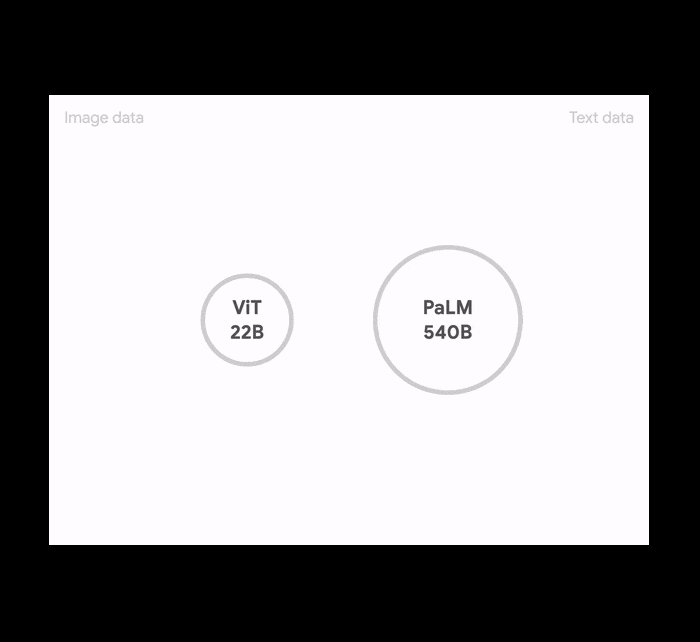

PaLM-E 将我们最新的大型语言模型PaLM与我们最先进的视觉模型之一ViT-22B结合在一起。这种方法的最大实例建立在 PaLM-540B 之上,称为 PaLM-E-562B,它在视觉语言OK-VQA基准上创下了新的最高水平,无需针对特定任务进行微调,同时基本保留了与 PaLM-540B 相同的一般语言性能。

PaLM-E 如何工作?

从技术上讲,PaLM-E 的工作原理是将观察结果注入预先训练的语言模型。具体方法是将传感器数据(例如图像)转换为表示形式,这个过程类似于语言模型处理自然语言单词的过程。

语言模型依靠一种机制,以神经网络可以处理的方式用数学方式表示文本。这是通过首先将文本拆分成所谓的标记来实现的,这些标记对(子)单词进行编码,每个标记都与一个高维数字向量(即标记嵌入)相关联。然后,语言模型能够对得到的向量序列应用数学运算(例如矩阵乘法)来预测下一个最可能的单词标记。通过将新预测的单词反馈给输入,语言模型可以迭代地生成越来越长的文本。

PaLM-E 的输入是文本和其他模态(图像、机器人状态、场景嵌入等),顺序任意,我们称之为“多模态句子”。例如,输入可能看起来像“<img_1> 和 <img_2> 之间发生了什么?”,其中 <img_1> 和 <img_2> 是两张图片。输出是PaLM -E 自回归生成的文本,可以是问题的答案,也可以是文本形式的一系列决策。

PaLM-E 模型架构,展示了 PaLM-E 如何摄取不同的模态(状态和/或图像)并通过多模态语言建模解决任务。

PaLM-E 的理念是训练编码器,将各种输入转换为与自然单词标记嵌入相同的空间。这些连续输入被映射到类似于“单词”的东西中(尽管它们不一定形成离散集)。由于单词和图像嵌入现在具有相同的维度,因此可以将它们输入到语言模型中。

我们使用语言( PaLM)和视觉组件(Vision Transformer ,又名 ViT) 的预训练模型初始化 PaLM-E 以进行训练。模型的所有参数都可以在训练期间更新。

将大规模训练中的知识转移到机器人

PaLM-E 提供了一种训练通用模型的新范式,该范式通过一个共同的表示将机器人任务和视觉语言任务结合在一起来实现:以图像和文本作为输入,并输出文本。一个关键结果是,PaLM-E 从视觉和语言领域实现了显著的正向 知识转移,从而提高了机器人学习的效率。

从一般视觉语言任务中积极 转移 知识可以实现更有效的机器人学习,这从三种不同的机器人实施例和领域中可见一斑。

结果表明,与针对单个任务训练单个模型相比,PaLM-E 可以同时处理大量机器人、视觉和语言任务,且性能不会下降。此外,视觉语言数据实际上显著提高了机器人任务的性能。这种迁移使 PaLM-E 能够根据解决任务所需的示例数量高效地学习机器人任务。

结果

我们在三个机器人环境中评估了 PaLM-E,其中两个涉及真实机器人,以及一般的视觉语言任务,例如视觉问答 (VQA)、图像字幕和一般语言任务。当 PaLM-E 负责对机器人做出决策时,我们会将其与低级 语言到动作策略配对,以将文本转换为低级机器人动作。

在下面的第一个例子中,一个人要求移动机器人将一袋薯片带给他们。为了成功完成任务,PaLM-E 会制定一个计划来找到抽屉并打开它,然后在执行任务时通过更新其计划来响应世界的变化。在第二个例子中,要求机器人抓取一个绿色积木。即使该机器人没有看到过这个积木,PaLM-E 仍然会生成一个分步计划,该计划可以超越该机器人的训练数据。

PaLM-E 控制在厨房环境中运行的移动机器人。 左图:任务是取回薯片袋。PaLM-E 表现出对对抗性干扰的鲁棒性,例如将薯片袋放回抽屉。右图:执行计划以检索之前未见过的积木(绿色星星)的最后步骤。这种能力是由视觉和语言模型的迁移学习实现的。

在下面的第二个环境中,同一个 PaLM-E 模型在不同类型的机器人上解决了非常长远的精确任务,例如“按颜色将积木分类到角落”。它直接查看图像并生成一系列较短的文本表示动作 - 例如,“将蓝色立方体推到右下角”,“将蓝色三角形也推到那里。” - 这些长远任务超出了自主完成的范围,即使在我们自己最新的模型中也是如此。我们还展示了泛化到训练期间未见过的新任务的能力(零样本泛化),例如将红色积木推到咖啡杯中。

PaLM-E 控制桌面机器人成功完成远距离任务。

第三个机器人环境的灵感来自任务和运动规划(TAMP)领域,该领域研究具有组合挑战性的规划任务(重新排列物体),这些任务会给机器人带来大量可能的动作序列。我们表明,借助来自专家 TAMP 规划师的少量训练数据,PaLM-E 不仅能够解决这些任务,而且还能利用视觉和语言知识迁移来更有效地完成这些任务。

PaLM-E 为任务和运动规划环境制定计划。

作为视觉语言通才,PaLM-E 是一款极具竞争力的模型,甚至可与Flamingo和PaLI 等最佳视觉语言专用模型相媲美。尤其是,PaLM-E-562B 在具有挑战性的OK-VQA数据集上取得了有史以来最高的成绩,该数据集不仅需要视觉理解,还需要外部世界知识。此外,这一结果是通过通才模型实现的,无需专门针对该任务进行微调。

PaLM-E 展现了视觉思维链推理等能力,其中模型将其回答过程分解为更小的步骤,这种能力迄今为止仅在语言领域得到展示。该模型还展示了对多幅图像进行推理的能力,尽管只对单幅图像提示进行训练。纽约尼克斯队和波士顿凯尔特人队的照片符合CC-by-2.0条款,由 kowarski 发布到 Flickr。科比·布莱恩特的照片属于公共领域。其他照片由我们拍摄。

结论

PaLM-E 突破了通用模型的训练界限,使其能够同时处理视觉、语言和机器人技术,同时还能够将视觉和语言领域的知识转移到机器人领域。本文还详细研究了其他主题,例如如何利用PaLM-E 的神经场景表征,以及模型规模更大的 PaLM-E 在多大程度上不会经历语言能力的灾难性遗忘。

PaLM-E 不仅为构建能够从其他数据源中受益的更强大的机器人提供了一条途径,而且还可能成为使用多模式学习的其他更广泛应用的关键推动因素,包括统一迄今为止看似独立的任务的能力。

致谢

这项工作由 Google 的多个团队合作完成,包括 Google 机器人团队和 Brain 团队,以及柏林工业大学。合著者:Igor Mordatch、Andy Zeng、Aakanksha Chowdhery、Klaus Greff、Mehdi SM Sajjadi、Daniel Duckworth、Corey Lynch、Ayzaan Wahid、Jonathan Tompson、Fei Xia、Brian Ichter、Karol Hausman、Tianhe Yu、Quan Vuong、Yevgen Chebotar、Wenlong Huang、Pierre Sermanet、Sergey Levine、Vincent Vanhoucke 和 Marc Toussiant。Danny 是柏林工业大学 Marc Toussaint 指导的博士生。我们还要感谢其他几位同事的建议和帮助,包括 Xi Chen、Etienne Pot、Sebastian Goodman、Maria Attarian、Ted Xiao、Keerthana Gopalakrishnan、Kehang Han、Henryk Michalewski、Neil Houlsby、Basil Mustafa、Justin Gilmer、Yonghui Wu、Erica Moreira、Victor Gomes、Tom Duerig、Mario Lucic、Henning Meyer 和 Kendra Byrne。

评论