Google 将AI 视为一项基础性和变革性技术,近年来,生成式 AI 技术取得了进展,例如LaMDA、PaLM、Imagen、Parti、MusicLM和类似的机器学习 (ML) 模型,其中一些现已被整合到我们的产品中。这种变革潜力要求我们不仅要对如何推进我们的技术负责,还要对如何设想要构建哪些技术以及如何评估 AI 和 ML 支持的技术对世界产生的社会影响负责。这项工作需要以跨学科的视角进行基础研究和应用研究,这些研究涉及并考虑影响 AI 系统开发和部署的社会、文化、经济和其他背景维度。我们还必须了解此类技术的持续使用可能对弱势群体和更广泛的社会系统产生的一系列影响。

我们的团队,技术、人工智能、社会和文化 (TASC),正在解决这一关键需求。对人工智能社会影响的研究是复杂而多方面的;没有任何一个学科或方法论观点能够单独提供应对机器学习技术的社会和文化影响所需的多样化见解。因此,TASC 利用跨学科团队的优势,其背景涵盖计算机科学、社会科学、数字媒体和城市科学。我们使用多方法方法,结合定性、定量和混合方法来批判性地审查和塑造支撑和围绕人工智能技术的社会和技术过程。我们专注于参与性、文化包容性和交叉公平导向的研究,将受影响的社区放在首位。我们的工作推动了负责任的人工智能 (RAI) 在计算机视觉、自然语言处理、健康和通用机器学习模型和应用程序等领域的发展。下面,我们分享了负责任人工智能方法的示例以及我们在 2023 年的发展方向。

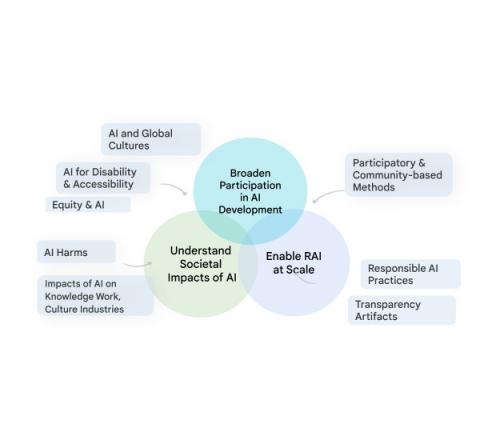

TASC 研究的各种社会、技术和公平导向研究领域的可视化图表,旨在以尊重人工智能与社会之间复杂关系的方式推进负责任的人工智能。

主题 1:文化、社区和人工智能

我们的主要研究领域之一是通过社区参与和文化包容的方法 ,改进方法,使生成式 AI 技术更具包容性,对全球人民更有价值。为了实现这一目标,我们将社区视为其所在领域的专家,认识到他们对技术能够并且应该如何影响他们自己的生活有着深刻的了解。我们的研究强调了在整个 ML 开发流程中嵌入跨文化考虑的重要性。社区参与使我们能够改变在整个流程中整合最重要知识的方式,从数据集管理到评估。这也使我们能够理解和解释技术失败的方式以及特定社区可能遭受的伤害。基于这种理解,我们创建了负责任的 AI 评估策略,这些策略可有效识别和减轻多个维度的偏见。

我们在这一领域的工作对于确保 Google 的技术对全球各种利益相关者而言都是安全的、有效的和有用的至关重要。例如,我们针对全球南方国家开展的关于用户对 AI 的态度、负责任的交互设计和公平性评估的研究展示了 AI 影响的跨文化差异,并贡献了支持文化评估的资源。我们还通过最近和即将举办的关于 AI 中的文化/文化中的 AI、计算机视觉创造性应用中的道德考量以及 NLP 中的跨文化考量等研讨会,建立了跨学科研究社区,以研究AI、文化和社会之间的关系。

我们最近的研究还寻求了在机器学习开发和应用中代表性较低的特定群体的观点。例如,我们调查了自然语言和性别包容性健康等背景下的性别偏见,并利用我们的研究成果对偏见进行更准确的评估,以便开发这些技术的任何人都可以识别和减轻对具有酷儿和非二元身份的人的伤害。

主题 2:在整个开发生命周期中实现负责任的人工智能

我们致力于大规模实现 RAI,通过在整个开发流程中为 RAI 建立行业最佳实践,并确保我们的技术默认可验证地纳入该最佳实践。这项应用研究包括负责任地生成和分析 ML 开发数据,以及系统地推进支持从业者实现透明度、公平性和问责制等关键 RAI 目标的工具和实践。在数据卡、模型卡和模型卡工具包方面的扩展,我们发布了数据卡手册,为开发人员提供方法和工具来记录与数据集相关的适当用途和基本事实。由于 ML 模型通常在人工注释的数据上进行训练和评估,因此我们还推进了以人为本的数据注释研究。我们已经开发了框架来记录注释过程和方法,以解决评估者分歧和评估者多样性问题。这些方法使 ML 从业者能够通过识别当前的障碍和重新设想数据工作实践, 更好地确保用于训练模型的数据集注释的多样性。

未来方向

我们正在努力进一步扩大 ML 模型开发的参与度,通过将多种文化背景和声音融入技术设计、开发和影响评估中,确保 AI 实现社会目标。我们还在重新定义负责任的做法,以应对当今世界 ML 技术运行的规模。例如,我们正在开发框架和结构,以促进社区参与行业 AI 研发,包括以社区为中心的评估框架、基准以及数据集管理和共享。

具体来说,我们正在进一步研究NLP 语言模型如何延续对残疾人的偏见,并将这项研究扩展到其他边缘化社区和文化,包括图像、视频和其他多模态模型。这些模型可能包含关于特定群体的比喻和刻板印象,或者可能抹去特定个人或社区的经历。我们努力识别 ML 模型中的偏见来源,这将有助于更好地检测这些表征危害,并将支持创建更公平、更包容的系统。

TASC 旨在研究人工智能与人类之间的所有接触点——从个人和社区到文化和社会。为了使人工智能具有文化包容性、公平性、可访问性并反映受影响社区的需求,我们必须通过以受影响社区的需求为中心的跨学科和多学科研究来应对这些挑战。我们的研究将继续探索社会与人工智能之间的互动,进一步发现开发和评估人工智能的新方法,以便我们开发出更强大、更符合文化的人工智能技术。

致谢

我们想感谢团队中为这篇博文做出贡献的每一个人。按姓氏字母顺序排列:Cynthia Bennett、Eric Corbett、Aida Mostafazadeh Davani、Emily Denton、Sunipa Dev、Fernando Diaz、Mark Díaz、Shaun Kane、Shivani Kapania、Michael Madaio、Vinodkumar Prabhakaran、Rida Qadri、Renee Shelby、Ding Wang 和 Andrew Zaldivar。此外,我们还要感谢 Toju Duke 和 Marian Croak 提供的宝贵反馈和建议。

评论