过去几年来,自动处理复杂商业文档并将其转换为结构化对象的系统取得了快速进展。可以自动从收据、保险报价和财务报表等文档中提取数据的系统有可能通过避免容易出错的手动工作来大幅提高业务工作流程的效率。基于Transformer架构的最新模型在准确性方面已显示出令人瞩目的提升。更大的模型(如PaLM 2)也被用来进一步简化这些业务工作流程。然而,学术文献中使用的数据集未能捕捉到现实世界用例中看到的挑战。因此,学术基准测试报告了很高的模型准确性,但这些模型在用于复杂的现实世界应用时表现不佳。

在KDD 2023上发表的 “ VRDU:视觉丰富文档理解的基准”中,我们宣布发布新的视觉丰富文档理解(VRDU) 数据集,旨在弥合这一差距并帮助研究人员更好地跟踪文档理解任务的进展。我们根据文档理解模型经常使用的现实世界文档类型,列出了良好文档理解基准的五个要求。然后,我们描述了研究界目前使用的大多数数据集如何未能满足这些要求中的一个或多个,而 VRDU 满足所有要求。我们很高兴地宣布根据知识共享许可公开发布 VRDU数据集和评估代码。

基准测试要求

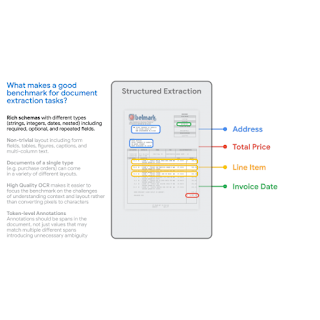

首先,我们将现实世界用例中 最先进的模型准确率(例如FormNet和LayoutLMv2 )与学术基准(例如FUNSD、CORD、SROIE)进行了比较。我们发现,最先进的模型与学术基准结果不符,在现实世界中的准确率要低得多。接下来,我们将文档理解模型经常使用的典型数据集与学术基准进行了比较,并确定了五个数据集要求,这些要求使数据集能够更好地捕捉现实世界应用程序的复杂性:

丰富的模式:在实践中,我们看到了各种各样的结构化提取的丰富模式。实体具有不同的数据类型(数字、字符串、日期等),这些数据类型可能是必需的、可选的或在单个文档中重复的,甚至可能是嵌套的。针对简单的平面模式(如标题、问题、答案)的提取任务并不能反映实践中遇到的典型问题。

布局丰富的文档:文档应该具有复杂的布局元素。实际设置中的挑战来自于这样的事实:文档可能包含表格、键值对、在单列和双列布局之间切换、不同部分的字体大小不同、包含带标题甚至脚注的图片。与此形成对比的是,大多数文档都以句子、段落和带有节标题的章节的形式组织起来的数据集——这些文档通常是经典自然语言处理文献对长 输入的关注重点。

多样化模板:基准测试应包含不同的结构布局或模板。对于高容量模型来说,通过记忆结构从特定模板中提取数据是轻而易举的。然而,在实践中,需要能够推广到新的模板/布局,这是基准测试中的训练测试拆分应该衡量的能力。

高质量 OCR:文档应具有高质量的光学字符识别(OCR) 结果。我们制定此基准的目的是专注于 VRDU 任务本身,并排除因选择 OCR 引擎而带来的可变性。

标记级注释:文档应包含可映射回相应输入文本的真实注释,以便每个标记都可以作为相应实体的一部分进行注释。这与仅提供要为实体提取的值的文本形成对比。这是生成干净的训练数据的关键,我们不必担心与给定值的偶然匹配。例如,在某些收据中,如果税额为零,则“税前总额”字段可能与“总额”字段具有相同的值。使用标记级注释可以防止我们生成训练数据,其中匹配值的两个实例都被标记为“总额”字段的真实值,从而产生嘈杂的示例。

VRDU 数据集和任务

VRDU 数据集是两个公开数据集(注册表格和广告购买表格)的组合。这些数据集提供了代表现实世界用例的示例,并满足上述五个基准要求。

Ad-buy Forms 数据集包含 641 份包含政治广告详细信息的文档。每份文档都是电视台和竞选团队签署的发票或收据。文档使用表格、多列和键值对来记录广告信息,例如产品名称、播出日期、总价以及发布日期和时间。

登记表数据集包含 1,915 份文件,其中包含有关在美国政府登记的外国代理人的信息。每份文件都记录了参与需要公开披露的活动的外国代理人的基本信息。内容包括登记人的姓名、相关机构的地址、活动目的和其他详细信息。

我们从公共联邦通信委员会(FCC) 和外国代理人登记法(FARA) 站点随机收集了一批文件样本,并使用Google Cloud 的 OCR将图像转换为文本。我们丢弃了少数长达数页且处理未在两分钟内完成的文件。这也让我们避免发送非常长的文档进行手动注释 - 这项任务可能需要一个多小时才能完成单个文档。然后,我们为一支有文档标记任务经验的注释团队定义了架构和相应的标记说明。

我们还向标注者提供了一些我们自己标注的样本标注文档。该任务要求标注者检查每个文档,在每个文档的架构中实体出现的每个位置周围绘制一个边界框,并将该边界框与目标实体关联起来。在第一轮标注之后,会指派一组专家来审查结果。更正后的结果包含在已发布的 VRDU 数据集中。有关每个数据集的标注协议和架构的更多详细信息, 请参阅论文。

现有的学术基准(FUNSD、CORD、SROIE、Kleister-NDA、Kleister-Charity、DeepForm)未能满足我们确定的良好文档理解基准的五个要求中的一个或多个。VRDU 满足所有要求。请参阅我们的论文,了解每个数据集的背景以及它们未能满足一个或多个要求的原因。

我们分别构建了四个不同的模型训练集,样本量分别为 10、50、100 和 200。然后,我们使用三个任务(如下所述)评估 VRDU 数据集:(1) 单模板学习、(2) 混合模板学习和 (3) 未见模板学习。对于每个任务,我们在测试集中包含了 300 篇文档。我们使用测试集上的 F1 分数来评估模型。

单模板学习(STL):这是最简单的场景,其中训练、测试和验证集仅包含单个模板。这个简单的任务旨在评估模型处理固定模板的能力。当然,我们期望这个任务的 F1 分数非常高 (0.90+)。

混合模板学习(MTL):此任务与大多数相关论文使用的任务类似:训练、测试和验证集都包含属于同一模板集的文档。我们从数据集中随机抽取文档并构建分割,以确保每个模板的分布在抽样过程中不会发生变化。

未见模板学习(UTL):这是最具挑战性的设置,我们评估模型是否可以推广到未见模板。例如,在注册表单数据集中,我们使用三个模板中的两个来训练模型,并使用剩下的一个来测试模型。训练、测试和验证集中的文档来自不相交的模板集。据我们所知,以前的基准和数据集没有明确提供这样的任务,旨在评估模型推广到训练期间未见过的模板的能力。

目标是能够评估模型的数据效率。在我们的论文中,我们使用 STL、MTL 和 UTL 任务比较了两个最近的模型,并得出了三个观察结果。首先,与其他基准测试不同,VRDU 具有挑战性,表明模型有很大的改进空间。其次,我们表明,即使是最先进的模型,小样本性能也出奇地低,即使是最好的模型,F1 得分也低于 0.60。第三,我们表明模型很难处理结构化重复字段,并且在这些字段上的表现特别差。

结论

我们发布了新的视觉丰富文档理解(VRDU) 数据集,帮助研究人员更好地跟踪文档理解任务的进展。我们描述了 VRDU 为何能更好地反映该领域的实际挑战。我们还进行了实验,表明 VRDU 任务具有挑战性,并且与文献中通常使用的数据集相比,最近的模型有很大的改进空间,F1 得分通常为 0.90+。我们希望 VRDU 数据集和评估代码的发布能帮助研究团队提高文档理解的最新水平。

致谢

非常感谢与 Sandeep Tata 共同撰写该论文的 Zilong Wang、Yichao Zhou、Wei Wei 和 Chen-Yu Lee。感谢 Marc Najork、Riham Mansour 以及 Google Research 和 Cloud AI 团队的众多合作伙伴提供的宝贵见解。感谢 John Guilyard 为本文制作动画。

评论