提示大型语言模型 (LLM) 已成为一种有效的学习范式,可通过调节人为设计的指令使 LLM 适应新任务。LLM 卓越的上下文学习(ICL) 能力还可带来高效的小样本学习器,该学习器可从小样本输入标签对中进行泛化。然而,LLM 的预测对模板、标签空间(如是/否、真/假、正确/不正确)和演示示例的选择高度敏感甚至有偏差,从而导致意外的性能下降并阻碍实现稳健的 LLM 应用。为了解决这个问题,已经开发了校准方法来减轻这些偏差的影响,同时恢复 LLM 性能。虽然已经提供了多种校准解决方案(例如,上下文校准和领域上下文校准),但该领域目前缺乏统一的分析来系统地区分和解释每种方法的独特特征、优点和缺点。

提示大型语言模型 (LLM) 已成为一种有效的学习范式,可通过调节人为设计的指令使 LLM 适应新任务。LLM 卓越的上下文学习(ICL) 能力还可带来高效的小样本学习器,该学习器可从小样本输入标签对中进行泛化。然而,LLM 的预测对模板、标签空间(如是/否、真/假、正确/不正确)和演示示例的选择高度敏感甚至有偏差,从而导致意外的性能下降并阻碍实现稳健的 LLM 应用。为了解决这个问题,已经开发了校准方法来减轻这些偏差的影响,同时恢复 LLM 性能。虽然已经提供了多种校准解决方案(例如,上下文校准和领域上下文校准),但该领域目前缺乏统一的分析来系统地区分和解释每种方法的独特特征、优点和缺点。

考虑到这一点,在“批量校准:重新思考上下文学习和快速工程的校准”一文中,我们对现有的校准方法进行了系统分析,在分析中我们既提供了统一的观点,也揭示了失败的案例。受这些分析的启发,我们提出了批量校准 (BC),这是一种简单而直观的方法,可以减轻一批输入带来的偏差,统一各种先前的方法,并有效地解决以前方法的局限性。BC 是零样本、自适应的(即仅推理),并且几乎不会产生额外成本。我们使用PaLM 2和CLIP模型验证了 BC 的有效性,并在 10 多个自然语言理解和图像分类任务中展示了优于先前校准基线的最优性能。

动机

为了寻求 ICL 校准的实用指南,我们首先了解了当前方法的局限性。我们发现校准问题可以构建为无监督决策边界学习问题。我们观察到未校准的 ICL 可能倾向于预测某个类别,我们明确将其称为情境偏差,即LLM 在给定情境的情况下先验倾向于预测某些类别而不是其他类别,这是不公平的。例如,LLM 的预测可能偏向于预测最常见的标签或演示结束时的标签。我们发现,虽然理论上更灵活,但非线性边界(原型校准)往往容易过度拟合,并且在具有挑战性的多类任务中可能会不稳定。相反,我们发现线性决策边界在任务之间更稳健且更具泛化性。此外,我们发现,依靠额外的无内容输入(例如“N/A”或随机域内标记)作为估计上下文偏差的依据并不总是最佳的,甚至可能引入额外的偏差,这取决于任务类型。

批量校准

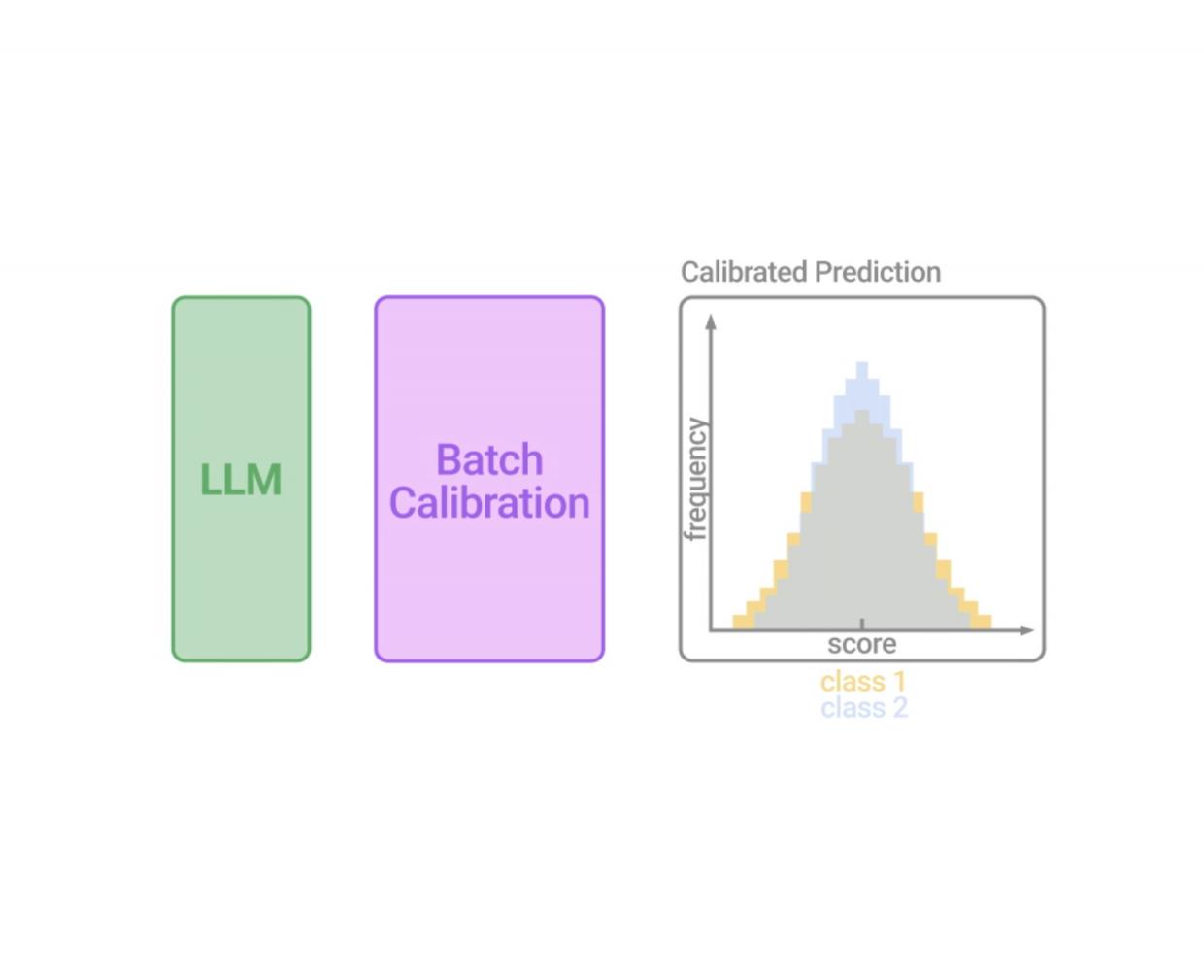

受之前讨论的启发,我们将 BC 设计为一种零样本、仅推理且可推广的校准技术,计算成本可忽略不计。我们认为校准的最关键部分是准确估计上下文偏差。因此,我们选择线性决策边界以保证其稳健性,并且我们建议不依赖无内容输入,而是通过边缘化批次内所有样本的输出分数,以基于内容的方式估计批次中每个类别的上下文偏差,这相当于测量每个类别的平均分数(如下图所示)。

然后,我们通过将输出概率除以上下文先验来获得校准概率,这相当于将对数概率(LLM 分数)分布与每个类的估计平均值对齐。值得注意的是,由于它不需要额外的输入来估计偏差,因此此 BC 程序是零样本的,仅涉及未标记的测试样本,并且计算成本可以忽略不计。我们可以在看到所有测试样本后计算上下文偏差,或者以动态处理输出的即时方式计算上下文偏差。为此,我们可以使用 BC 上下文偏差的运行估计,从而允许从少量小批量中估计 BC 的校准项,并在更多小批量到达时稳定下来。

批量校准 (BC) 说明。带有上下文示例和测试样本的批量演示被传递到 LLM。由于上下文中存在隐性偏见,LLM 的分数分布会出现偏差。BC 是一个模块化且可适应的层选项,附加到 LLM 的输出中,可生成校准分数(仅用于说明)。

实验设计

对于自然语言任务,我们在 13 个更加多样化和具有挑战性的分类任务上进行了实验,包括标准GLUE和SuperGLUE数据集。这与之前仅报告相对简单的单句分类任务的研究形成了鲜明对比。对于图像分类任务,我们包括SVHN、EuroSAT和CLEVR。我们主要在最先进的PaLM 2上进行实验,其尺寸变体包括 PaLM 2-S、PaLM 2-M 和 PaLM 2-L。对于 VLM,我们报告了CLIP ViT-B/16上的结果。

结果

值得注意的是,BC 的表现始终优于 ICL,在 PaLM 2 的小型和大型变体上分别实现了 8% 和 6% 的显著性能提升。这表明 BC 实现成功缓解了上下文示例的上下文偏差,并充分发挥了 LLM 在高效学习和快速适应新任务方面的潜力。此外,BC 在 PaLM 2-S 上比最先进的原型校准 (PC) 基线提高了 6%,在 PaLM 2-L 上比竞争性上下文校准 (CC) 基线平均提高了 3%。具体而言,BC 是一种适用于所有评估任务的通用且更便宜的技术,可提供稳定的性能改进,而之前的基线在不同任务中表现出不同程度的性能。

批量校准 (BC) 在校准基线上的 1-shot ICL 上取得了最佳性能: 在 PaLM 2 上的平均 13 个 NLP 任务中的上下文校准(CC)、域上下文校准(DC) 和原型校准(PC),并且在图像任务上优于零样本 CLIP。

我们通过将 ICL 镜头数量从 0 变为 4 来分析 BC 的性能,BC 再次优于所有基线方法。我们还观察到,当镜头数量更多时,性能总体呈改善趋势,其中 BC 表现出最佳稳定性。

ICL 在各种校准技术上的表现与 PaLM 2-S 上的 ICL 拍摄次数有关。我们将 BC 与未校准的 ICL、上下文校准(CC)、域上下文校准(DC) 和原型校准(PC) 基线进行了比较。

在应用现有校准方法和所提出的 BC 后,我们进一步可视化了未校准 ICL 的决策边界。我们展示了每种基线方法的成功和失败案例,而 BC 始终有效。

未校准 ICL 的决策边界可视化,以及在 1-shot PaLM 2-S 上的SST-2(上行)和QNLI(下行)的代表性二元分类任务中应用现有校准方法和所提出的 BC 之后的可视化。每个轴表示定义标签上的 LLM 分数。

稳健性和消融研究

我们分析了 BC 对常见提示工程设计选择的稳健性,这些选择之前已被证明会显著影响 LLM 性能:上下文示例的选择和顺序、ICL 的提示模板和标签空间。首先,我们发现 BC 对 ICL 选择更稳健,并且几乎可以使用不同的 ICL 示例实现相同的性能。此外,给定一组 ICL 镜头,改变每个 ICL 示例之间的顺序对 BC 性能的影响很小。此外,我们分析了 10 种提示模板设计下的 BC 的稳健性,其中 BC 显示出对 ICL 基线的持续改进。因此,虽然 BC 提高了性能,但精心设计的模板可以进一步提高 BC 的性能。最后,我们检查了 BC 对标签空间设计变化的稳健性(参见我们论文中的附录)。值得注意的是,即使在使用表情符号对等非常规选择作为标签时,导致 ICL 性能剧烈波动,BC 也能在很大程度上恢复性能。这一观察结果表明,BC 提高了常见提示设计选择下 LLM 预测的稳健性,并使提示工程变得更容易。

批量校准使快速工程变得更加简单,同时提高了数据效率。数据以标准箱线图的形式可视化,其中显示了中位数、第一和第三四分位数以及最小值和最大值。

此外,我们研究了批次大小对 BC 性能的影响。与同样利用未标记估计集的 PC 相比,BC 的样本效率明显更高,仅使用约 10 个未标记样本即可实现强劲性能,而 PC 需要超过 500 个未标记样本才能使其性能稳定下来。

批量校准使快速工程变得更容易,同时不受批量大小的影响。

结论

我们首先回顾了以前的校准方法,同时从对决策边界的解释出发,解决了两个关键的研究问题,揭示了它们的失败案例和缺陷。然后,我们提出了批量校准,这是一种零样本和仅推理的校准技术。虽然方法简单且易于实现,计算成本可以忽略不计,但我们表明,BC 可以从纯语言设置扩展到视觉语言环境,在两种模式下都实现了最先进的性能。BC 显著提高了 LLM 在快速设计方面的稳健性,我们期待使用 BC 轻松实现快速工程。

致谢

这项工作由 Han Zhou、Xingchen Wan、Lev Proleev、Diana Mincu、Jilin Chen、Katherine Heller 和 Subhrajit Roy 完成。我们感谢 Mohammad Havaei 和 Google Research 的其他同事的讨论和反馈。

评论