大型语言模型 (LLM) 的最新进展非常有前景,这反映在它们在少样本和零样本设置中解决一般问题的能力上,即使没有对这些任务进行明确的训练。这令人印象深刻,因为在少样本设置中,LLM 在给出测试问题之前只会看到一些问答演示。更具挑战性的是零样本设置,其中 LLM只直接被提示测试问题。

尽管少样本设置已大大减少了使模型适应特定用例所需的数据量,但在某些情况下,生成样本提示仍然具有挑战性。例如,对于通用模型涵盖的广泛任务,手工制作少量演示可能很困难,对于从未见过的任务,甚至是不可能的。例如,对于长篇文章摘要或需要领域知识的任务(例如医学问答),生成样本答案可能具有挑战性。在这种情况下,具有高零样本性能的模型很有用,因为不需要手动生成提示。但是,零样本性能通常较弱,因为 LLM 没有提供指导,因此容易出现虚假输出。

在ACL 2023上发表的 “使用自适应提示进行更好的零样本推理”中,我们提出了基于一致性的自适应提示 (COSP)来解决这一困境。COSP 是一种用于推理问题的零样本自动提示方法,它仅使用未标记的样本(通常很容易获得)和模型自己的预测来精心选择和构建LLM 的伪演示。借助 COSP,我们在很大程度上缩小了零样本和小样本之间的性能差距,同时保留了零样本提示的理想通用性。接下来,我们提出了在EMNLP 2023上被接受的“通用自适应提示” (USP),其中我们将这个想法扩展到广泛的一般自然语言理解 (NLU) 和自然语言生成 (NLG) 任务并证明了其有效性。

用自己的成果推动法学硕士 (LLM)

我们知道 LLM 受益于演示,并且至少具有一些零样本能力,因此我们想知道模型的零样本输出是否可以作为模型自我提示的演示。挑战在于零样本解决方案并不完美,我们冒着给 LLM 提供低质量演示的风险,这可能比没有演示更糟糕。事实上,下图显示,在问题中添加正确的演示可以得到测试问题的正确解决方案(带有问题的演示 1),而添加不正确的演示(演示 2 + 问题,带有问题的演示 3)会导致错误答案。因此,我们需要选择可靠的自生成演示。

推理任务的示例输入和输出,说明了需要精心设计上下文演示的选择程序(MultiArith 数据集和 PaLM-62B 模型):(1)没有演示的零样本 思路链 :逻辑正确但答案错误;(2)正确的演示(Demo1)和正确的答案;(3)正确但重复的演示(Demo2)导致重复的输出;(4)错误的演示(Demo3)导致错误的答案;但(5)再次结合 Demo3 和 Demo1 会得到正确的答案。

COSP 利用了 LLM 的一个关键观察结果:自信且一致的预测更有可能是正确的。当然,这一观察结果取决于 LLM 的不确定性估计有多好。幸运的是,在大型模型中,以前的 研究表明不确定性估计是稳健的。由于测量置信度只需要模型预测,而不是标签,我们建议将其用作正确性的零样本代理。然后使用高置信度输出及其输入作为伪演示。

以此为出发点,我们根据模型的自洽性估计模型对其输出的信心,并使用此度量来选择稳健的自生成演示。我们使用零样本思维链(CoT) 提示多次向 LLM 提出相同的问题。为了引导模型生成一系列可能的理由和最终答案,我们加入了由“温度”超参数控制的随机性。在极端情况下,如果模型 100% 确定,它每次都应该输出相同的最终答案。然后,我们计算答案的熵来衡量不确定性——具有高自洽性且 LLM 更确定的答案很可能是正确的,并且会被选中。

假设我们面临一组未标记的问题,COSP 方法是:

将每个未标记的问题输入到 LLM 中,通过多次对模型进行采样来获得多个理由和答案。最常出现的答案会被突出显示,然后给出一个分数,该分数衡量多个采样输出之间的答案一致性(分数越高越好)。除了偏向更一致的答案外,我们还会对答案中的重复(即重复的单词或短语)进行惩罚,并鼓励所选演示的多样性。我们将对一致、不重复和多样化输出的偏好编码为一个评分函数,该函数由三个分数的加权和组成,用于选择自生成的伪演示。

我们将伪演示连接成测试问题,将其输入到 LLM,并得到最终的预测答案。

COSP 说明:在第 1 阶段(左)中,我们多次运行零样本 CoT 以生成一个演示池(每个演示池由问题、生成的理由和预测组成)并分配分数。在第 2 阶段(右)中,我们用伪演示(蓝色框)扩充当前测试问题并再次查询 LLM。对两个阶段的输出进行多数投票形成最终预测。

COSP 专注于具有 CoT 提示的问答任务,由于问题具有唯一的正确答案,因此很容易测量自洽性。但这对于其他任务来说可能很困难,例如开放式问答或没有唯一答案的生成任务(例如文本摘要)。为了解决这一限制,我们引入了 USP,在其中我们将我们的方法推广到其他一般 NLP 任务:

分类(CLS):我们可以使用每个类别的神经网络输出 logit 来计算每个类别的概率的问题。通过这种方式,我们可以通过计算 logit 分布的熵来衡量不确定性,而无需多次采样。

短格式生成(SFG):类似于问答的问题,我们可以使用上面提到的与 COSP 相同的程序,但如果有必要,可以不用生成理由的步骤。

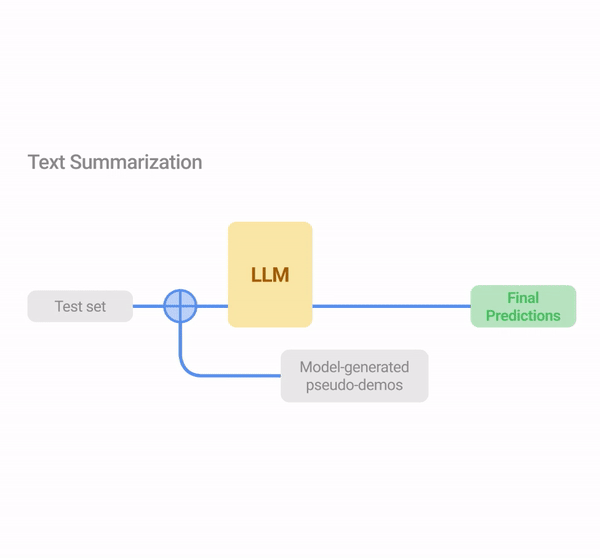

长格式生成(LFG): 摘要和翻译等问题,其中的问题通常是开放式的,即使 LLM 是确定的,输出也不太可能相同。在这种情况下,我们使用重叠度量,其中我们计算同一查询的不同输出之间的成对 ROUGE 分数的平均值。

在示例任务(分类、问答和文本摘要)中说明 USP。与 COSP 类似,LLM 首先在未标记的数据集上生成预测,该数据集的输出根据任务类型使用逻辑熵、一致性或对齐方式进行评分,并从这些输入输出对中选择伪演示。在第 2 阶段,测试实例通过伪演示进行增强以进行预测。

我们根据上述未标记测试样本集上的任务类型计算相关的置信度分数。评分后,与 COSP 类似,我们选择自信、多样且重复性较低的答案来形成模型生成的伪演示集。最后,我们使用这些伪演示以少样本格式再次查询 LLM,以获得整个测试集的最终预测。

主要结果

对于 COSP,我们专注于一组六个算术和常识推理问题,并与 0-shot-CoT(即“让我们一步一步思考”)进行比较。我们在所有基线中使用自洽性,因此它们使用的计算资源量与 COSP 大致相同。通过三个 LLM 进行比较,我们发现零样本 COSP 明显优于标准零样本基线。

使用PaLM-62B、PaLM-540B和GPT-3(code-davinci-001)模型在六种算术( MultiArith、GSM-8K、AddSub、SingleEq)和常识(CommonsenseQA、StrategyQA)推理任务中 COSP 的主要结果。

USP 在 0 次测试中的表现有显著提升。“CLS” 是 15 个分类任务的平均值;“SFG” 是 5 个简短格式生成任务的平均值;“LFG” 是两个摘要任务的平均值。“SFG (BBH)” 是所有 BIG-Bench Hard 任务的平均值,其中每个问题都采用 SFG 格式。

对于 USP,我们将分析范围扩大到更广泛的任务,包括超过 25 种分类、短格式生成和长格式生成任务。使用最先进的 PaLM 2 模型,我们还针对BIG-Bench Hard任务套件进行了测试,此前 LLM 的表现不如人类。我们表明,在所有情况下,USP 的表现都优于基线,并且在使用黄金示例时具有竞争力。

使用 PaLM 2-M 在 BIG-Bench Hard 任务上的准确率(每条线代表套件中的一项任务)。USP(绿色星星)相对于标准 0-shot(绿色三角形)的增益/损失以百分比显示。“Human” 指的是人类的平均表现;“AutoCoT” 和“Random demo” 是我们在论文中比较的基线 ; “3-shot” 是 CoT 格式的三个手工制作的演示的几次表现。

我们还通过验证上述关于置信度和正确性之间关系的关键观察来分析 USP 的工作机制,我们发现在绝大多数情况下,USP 都会选择在所有考虑的任务类型中更有可能更好的置信预测,如下图所示。

USP 会选择更可能更好的置信预测。使用 PaLM-540B 对各种任务类型(蓝色:CLS、橙色:SFG、绿色:LFG)中选定任务的 USP 置信度得分进行真实性能指标评估。

结论

零样本推理是现代 LLM 备受追捧的功能,但要成功实现零样本推理也面临独特的挑战。我们提出了 COSP 和 USP,这是一系列适用于各种任务的多功能零样本自动提示技术。我们在众多任务和模型组合上展示了比最先进的基线大幅改进的效果。

致谢

这项工作由 Xingchen Wan、Ruoxi Sun、Hootan Nakhost、Hanjun Dai、Julian Martin Eisenschlos、Sercan Ö. Arık 和 Tomas Pfister 完成。我们要感谢 Jinsung Yoon Xuezhi Wang 提供的有益评论,以及 Google Cloud AI Research 的其他同事提供的讨论和反馈。

评论