经过大量图像-文本对训练的文本到图像模型已经能够创建丰富多样的图像,涵盖多种类型和主题。此外,当将“动漫”或“蒸汽朋克”等流行风格添加到输入文本提示中时,可能会转化为特定的视觉输出。虽然人们在提示工程方面付出了很多努力,但由于配色方案、照明和其他特征的细微差别,各种风格很难用文本形式描述。例如,“水彩画”可能指各种风格,而使用简单地说“水彩画风格”的文本提示可能会导致一种特定的风格或几种不可预测的混合风格。

当我们提到“水彩画风格”时,我们指的是什么? StyleDrop 无需用自然语言指定风格,而是可以通过参考风格参考图像*来生成风格一致的图像。

在这篇博客中,我们介绍了“ StyleDrop:任意风格的文本到图像生成”,这是一种可以实现更高水平的风格化文本到图像合成的工具。StyleDrop 不会寻找文本提示来描述风格,而是使用一个或多个描述风格的参考图像来生成文本到图像。通过这样做,StyleDrop 能够生成与参考风格一致的图像,同时有效地避免了文本提示工程的负担。这是通过对一些风格参考图像进行适配器调整,有效地微调预先训练的文本到图像生成模型来实现的。此外,通过在其生成的一组图像上迭代微调 StyleDrop,它可以从文本提示中实现风格一致的图像生成 。

方法概述

StyleDrop 是一种文本转图像生成模型,可以生成视觉风格与用户提供的风格参考图像一致的图像。这是通过对预先训练的文本转图像生成模型进行几次参数高效的微调迭代来实现的。具体来说,我们在文本转图像生成视觉转换器 Muse上构建了 StyleDrop。

Muse:文本到图像的生成视觉转换器

Muse是一种基于掩码生成图像转换器 ( MaskGIT )的最先进的文本转图像生成模型。与Imagen或Stable Diffusion等扩散模型不同,Muse 将图像表示为离散标记序列,并使用转换器架构对其分布进行建模。与扩散模型相比,Muse 以速度更快、生成质量更具竞争力而闻名。

参数高效的适配器调整

StyleDrop 是通过在少量风格参考图像及其对应的文本提示上微调预训练的 Muse 模型而构建的。目前已有许多关于 Transformer 参数高效微调的研究,包括提示微调和大型语言模型的低秩自适应(LoRA)。其中,我们选择了适配器微调,事实证明,该微调能够以参数高效的方式有效地微调大型 Transformer 网络以完成语言和图像生成任务。例如,它引入了不到一百万个可训练参数来微调 3B 参数的 Muse 模型,并且只需要 1000 个训练步骤即可收敛。

Muse 的参数高效适配器调整。

带有反馈的迭代训练

虽然 StyleDrop 能够有效地从少量风格参考图像中学习风格,但从单个风格参考图像中学习仍然具有挑战性。这是因为模型可能无法有效地将内容(即图像中的内容)和风格(即呈现方式)区分开来,从而导致生成过程中文本的可控性降低。例如,如下面步骤 1 和 2 中所示,使用 StyleDrop 从单个风格参考图像训练的吉娃娃生成的图像显示出风格参考图像中的内容(即房屋)的泄露。此外,生成的寺庙图像看起来与参考图中的房子太相似(概念崩溃)。

我们通过在用户或图像文本对齐模型(例如CLIP)选择的合成图像子集上训练新的 StyleDrop 模型来解决此问题,这些图像由单幅图像上训练的 StyleDrop 模型的第一轮生成。通过在多幅合成的图像文本对齐图像上进行训练,该模型可以轻松地将风格与内容区分开来,从而实现更好的图像文本对齐。

带反馈的迭代训练*。由于内容风格分离的难度,第一轮 StyleDrop 可能会导致文本可控性降低,例如内容泄漏或概念崩溃。使用由前几轮 StyleDrop 模型生成并由人工或图像文本对齐模型选择的合成图像进行迭代训练,可以提高风格化文本到图像生成的文本一致性。

实验

StyleDrop 画廊

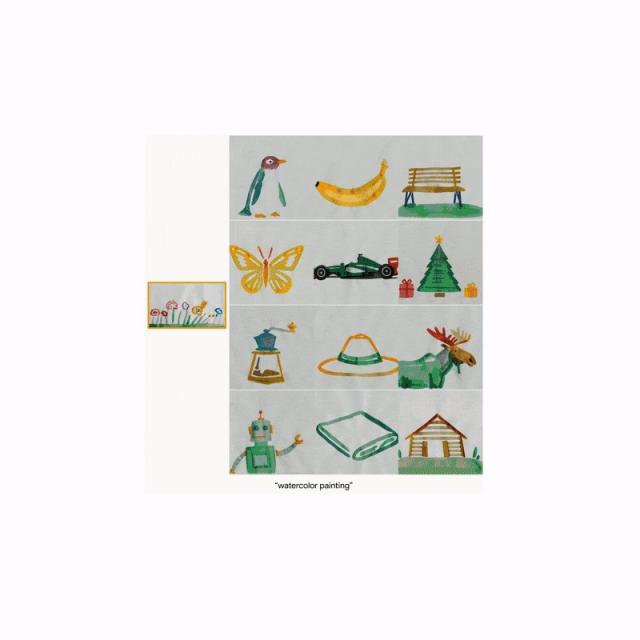

我们通过对 24 张风格各异的参考图像进行实验来展示 StyleDrop 的有效性。如下所示,StyleDrop 生成的图像在风格上彼此高度一致,并且与风格参考图像高度一致,同时描绘了各种情境,例如小企鹅、香蕉、钢琴等。此外,该模型可以以一致的风格渲染字母图像。

风格化的文本到图像生成。风格参考图像*位于黄色框内的左侧。使用的文本提示是:

第一行:一只小企鹅、一根香蕉、一张长凳。

第二行:一只蝴蝶、一辆 F1 赛车、一棵圣诞树。

第三行:一台咖啡机、一顶帽子、一只驼鹿。

第四行:一个机器人、一条毛巾、一间木屋。

风格化视觉字符生成。风格参考图*位于黄色框左侧。使用的文本提示为:(第一行)字母“A”、“字母“B”、“字母“C”,(第二行)字母“E”、“字母“F”、“字母“G”。

按照我的风格生成对象的图像

下面我们展示通过从两个个性化生成分布中采样而生成的图像,一个用于对象,另一个用于风格。

蓝色边框内的上方图像是 DreamBooth 数据集中的物体参考图(茶壶、花瓶、狗和猫),红色边框内的左下方图像是风格参考图*。紫色边框内的图像(即右下方四张图像)是从特定物体的风格图像生成的。

定量结果

对于定量评估,我们从Parti 提示子 集中合成图像,并测量图像到图像的 CLIP 分数以评估风格一致性,以及图像到文本的 CLIP 分数以评估文本一致性。我们研究了 Muse 和 Imagen 的非微调模型。在微调模型中,我们将其与DreamBooth on Imagen(针对受试者的最先进的个性化文本到图像方法)进行了比较。我们展示了两个版本的 StyleDrop,一个是从单一风格参考图像训练出来的,另一个是“StyleDrop (HF)”,它使用合成图像和如上所述的人工反馈进行迭代训练。如下所示,StyleDrop (HF) 的风格一致性得分显著高于其非微调版本(0.694 vs. 0.556),也高于 DreamBooth on Imagen(0.694 vs. 0.644)。我们观察到 StyleDrop (HF) 的文本一致性得分高于 StyleDrop(0.322 vs. 0.313)。此外,在对 Imagen 上的 DreamBooth 和 Muse 上的 StyleDrop 进行人类偏好研究中,我们发现,在与风格参考图像的一致性方面,86% 的人类评分者更喜欢 Muse 上的 StyleDrop,而不是 Imagen 上的 DreamBooth。

结论

StyleDrop 使用少量风格参考图像,在文本到图像生成过程中实现风格一致性。Google 的 AI 原则指导了我们开发 Style Drop,我们敦促负责任地使用这项技术。StyleDrop 经过改编,可在 Vertex AI 中创建自定义风格模型,我们相信它可以成为艺术总监和平面设计师的有用工具 — 他们可能希望以自己的风格集思广益或制作视觉资产原型,以提高生产力和增强创造力 — 或者希望生成反映特定品牌的新媒体资产的企业。与其他生成性 AI 功能一样,我们建议从业者确保他们使用的任何媒体资产的版权一致。更多结果请访问我们的项目网站和YouTube 视频。

致谢

这项研究由 Kihyuk Sohn、Nataniel Ruiz、Kimin Lee、Daniel Castro Chin、Irina Blok、Huiwen Chang、Jarred Barber、Lu Jiang、Glenn Entis、Yuanzhen Li、Yuan Hao、Irfan Essa、Michael Rubinstein 和 Dilip Krishnan 进行。我们感谢实验中使用的图片所有者(链接用于注明出处)分享了他们的宝贵资产。

评论