普渡大学的一组计算机科学家发现,流行的法学硕士课程 ChatGPT 在回答计算机编程问题时非常不准确。在他们发表于CHI 计算机系统人为因素会议论文集的论文中,该小组描述了他们如何从 StackOverflow 网站提取问题并将其提交给 ChatGPT,然后测量其回答的准确度。

该团队还在 5 月 11 日至 16 日举行的计算机系统人为因素会议(CHI 2024)上展示了他们的研究成果。

ChatGPT 和其他 LLM 最近频频出现在新闻中——自从这些应用程序向公众开放以来,它们变得非常受欢迎。不幸的是,这些应用程序给出的许多答案虽然包含大量有用的信息,但也存在大量不准确之处。更不幸的是,这些应用程序给出的答案有时并不清楚。

在这项新研究中,普渡大学的团队指出,许多编程学生已经开始使用法学硕士,不仅帮助编写编程作业的代码,还回答与编程相关的问题。例如,学生可以问 ChatGPT,冒泡排序和归并排序有什么区别,或者更通俗地说,什么是递归?

为了了解法学硕士回答这些问题的准确率,研究团队将精力集中在其中的一个问题上——ChatGPT。为了找到用于测试应用程序的问题,研究人员使用了 StackOverflow 网站上免费提供的问题——该网站旨在帮助程序员通过与自己感兴趣领域的其他人合作来学习更多关于编程的知识。在该网站的一个部分,用户可以发布问题,其他知道答案的人会回答这些问题。

研究团队使用了网站上的 517 个问题,然后测量了 ChatGPT 给出正确答案的频率。这项研究主要涉及使用 ChatGPT 免费版中提供的 GPT-3.5 模型手动回答 517 个问题,并利用 GPT-3.5-turbo API 对另外 2,000 个问题进行更大规模的自动处理。数据收集于 2023 年 3 月进行。遗憾的是,只有 52% 的时间是正确的。他们还发现,与向人类专家提出同样的问题相比,答案往往更为冗长。研究人员还将性能与 GPT-4 模型进行了比较。GPT-4 模型的表现略好于 GPT-3.5,它正确回答了 GPT-3.5 回答错误的 21 个随机选择的问题中的 6 个,但它仍然产生了大多数错误答案(21 个中的 15 个)。

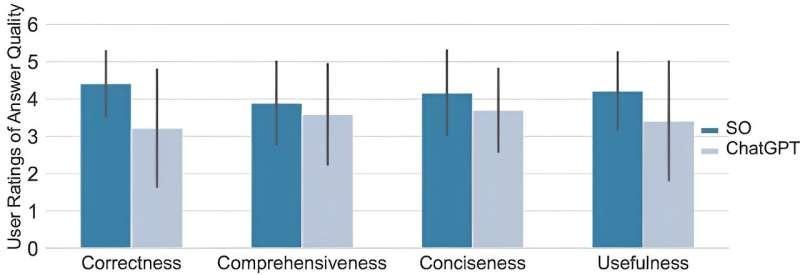

令人震惊的是,研究团队发现,用户研究参与者 35% 的时间更喜欢 ChatGPT 给出的答案。研究人员还发现,阅读 ChatGPT 给出的答案的同一批用户往往没有发现所犯的错误——他们 39% 的时间都忽略了错误答案。

本站全部资讯来源于实验室原创、合作机构投稿及网友汇集投稿,仅代表个人观点,不作为任何依据,转载联系作者并注明出处:https://www.lvsky.net/258.html

评论