人工智能模型总是让我们感到惊讶,不仅仅是它们能做什么,还有它们不能做什么以及原因。这些系统有一种有趣的新行为,既表面化又具有启发性:它们像人类一样随机选择数字,也就是说,它们选择得很糟糕。

但首先,这到底是什么意思?人们不能随机选择数字吗?你怎么知道一个人这样做是否成功?这实际上是我们人类的一个非常古老且众所周知的局限性:我们过度思考和误解随机性。

让一个人预测 100 次抛硬币结果,并将其与 100 次实际抛硬币结果进行比较——你几乎总能区分它们,因为与直觉相反,真正的抛硬币结果看起来不那么随机。例如,通常会有六七次连续出现正面或反面,而几乎没有人类预测者会将这种情况纳入他们的 100 次预测中。

当你让某人在 0 到 100 之间选择一个数字时,情况也是如此。人们几乎从不选择 1 或 100。5 的倍数很少见,像 66 和 99 这样有重复数字的数字也很少见。这些对我们来说似乎不是“随机”选择,因为它们体现了一些品质:小、大、独特。相反,我们经常选择以 7 结尾的数字,通常是从中间某个地方。

心理学中这种可预测性的例子不胜枚举。但当人工智能做同样的事情时,这并没有减少它的怪异性。

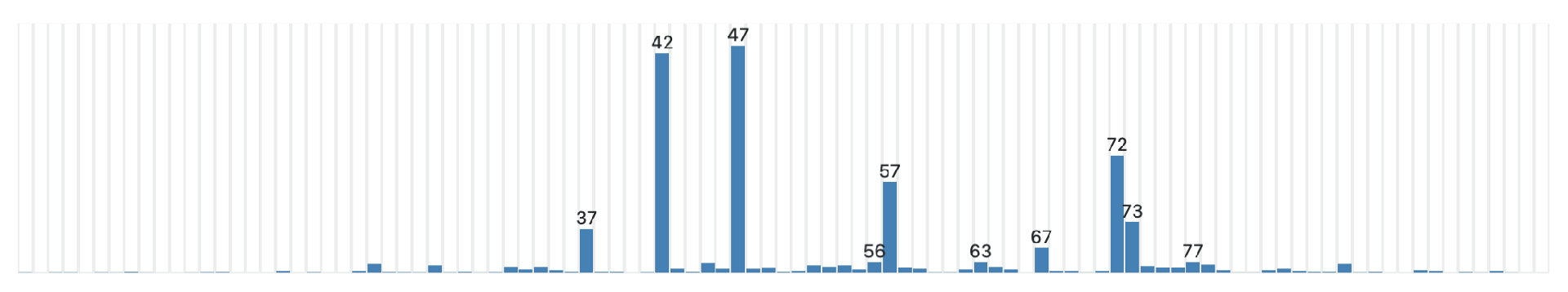

是的,Gramener 的一些好奇的工程师进行了一项非正式但令人着迷的实验,他们只是要求几个主要的 LLM 聊天机器人随机选择一个介于 0 到 100 之间的数字。

读者,结果并不是随机的。

图片来源: Gramener

所测试的所有三个模型都有一个“最喜欢的”数字,当置于最确定性的模式下时,这个数字始终是它们的答案,但即使在较高的“温度”下也会出现最频繁的数字,模型通常具有这种设置,这会增加其结果的变化。

OpenAI 的 GPT-3.5 Turbo 非常喜欢 47。此前,它喜欢 42——这个数字当然是由道格拉斯·亚当斯在《银河系漫游指南》中提出的,它是生命、宇宙和一切的答案。

Anthropic 的 Claude 3 Haiku 得分为 42。而 Gemini 得分为 72。

更有趣的是,即使在高温下,这三个模型在选择的其他数字时都表现出类似人类的偏见。

所有人都倾向于避免使用过低或过高的数字;克劳德从未超过 87 或低于 27,甚至那些都是异常值。他们小心翼翼地避免使用两位数:没有 33、55 或 66,但出现了 77(以 7 结尾)。几乎没有整数——不过双子座曾经在最高温度时疯狂地选择了 0。

为什么会这样?人工智能不是人类!他们为什么要关心“看似”随机的事情?他们终于实现了意识,这就是他们展示意识的方式吗?!

不。答案是,就像通常的情形一样,我们拟人化得太过了。这些模型并不关心什么是随机的,什么不是随机的。它们不知道什么是“随机性”!它们回答这个问题的方式和回答其他所有问题的方式一样:通过查看训练数据并重复在看起来像“选择一个随机数”的问题后面最常写的内容。出现的频率越高,模型重复的频率就越高。

如果几乎没有人会这样回答,那么在他们的训练数据中,他们会在哪里看到 100?就人工智能模型所知,100 并不是这个问题的可接受答案。由于没有实际的推理能力,也完全不理解数字,它只能像随机鹦鹉一样回答问题。(同样,它们往往无法完成简单的算术,比如将几个数字相乘;毕竟,在他们的训练数据中出现短语“112*894*32=3,204,096”的可能性有多大?不过,较新的模型会识别出存在数学问题并将其踢入子程序。)

这是 LLM 习惯以及它们表现出的人性的一个实例。在与这些系统的每次互动中,人们必须记住,它们已被训练成像人类一样行事,即使这不是它们的本意。这就是为什么伪人类行为如此难以避免或预防。

我在标题中写道,这些模型“认为自己是人”,但这有点误导。正如我们经常指出的那样,它们根本不会思考。但在它们的反应中,它们始终在模仿人类,根本不需要知道或思考。无论你向它询问鹰嘴豆沙拉食谱、投资建议还是随机数,过程都是一样的。结果让人感觉很人性化,因为它们是人类的,直接从人类制作的内容中提取并重新混合——为了你的方便,当然也为了大人工智能的底线。

本站全部资讯来源于实验室原创、合作机构投稿及网友汇集投稿,仅代表个人观点,不作为任何依据,转载联系作者并注明出处:https://www.lvsky.net/234.html

评论