强化学习(RL) 已被证明可有效解决从围棋、 星际争霸和我的宇宙到机器人运动和芯片设计等众多复杂问题。在每种情况下,都可以使用模拟器,或者可以快速且廉价地访问真实环境。然而,将 RL 部署到现实世界的产品和系统中仍然存在相当大的挑战。例如,在机器人和自动驾驶等物理控制系统中,RL 控制器经过训练可解决抓取物体或在高速公路上驾驶等任务。这些控制器易受传感器噪声、系统延迟或正常磨损等影响,从而降低控制器输入的质量,导致错误的决策和潜在的灾难性故障。

物理控制系统:在X的Everyday Robot Project中,机器人学习如何使用 RL 抓取和分类物体。这些类型的系统面临着本文详述的许多现实挑战。

在“现实世界强化学习的挑战”中,我们确定并讨论了阻碍当前强化学习算法应用于应用系统的九种不同挑战。然后,我们通过实证调查跟进这项工作,在最先进的强化学习算法上模拟了这些挑战的版本,并对每个挑战的效果进行了基准测试。我们在现实世界强化学习(RWRL) 任务套件中开源了这些模拟挑战,以帮助引起人们对这些重要问题的关注,并加速解决这些问题的研究。

RWRL 套件

RWRL 套件是一组受应用强化学习挑战启发的模拟任务,其目标是让研究人员和从业者能够快速进行算法迭代,而无需在真实系统上运行缓慢、昂贵的实验。虽然从模拟中训练的 RL 算法过渡到真实世界的应用会面临更多挑战,但该套件旨在弥补一些更基本的算法差距。目前,RWRL 支持DeepMind Control Suite域的子集,但目标是扩大套件以支持更加多样化的域集。

易于使用且灵活

我们在设计该套件时主要考虑了两个目标。 (1) 它应该易于使用 — 用户应该能够在下载套件几分钟内开始运行实验,只需更改几行代码即可。 (2) 它应该灵活 — 用户应该能够毫不费力地将任何挑战组合纳入环境中。

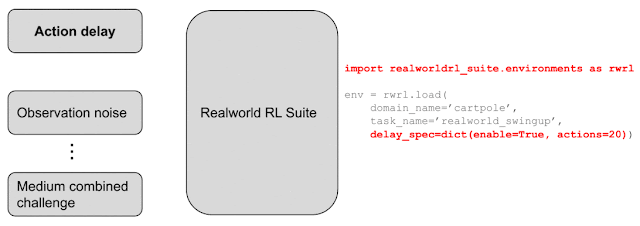

延迟动作示例

为了说明 RWRL 套件的易用性,假设研究人员或从业者想要实现动作延迟(即,将动作发送到环境的时间延迟)。要使用 RWRL 套件,只需导入模块即可rwrl。接下来,使用参数加载环境(例如 cartpole)delay_spec。此可选参数指定为字典,用于配置应用于动作、观察或奖励的延迟以及相应元素延迟的时间步数(例如,20 个时间步)。加载环境后,动作的效果会自动延迟,而无需对实验进行任何其他更改。这使得在 RWRL 套件支持的一系列不同环境中测试具有动作延迟的 RL 算法变得容易。

RWRL 套件的高级概述。使用几行代码将挑战(例如,动作延迟)添加到环境中,运行超参数扫描并生成右侧显示的图表

用户可以通过向加载函数添加额外参数来组合不同的挑战或从一组预定义的基准挑战中进行选择,所有这些参数均在开源 RWRL 套件代码库中指定。

支持的挑战

RWRL 套件提供与九种不同挑战中的八种相关的实验相关的功能,这些挑战使得当前 RL 算法难以应用于应用系统:样本效率;系统延迟;高维状态和动作空间;约束;部分可观测性、随机性和非平稳性;多个目标;实时推理;以及离线日志训练。RWRL 不包括可解释性挑战,该挑战抽象且难以定义。支持的实验并不详尽,并为研究人员和从业者提供了分析其代理在每个挑战维度上的能力的能力。支持的挑战示例包括:

系统延迟

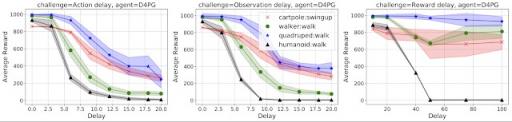

大多数实际系统在感知、驱动或奖励反馈方面都会有延迟,所有这些都可以配置并应用于 RWRL 套件中的任何任务。下图显示了D4PG代理在动作(左)、观察(中)和奖励(右)越来越延迟的情况下的性能。

分别增加动作(左)、观察(中)和奖励(右)延迟对四个MuJoCo域中最先进的 RL 代理的影响。

从图中可以看出,研究人员或从业者可以快速了解哪种类型的延迟会影响其代理的性能。这些延迟也可以组合在一起以观察它们的综合效果。

约束

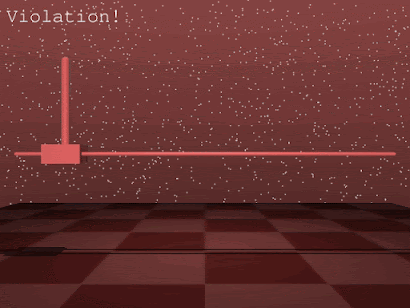

几乎所有应用系统都将某种形式的约束嵌入到总体目标中,这在大多数 RL 环境中并不常见。RWRL 套件为每个任务实施了一系列约束,难度各不相同,以促进受限 RL 的研究。下面的视频直观地展示了违反复杂局部角速度约束的示例。

违反 cartpole 约束的示例。红色屏幕表示局部角速度发生违规。

非平稳性

用户可以通过扰动环境参数来引入非平稳性。这些扰动与最近在监督式深度学习研究中流行的像素级对抗性扰动形成对比。例如,在人类步行者领域,可以在整个训练过程中修改头部的大小和地面的摩擦力,以模拟不断变化的条件。RWRL 套件中提供了各种调度程序(有关更多详细信息,请参阅我们的代码库),以及多个默认参数扰动,这些扰动经过精心定义,以阻碍最先进的学习算法的学习能力。

非平稳扰动。该套件支持在各个情节中扰动环境参数,例如改变头部大小(中间)和接触摩擦(右)。

使用离线日志数据进行训练

在大多数应用系统中,运行实验既慢又昂贵。通常有来自先前实验的数据日志可用于训练策略。但是,由于数据有限、方差低或质量差,在生产中通常很难超越之前的模型。为了解决这个问题,我们生成了组合 RWRL 基准挑战的离线数据集,并将其作为更广泛的离线数据集发布的一部分提供。更多信息可以在此笔记本中找到。

结论

大多数系统很少只表现出单一挑战,我们很高兴看到算法如何应对存在多个挑战且难度不断增加的环境(“简单”、“中等”和“困难”)。我们强烈鼓励研究界尝试解决这些挑战,因为我们相信解决这些挑战将促进 RL 在产品和现实世界系统中的更广泛应用。

虽然 RWRL 套件的初始功能和实验为缩小 RL 现状与应用系统挑战之间的差距提供了一个起点,但仍有许多工作要做。支持的实验并不详尽,我们欢迎来自更广泛社区的新想法,以更好地评估我们的 RL 代理的功能。我们推出此套件的主要目标是突出和鼓励对限制 RL 算法在应用产品和系统中的有效性的核心问题进行研究,并加快实现未来 RL 应用的进程。

致谢

我们想感谢核心贡献者和合著者 Nir Levine 提供的宝贵帮助。我们还要感谢合著者 Jerry Li、Sven Gowal、Todd Hester 和 Cosmin Paduraru 以及 Robert Dadashi、ACME 团队、Dan A. Calian、Juliet Rothenberg 和 Timothy Mann 的贡献。

评论